「AI事業者ガイドライン」から読み解くAI利用時のセキュリティ対策

2025年3月28日に総務省と経済産業省が公開した「AI事業者ガイドライン(第1.1版)」。そこに示された基本理念や方針を概観しながら、AI関連のセキュリティリスクと技術的対策について解説します。

「AI事業者ガイドライン」とは?

「AI事業者ガイドライン(第1.0版)」は2024年4月19日、経済産業省および総務省により公表されました。2025年3月28日には、情報を更新した第1.1版が公開されています。

AI事業者ガイドライン(以下、ガイドライン)では、その位置づけ、目指すもの、特徴などを以下のように述べています。

●日本におけるAIガバナンスの統⼀的な指針や、AI開発・提供・利⽤にあたって必要な取組についての基本的な考え⽅を示す。

●事業活動においてAIを活⽤する者が、国際的な動向およびステークホルダーの懸念を踏まえたAIのリスクを正しく認識し、必要となる対策をAIのライフサイクル全体で⾃主的に実⾏できるように後押しする。

●AIがもたらす社会的リスクの低減を図るとともに、AIのイノベーションおよび活⽤を促進していくために、関係者による⾃主的な取組を促し、⾮拘束的なソフトローによって⽬的達成に導く。

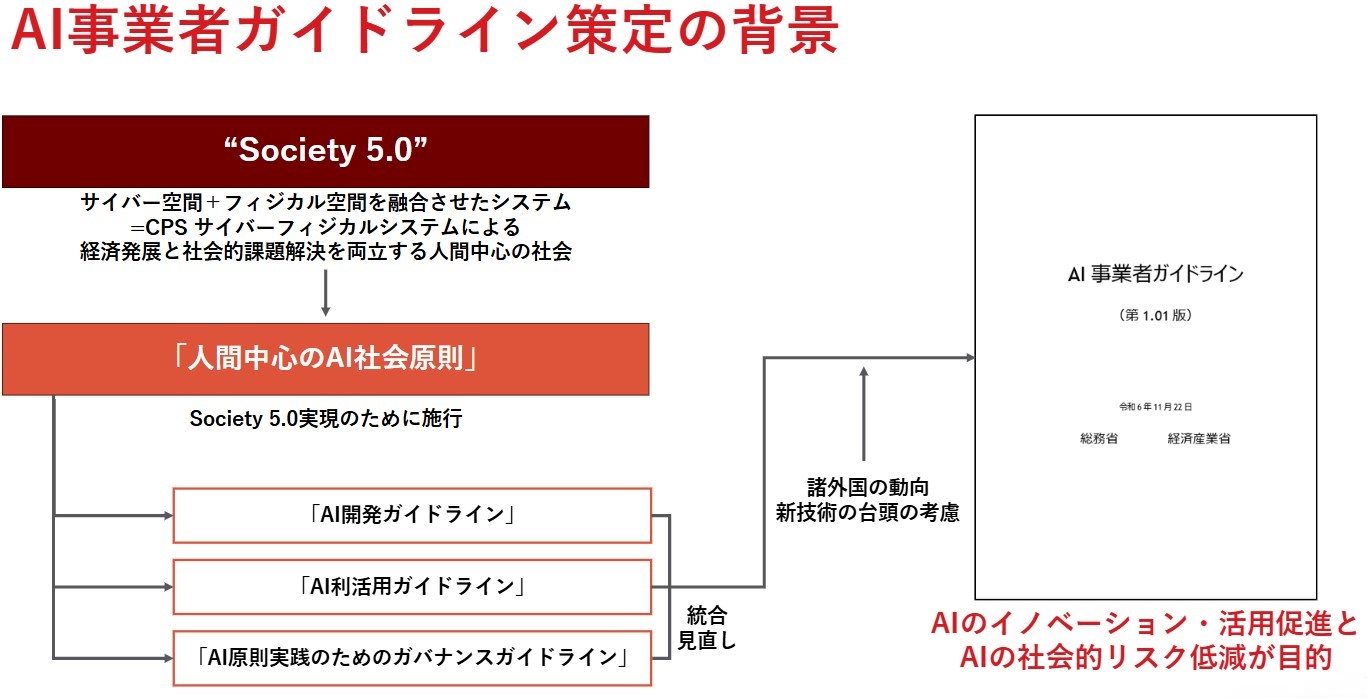

また、ガイドライン作成の背景には、①「Society 5.0」を実現するための「人間中心のAI社会原則」、②これまでに策定・公表された複数ガイドラインの統合・見直し+諸外国の動向・新技術、があります。

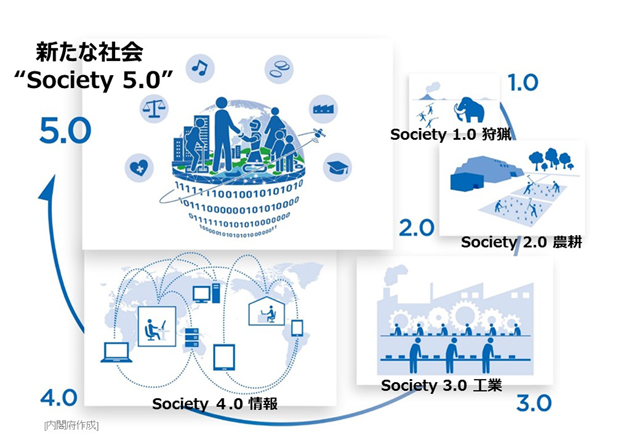

①の「Society 5.0」とは、日本政府が提唱する未来社会のコンセプトです。狩猟社会(Society 1.0)、農耕社会(Society 2.0)、工業社会(Society 3.0)、情報社会(Society 4.0)に続く新たな社会で、「サイバー空間とフィジカル空間を高度に融合させたシステムにより、経済発展と社会的課題の解決を両立する人間中心の社会」です。このコンセプトの実現にあたり、AIが社会に受け入れられ、適切に利用されるために策定されたのが「⼈間中⼼のAI社会原則」(2019年3月29日)です。ガイドラインはこの原則を土台にしています。

図:Society 1.0からSociety 5.0への変遷イメージ(内閣府「Society 5.0とは」)

また、②統合・見直しが行われた複数のガイドラインには、総務省主導の「国際的な議論のためのAI開発ガイドライン案」、「AI利活⽤ガイドライン〜AI利活⽤のためのプラクティカルリファレンス〜」、および経済産業省主導の「AI原則実践のためのガバナンス・ガイドラインVer. 1.1」が挙げられます。

この3つのガイドラインは、上記の「⼈間中⼼のAI社会原則」を実現するために具体的に行うべきことをまとめたものです。

| 対象者(「主体」と呼ぶ) | 定義 | 担う役割 |

|---|---|---|

| AI開発者 (AI Developer) |

AIシステムを開発する事業者 (研究開発事業者を含む) |

・AIモデル・アルゴリズムの開発 ・データ収集、前処理 ・AIモデル学習および検証を通してAIモデル、AIモデルのシステム基盤、⼊出⼒機能等を含むAIシステムを構築 |

| AI提供者 (AI Provider) |

AIシステムをアプリケーション、製品、既存のシステム、ビジネスプロセス等に組み込んだサービスとしてAI利⽤者(AI Business User)などに提供する事業者 | ・AIシステム検証 ・他システムとの連携の実装 ・AIシステム・サービスの提供、運⽤、運⽤サポート |

| AI利⽤者 (AI Business User) |

事業活動において、AIシステムまたはAIサービスを利⽤する事業者 | ・提供されたAIシステムの運⽤ |

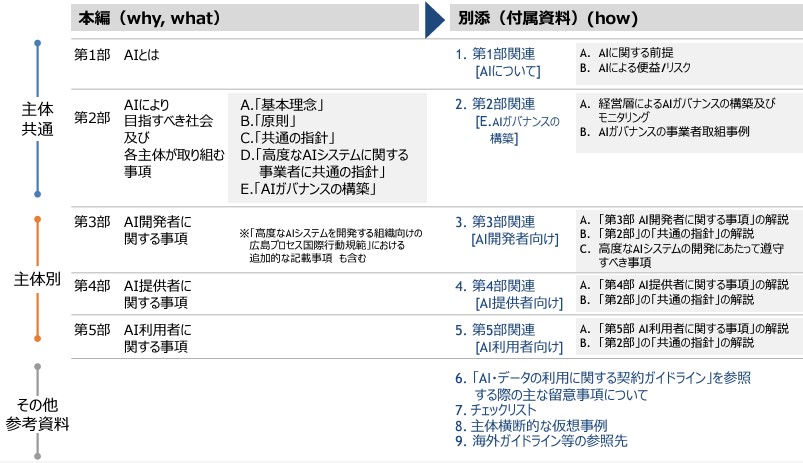

ガイドラインの構成:本編と別添(付属文書)

ガイドラインは本編と別添で構成されています。それぞれの内容構成を見ていきます。

上記の3主体それぞれの立場から、次の各項目を確認・実践することが、AIの安全安⼼な活⽤に有⽤とされています。

①「ステークホルダーからの期待を鑑みつつどのような社会を⽬指すのか(基本理念 = why)」を踏まえる。そのうえで、

②「AIに関しどのような取組を⾏うべきか(指針 = what)」を明らかにすることが重要。

③②の指針を実現するために「具体的にどのようなアプローチで取り組むか(実践 = how)」を検討・決定し、実践。

これらの基本理念 = why、指針 = what、実践 = howは、次の構成で記載されています。

基本理念(why)

続いて、どのような社会を⽬指すのかを表している「基本理念」= why を見ていきましょう。

ガイドラインでは、「⼈間中⼼のAI社会原則」が挙げる次の3つの価値を「基本理念」として尊重し、踏襲しています(それぞれの説明はトレンドマイクロにて整理)。

① ⼈間の尊厳が尊重される社会(Dignity)

AIに過度に依存したり、AIが人間をコントロールしたりするのではなく、人間がAIを使いこなすことにより、人間の能力をさらに発揮し、物質的・精神的に豊かな生活を送ることができる社会を構築する必要がある

② 多様な背景を持つ人々が多様な幸せを追求できる社会(Diversity and Inclusion)

包摂的かつ新たな価値を創造できる社会という理想に近づくにあたり、AIは有力な道具となり得る。AIの適正な開発と展開により、このように社会の在り方を変革していく必要がある

③ 持続可能な社会(Sustainability)

社会の格差解消、地球規模の環境問題、気候変動などにも対応可能な持続性ある社会の構築が必要であり、それに対し日本は、科学・技術立国としての知見の蓄積をAIによって強化し、貢献する責務がある

これらの理念を実現するに当たり、必要となる指針が挙げられています。

指針(what)

まず、AI開発者、AI提供者、AI利⽤者すべてが取り組むべき「共通の指針」は次の10項目です(それぞれの説明はトレンドマイクロにて整理)。

このうち1)~7)は各主体が取り組む事項、8)~10)は社会と連携した取組が期待される事項です。

1) 人間中心

AIが生成した偽情報・誤情報・偏向情報により、人間の意思決定や感情が操作されるリスクを認識し、対策を講じる。社会的弱者のAI活用が容易になるよう配慮する。

2) 安全性

人間の生命・身体・財産、精神および環境に配慮する。AIの学習データに対する正確性・透明性・遵法性を確保する。

3) 公平性

AIシステム・サービスの開発・提供・利用において、人種、性別、国籍、年齢、政治的信念、宗教等の背景を理由とした、特定の個人ないし集団への不当で有害な偏見および差別をなくすよう努める。

4) プライバシー保護

個人情報保護法等の関連法令の遵守などにより、ステークホルダーのプライバシーを尊重、保護し、必要な対策を取る。

5) セキュリティ確保

AIシステム・サービスの機密性・完全性・可用性を維持するための対策を取る。AIシステム・サービスに対する外部からの攻撃や、それらのリスクに対応するための留意事項など、最新動向に注意を払う。

6) 透明性

AIシステム・サービスの検証可能性を確保する。ステークホルダーに適切な情報提供を行う。これには、AIを利用しているという事実や、活用範囲、AIシステム・サービスの限界などを含む。

7) アカウンタビリティ

AIシステム・サービスの開発・提供・利用中に行われた意思決定等について、追跡・遡求が可能な状態を確保する。AIシステム・サービスの利用に伴うリスク管理、安全性確保のための各主体のAIガバナンスに関するポリシー、プライバシーポリシー等の方針を策定し、公表する。

8) 教育・リテラシー

各主体でAIに関わる者が、AIを正しく理解し、正しく利用できる知識・リテラシー・倫理感を持つために、必要な教育を行う。ステークホルダーに対しても必要に応じて教育機会を提供する。

9) 公正競争確保

AIを活用した新たなビジネス・サービスが創出され、持続的な経済成長の維持及び社会課題の解決策の提示がなされるよう、AIをめぐる公正な競争環境が維持に努めることが期待される

10) イノベーション

オープンイノベーション等を推進し、他のAIシステム・サービスとの相互接続性及び相互運用性を確保する。

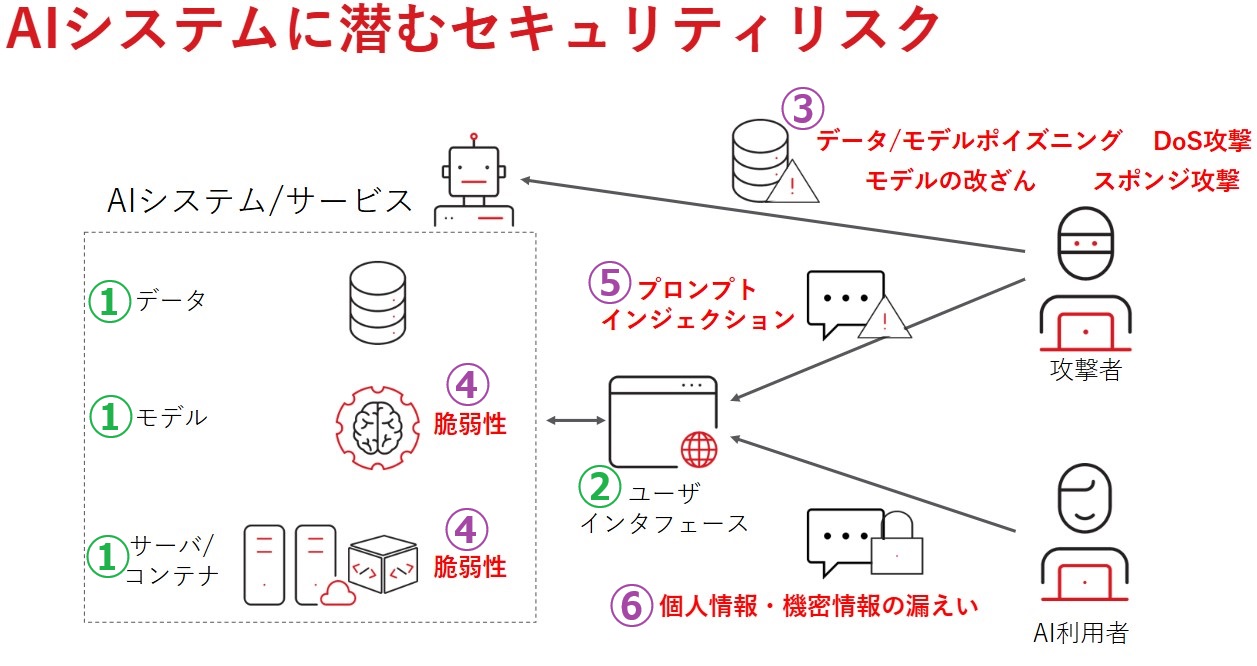

AIシステム・サービスの環境は次のような構成が多いでしょう。

② AI利用者は、ユーザインタフェースを介してAIシステム・サービスにアクセスし、プロンプトを入力したりAIからのレスポンスを得たりします。

このような環境に対するセキュリティリスクには次のような点が考えられます。

④ 攻撃者は、AIシステムのインフラや環境自体の脆弱性を突いた攻撃を行うことも考えられます。

⑤ 攻撃者が、AIの持つ機密情報や不適切な回答を引き出す目的で、AIへのプロンプトをたくみに使うプロンプトインジェクションを行うことが考えられます。通常のAIモデルでは「ガードレール」が開発者により施されており、たとえば爆弾やマルウェアの作り方などの犯罪を助長するようなプロンプトや、機密情報などを聞き出そうとするようなプロンプトには応じません。プロンプトインジェクションは、開発者側が意図していない挙動をAIに起こさせるようなプロンプトを入力し、本来禁じられている情報を生成させる攻撃です。

⑥ 利用者側でも、AIへのプロンプトに個人情報や機密情報を含めてしまった結果、漏洩につながることがあります。

上記の③④は、システムの誤作動・停止につながり、AIシステム・サービスの可用性と完全性に影響が及びます。

⑤⑥は情報漏洩につながり、機密性が損なわれる可能性があります。

いずれの場合も、AIシステム・サービスの存続を揺るがすような事態に陥りかねません。リスクは開発段階にも利用段階にもあることがわかります。AI開発者、AI提供者、AI利⽤者のすべてに共通する取り組みとして「セキュリティ確保」が挙げられている理由は、ここにあると言えるでしょう。

また、ガイドライン別添の「AIによるリスク」のセクションで、セキュリティリスクも含めた様々なリスクを実例とともに挙げています。非常に具体的でイメージをつかみやすいですので、一読をおすすめします。

トレンドマイクロが提供するソリューションとは?

現在、AI開発者やAI提供者の数は限られるかもしれませんが、ほとんどの方がAI利用者であると言っても過言ではないでしょう。ガイドラインでは、AI利用者に対して、AI提供者によるセキュリティ上の留意点を遵守することと、機密情報などを入力しないよう注意することが重要と述べています。

「AIを利用する際に個人情報や機密情報を入力しないように留意する」。これは、一見簡単そうに見えるかもしれません。しかし、組織内の全員に周知徹底するのは、非常に困難だと考えられます。

2025年4月に公表された、12か国の約2,600人のプライバシーおよびセキュリティの専門家を対象とした調査では、回答者の半数近くが、従業員の個人情報や非公開データを生成AIツールに入力していることを認めているという、驚くような結果が出ています。

専門家ですらそのような状態ですから、リテラシーやリスク認識の度合いが様々な一般従業員においては、なおさら徹底は難しいでしょう。ルール作成と従業員教育は必須ですが、個人の良識や判断にゆだねることには限界があるのです。そこで、技術的対策もあわせて取っていくことで、意図しない情報漏洩を防ぎ、セキュリティを強化することができます。

トレンドマイクロでは、生成AIサービスへのサイバー攻撃や情報漏洩を防ぐ「Trend Vision One - Zero Trust Secure Access - AI Service Access™ 」を提供しています(以下、AI Service Access)。

AI Service Accessでは、パブリックの生成AIサービス(2025年4月時点ではChatGPT、Microsoft Copilot、Gemini、Amazon Bedrock)だけでなく、組織が利用・提供するプライベートな生成AIサービスの両方をサポートし、次の機能を提供しています。

●アクセス制御

●プロンプトフィルタリング

●プロンプトインジェクション防止

●レスポンスフィルタリング

このうち、プロンプトフィルタリングの例を、実際の画面とあわせて紹介します。

たとえば人事部の従業員が、従業員名簿を作成するために個人情報を生成AIに入力し、「表形式にしてください」と伝えるとします。ChatGPTでこのようなプロンプトを実行した場合、「機密性の高い情報は共有しないでください。(中略)弊社のモデルの学習に使用される場合があります」と注意喚起は行いますが、技術的対策を取っていなければ、左の画面のようにレスポンスで表を返してきます。ここで、入力した個人情報が生成AIのベンダーにわたってしまっています。

一方、AI Service Accessで設定をしておくと、同じプロンプトを入力しても、右側の画面にあるようにブロックされるためベンダーにわたることはありません。

本記事で紹介した「AI事業者ガイドライン」、ならびに「Trend Vision One - Zero Trust Secure Access - AI Service Access」については、以下のウェビナーでもご覧いただけます。ウェビナーではTrend Vision Oneのデモ画面もお見せしていますので、ぜひご覧ください。

Security GO新着記事

時事通信社のサイバーセキュリティ最前線~「知る」を支えるデジタル基盤を守るには?

(2026年2月13日)

LLMとSLMは何が違う?AIの規模、制御、そしてリスク

(2026年2月12日)

社長を騙りLINEに誘導する「CEO詐欺」の手口を解説

(2026年2月6日)