AIガバナンスの動向は?各国のAI法規制を概観

日本政府が生成AIに関する法規制の必要性を検討するという報道の中、2025年2月からEU AI法の一部が適用開始となります。EU AI法はどのようなものか、また他の国や地域にはどのようなAI関連の法規制があるのかを解説します。

公開日:2024年12月4日

更新日:2024年12月20日

AIの開発が急速に進むなか、各組織でAIを利用するのかどうかや、利用する場合には対象の業務、導入するAIの種類、導入方法など、様々な観点で情報収集や検討を進めていることと思います。その過程で、AIの利用には良い面ばかりではなく、セキュリティや倫理などで負の側面もあることに気づき、不安に思う方も多いでしょう。AI関連のリスクについては当メディアでもたびたび取り上げてきています。

-------------------

2024年12月20日追記

2024年12月19日、日本政府が検討している生成AIに関する法案の概要についての報道がありました(朝日新聞デジタル)。報道内容によれば、法案では日本政府が生成AIに関係する悪質な事例や安全性について調査・情報収集を行うこととし、同時にAIを開発・活用する事業者に指導・助言・情報提供をするとのことです。加えて、これらの事業者には政府への協力を責務として課すことを定める、とされています。欧米で進むAI規制の動きを受けて、国内でも法案整備の必要性の議論が進むことが予想されます。

-------------------

参考記事:

・生成AIのビジネス活用と考慮すべきリスク

・AI TRiSM(エーアイトリズム)とは何か?~AI時代に必要なフレームワーク~

・生成AIとセキュリティ

AIの開発や利用におけるリスクを注視しているのは、様々な国や地域の政府も同様です。本記事では、いくつかの国や地域で採択ないし施行されたAI関連の法規制を取り上げます。そのなかには、当該国・地域内の法人組織だけでなく、そこにサービスやシステムを展開する組織も対象となるものもあります。日本の組織においても、内容の理解や、必要に応じて対応方法などを検討していく必要があります。

EU AI法(EU AI Act)

欧州委員会は、EUのAIへのアプローチは「卓越性と信頼性を中心に据え、安全性と基本的権利を確保しながら研究と産業の能力を高めることを目指す」ものと表明しています。そしてEUのAI戦略は、EUを世界クラスのAIハブにし、AIが確実に人間中心で信頼できるものにすることを目指すとしています。欧州委員会が2021年4月に発表した、信頼できるAIの開発を支援するための幅広い政策パッケージの一部が「EU AI法」です。同法は2024年3月13日に欧州議会にて採択されました。

EU AI法は包括的で非常に詳細に規定されています。AIがもたらすと予想される損害や不利益を防ぐために、EUが事前に取り組んでいることが伺えます。一方、その複雑さのために、自組織の対処方法や受ける影響などの確認が困難となり得ます。また、ここでは詳述しませんが、違反した場合の罰則が厳しく設定されていることも無視できません。

さらに、規制が厳しいゆえのイノベーションを抑制する可能性も指摘されています。

EU AI法の対象者

同法は、EU域内に所在するかどうかにかかわらず、AIシステム・サービスをEU内に提供したり、輸入したり、販売したりするなどの事業者にも適用されるため、AIシステム・サービス自体を開発していなくともその流通に関わる日本の法人組織にとっても注意が必要です。

(a)EU内でAIシステムを市場に投入またはサービス提供するプロバイダ、または汎用AIモデルを市場に投入するプロバイダ(当該プロバイダがEU内または第三国に所在するかに関わらず)

(b)EU内に所在するAIシステムの導入者

(c)AIシステムによって生産された出力がEU内で使用される、第三国に所在するAIシステムのプロバイダおよび導入者

(d)AIシステム輸入業者および販売代理人

(e)自社の名称または商標の下で、自社の製品と一緒にAIシステムを市場に投入またはサービス提供する製造業者

(f)EU内に拠点がないプロバイダの認可された代理人。

(g)EU内に所在する影響を受ける人

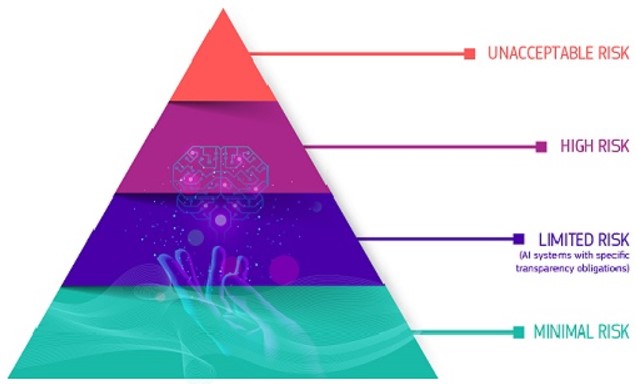

リスクベースのアプローチ

EU AI法ではリスクベースのアプローチをとり、AIのリスクを4つのレベルに分類します。

図:EU AI法のAIのリスク4レベル(欧州委員会の公式ウェブサイトより)

●許容できないリスク(unacceptable risk):利用禁止。

許容できないリスクのAIシステムの例:

・人間の知覚を超えた刺激(サブリミナル要素)を用いて人間の行動を著しく歪める目的またはその効果を持つもの

・年齢、障害、貧困、少数民族などの社会的・経済的な状況などによって影響を受けやすい人々の脆弱性を悪用するもの

・自然人または集団の社会的行動や、既知、推測、予測される個人的特性や性格特性に基づいて評価または分類を行うもの(ソーシャルスコアリングにつながる)

・法執行の目的で公的にアクセス可能な空間でリアルタイムの遠隔生体認証システムを使用するもの、など。

●高リスク(high risk):適切なリスク評価と軽減措置、AIシステムに高品質のデータを入力することによるリスクや差別的結果の抑制、活動のログ記録、適切な人的監視、高いレベルの堅牢性、セキュリティ、精度などが求められる。

高リスクのAIシステムの例:

・EUの既存規制(例:機械指令、玩具安全指令、防爆指令、医療機器規則、他)の適用を受ける製品、またはそのような製品の安全装置

・リモート顔認証や指紋・声紋・静脈認証、建物のひび割れ自動検知、作文などのAI採点、従業員採用業務支援、犯罪者プロファイリング、難民適正判断支援、他。

●限定的リスク(limited risk):透明性の義務あり。

限定的リスクのAIシステムの例:

・チャットボット(AIシステムと対話していることが自然人に知らされること)

・ディープフェイク(コンテンツが人工的に生成または操作されたことを開示すること)、など。

●最小リスク(minimal risk):自由な利用を許可。

最小リスクのAIシステムの例:

・AI対応のビデオゲーム

・スパムフィルター、など。

米国大統領令「安全かつ保護され、信頼できるAIの開発と利用」

「Executive Order on the Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence(編集部による仮訳:安全かつ保護され、信頼できるAIの開発と利用に関する大統領令)」は、2023年10月30日に米国バイデン政権が公表しました。

プライバシーと市民権を重視し、他国を含めた協力関係を促進する方向性が伺えます。EUのようにリスク別の分類や特定のAIの利用禁止を規定してはいないものの、AIが生む恐れのある社会的な害、差別、偏見の抑制を目指しています。独占を防止し競争を促進し、政府、産業、学術におけるAIの利用を拡大することも意図しています。

一方、具体性にはやや欠けるという指摘もあり、今後の法整備が注目されます。連邦政府機関と民間企業が適用範囲ですが、米国のIaaS製品を使用する外国のユーザについての規定もあるため、日本企業にも影響をおよぼす可能性があります。

米国大統領令のポイント

●AI技術の安全性とセキュリティの確保

・外国人ユーザに関する米国のIaaSプロバイダの報告義務

・重要なインフラのサイバーセキュリティ強化

・AIによる生成コンテンツの「電子透かし」検討(生成されたコンテンツであることのラベル付)、など

●イノベーションと競争力強化

・AI人材の確保(ビザ更新プログラムの実施検討など)

・特許権、知的財産法の明確化

●労働者の支援

・AIの労働市場への影響に関する報告書提出義務、AI導入により解雇された労働者への政府による支援可能性の報告義務

・AI導入後の職場においてAIが従業員の福祉に及ぼす害の軽減と、AIの利益を最大化するためのベストプラクティス策定

●公平性と公民権の推進

・AIに関連する公民権および公民の自由の侵害および差別に対処

●消費者、患者、交通機関利用者、学生の保護

・医療、運輸、教育、通信関連の連邦政府機関によるAI活用推進

●プライバシー保護

・AIにより悪化する恐れのあるプライバシーリスク(AIによる個人情報の収集や使用など)の軽減措置

●連邦政府のAI活用推進

・各連邦政府機関でのAI担当者(Chief AI Officer)設置

・リスクマネジメントに基づき特定のAIサービスの利用を制限、適切な生成AIの利用のためのガイドラインと制限の設置

●米国の国際的リーダーシップ強化

・軍事・諜報分野以外での取り組みを主導し、二国間、多国間、マルチステークホルダーのフォーラムにおいて国際的な同盟国やパートナーとの関わりを拡大

カナダ「AIおよびデータ法(Artificial Intelligence and Data Act)」

カナダでは、2022年6月16日に法案C-27(2022年デジタル憲章実施法案)が議会に提出されましたが、これに「Artificial Intelligence and Data Act, AIDA(編集部の仮訳:AIおよびデータ法)」が含まれます。2024年11月現在も議会で審議中ですが、カナダにおける初のAIに関する包括的な規制として注目されています。

同法では、特に「影響の大きいAIシステム(high-impact AI systems)」に対する規定が顕著です。この点はリスク別にAIを分類するEU AI法に通じ、国際的な基準へのアラインメントが意識されているものと思われます。

AIおよびデータ法の注目ポイント

AIおよびデータ法の付属文書によれば、規制が必要なAIシステムを正確に特定し、EU AI法などの国際的枠組みと相互運用できるように、また技術の進歩に合わせて更新できるように、影響の大きいAIシステムの基準が同法で定義されるとしています。また、どのAIシステムが大きな影響力を持つかを判断する際の検討要素に、次のような点を挙げています(抜粋)。

●健康と安全に危害をおよぼすリスクや人権への悪影響のリスクの証拠

●使用規模

●経済的または社会的状況の不均衡、または影響を受ける人々の年齢、など

これらに基づき、注目すべきAIシステムとして次の例を挙げています。

●サービスや雇用へのアクセスに影響を与えるスクリーニングシステム(特に女性や歴史的に疎外されてきたグループに対して、差別的な結果や経済的損害を生み出す可能性がある)

●識別と推論に使用される生体認証システム(生体認証データを使用して、遠隔地からの人物識別、個人の特性、心理、行動について予測するものなど)

●健康と安全に重要なシステム(自動運転や医療分野でトリアージを行うシステムなど。身体的危害を引き起こす可能性や、偏見が生じる可能性がある)、など

このような影響の大きいAIシステムは、使用可能になる前に、危害や偏見を含む出力のリスクを特定、評価、軽減するため、次のような対策を講じることが義務づけられます。

●人間による監視(AIシステムの出力の測定と評価を通じた、人間による監視を行う)

●透明性(AIシステムの機能、制限事項、潜在的な影響などを一般の人々に提供する)

●公平性と公正性(個人やグループに対する差別的結果を緩和する措置を講じる必要がある)

●安全性(予測可能な誤用を含め、AIシステムの使用により生じる可能性のある危害を特定し、リスク軽減策を講じる)

●説明責任(組織が法的義務を遵守するために必要なガバナンスメカニズムを導入する)

●妥当性と堅牢性(AIシステムが目的に沿って一貫して動作すること、AIシステムが様々な状況下で安定し、回復力があること)

また同法では、AIシステムの開発などに関わる企業や組織に対して次の要件が導入されます。

●影響の大きいAIシステムを設計または開発する組織:危害や偏見に関するAIシステムのリスクを特定して対処し、関連する記録を保持すること

●影響の大きいAIシステムを利用できるようにする組織:AIシステムの想定される用途と制限事項を評価し、ユーザがそれらを認識、理解できるように対策を講じること

●AIシステムの運用を管理する組織:適切なリスク軽減戦略を導入し、システムの継続的な監視を確実に行うこと

日本の状況は?

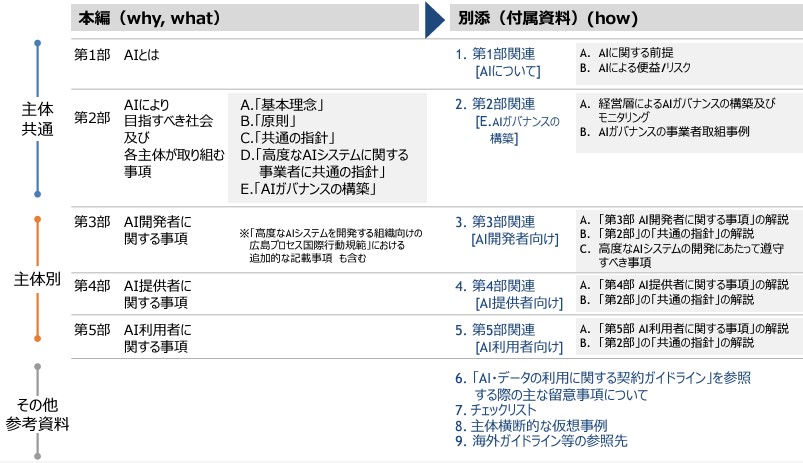

日本では、現時点ではAIを規制する包括的な法令は存在せず、法的拘束力のないガイドラインがあります(冒頭で触れた通り法規制の必要性について検討を開始)。2024年4月19日に経済産業省が取りまとめた「AI事業者ガイドライン(第1.0版)」では、AIの事業活動を担う立場として、「AI開発者」、「AI提供者」、「AI利用者」の3つに大別して整理しています。本編では「どのような社会を目指すのか(基本理念=why)」および「どのような取組を行うか(指針=what)」を示し、別添で「具体的にどのようなアプローチで取り組むか(実践=how)」を示しています。経済産業省のウェブサイトに掲載されていますので、必要に応じて参照してください。

図:「AI事業者ガイドライン(第1.0版)」の内容構成

出典:「AI事業者ガイドライン(第1.0版)概要」(文部科学省)から抜粋

現時点で日本にAIを規制する法案はなくても、上記ガイドラインでは「国際的な議論との協調」も重要視されています。冒頭で触れた2024年12月19日の報道記事(朝日新聞デジタル)では、欧米をはじめとした他の国や地域の規制が日本の今後の法整備の検討開始に影響を与えたとされています。また、国境を超えたビジネスが当たり前となっている昨今では、対象の国や地域の法規制をよく理解しなければならないのは言うまでもありません。引き続き、AI開発の進捗とともに、日本を含めた世界の動向についても情報収集を行っていくことが必要です。

<関連記事>

・生成AIのビジネス活用と考慮すべきリスク

・OWASPが提示するAIリスクのTop 10を読み解く

・生成AIとセキュリティ

・Agentic AIとは?汎用人工知能(Artificial General Intelligence)へのマイルストーン

・AI TRiSM(エーアイトリズム)とは何か?~AI時代に必要なフレームワーク~

Security GO新着記事

SecurityGOの新着情報を押さえる方法3選

(2025年4月28日)

2025年第1四半期の国内セキュリティインシデントを振り返る

(2025年4月25日)

安心=安全×信頼:2030年のセキュリティ社会4つのシナリオ

(2025年4月23日)