2024年の法人組織のAI活用動向~「生成AIとセキュリティに関する意識調査」考察~

2024年は、生成AIのビジネスへの導入が進みました。法人組織における生成AIの利用状況や、生成AIに関連するセキュリティについての調査結果をもとに、課題とその解決のヒントを探ります。

調査目的と対象

2024年9月、トレンドマイクロは特定非営利活動法人CIO Loungeと共同調査を行いました。調査内容には、昨年に引き続いて行った「セキュリティ成熟度と被害の実態調査」のほか、本年は「生成AIとセキュリティに関する意識調査」があります。後者は、急速に普及する生成AIについて、法人組織における利用状況、ポリシーの策定や教育、リスクへの認識、セキュリティへのAI利活用などを調査し、サイバーセキュリティに携わる方々の参考情報としていただくことを調査の目的としています。本記事では、「生成AIとセキュリティに関する意識調査」の結果概要をお伝えし、そこからうかがえる課題へのヒントをお届けします。

調査の対象は、過去3年以内にサイバー攻撃による被害を受けた、従業員500名以上の法人組織の経営層、DX推進・情報資産管理・セキュリティ関連業務などの責任者です。

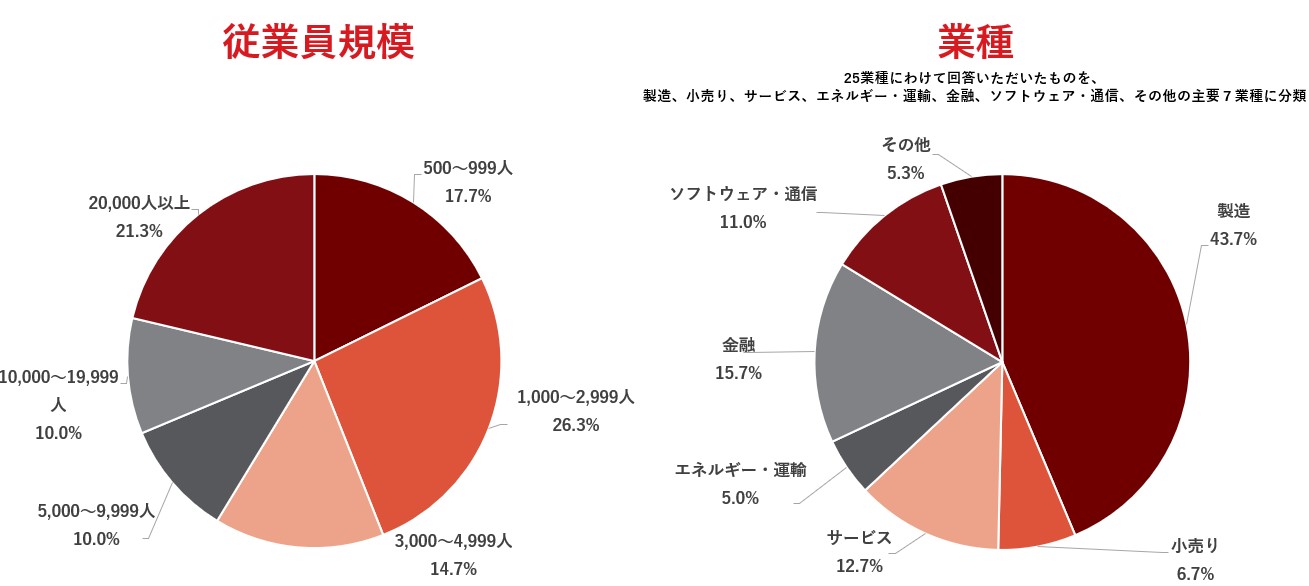

従業員規模別の割合と、業種の内訳・割合はそれぞれ以下のとおりとなりました。

(なお、調査結果のパーセンテージは、小数点以下第二位を四捨五入した数値です。合計が100%にならない場合があります。)

同じ対象者に同時に行った別の調査「セキュリティ成熟度と被害の実態調査」の解説、昨年(2023年)の同調査の解説については次の記事をご覧ください。

参考記事:

・サイバー攻撃の被害に遭いやすい組織の特徴は?2024年の最新調査から考察

・CIO Loungeとの共同調査から見えたサイバー攻撃被害に遭いやすい組織の特徴とは?~「セキュリティ成熟度」と「インシデント被害」の関係性から対策の有効性に着目する~(2023年調査の解説記事)

また、「生成AIとセキュリティに関する意識調査」の全体のレポートはこちらからダウンロードできます。

業種別では、「ソフトウェア・通信」で97.0%と非常に高く、続く「エネルギー・運輸」の86.7%に大きく差をつけています。最も低い業種は「小売り」の60.0%でした。

ソフトウェア・通信の業種では、「プログラムの作成(68.8%)」や「生成AIを活用した独自サービスの開発(65.6%)」に生成AIを利用しており(複数回答)、この点は他業種と比べても特徴的です。また、すべての業種で共通して、生成AIを活用している業務は「文書(メールや報告書)・資料の作成(75.5%)」が最多となりました。

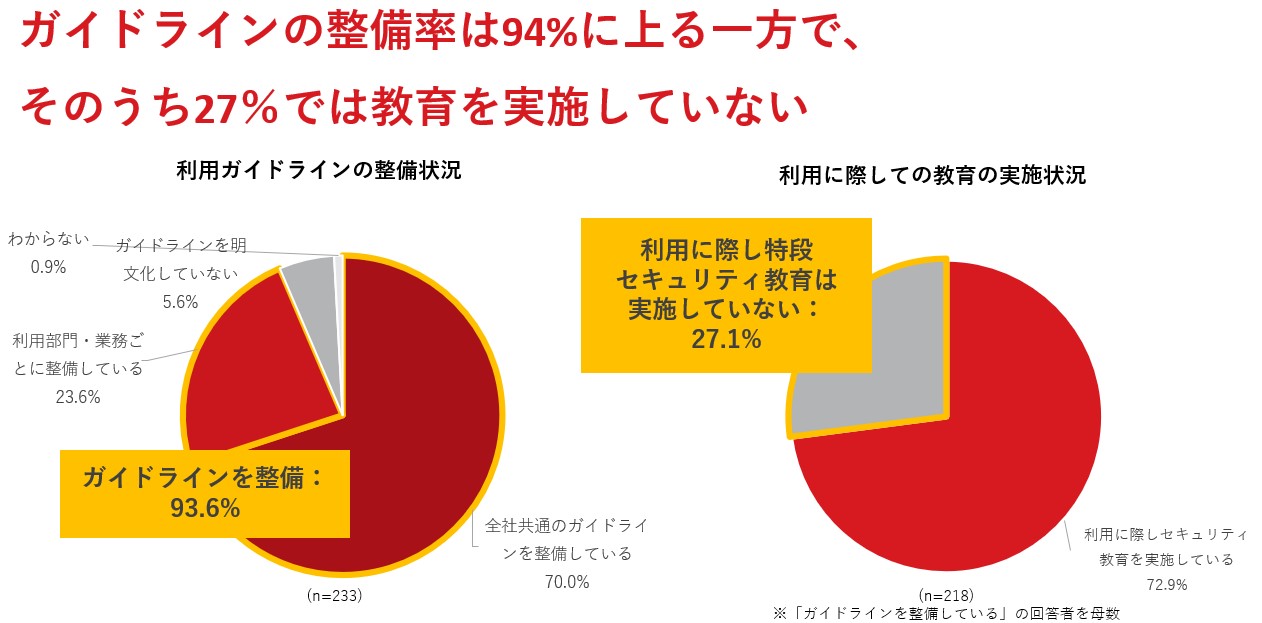

一方、注目すべき調査結果として、ガイドラインの整備状況と教育の実施状況が挙げられます。

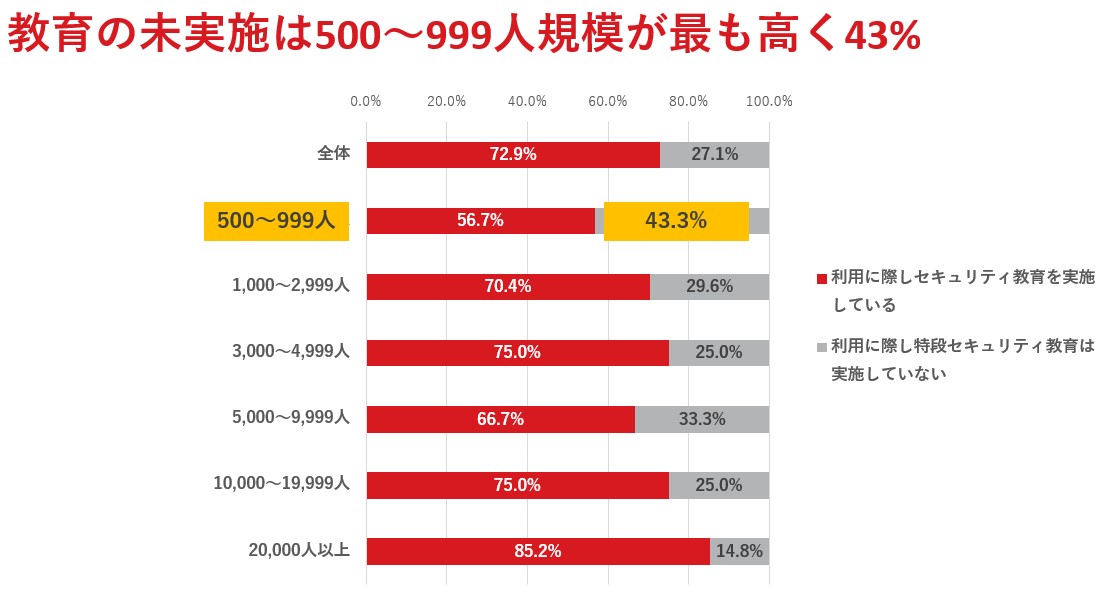

全社共通または利用部門・業務ごとのガイドラインを整備している組織は93.6%にのぼりますが、そのうちの27.1%が「利用に際し特段セキュリティ教育は実施していない」と回答、とりわけ500~999人の組織については43.3%が教育を実施していないと回答しています。

| 生成AIが得意な作業 | 生成AIが苦手な作業 |

|---|---|

| ・プログラミング ・分析業務(アンケート結果の分析など) ・企画書、レポート、資料などの目次作成(文書の目的に沿った目次や骨子の作成) ・要約(レポートや資料の内容の要約) ・翻訳 ・アイデア出し(文書タイトルや見出しなどの提案) |

・最新の情報の検索(本日の株価など) ・非公開の情報をもとにした業務 ・高度な数学(高校、大学レベルの代数や幾何学など) |

また、先ほどの調査結果では、ガイドラインの整備状況と教育の実施状況に差があることも紹介しました。従業員へ安全な生成AI利用方法の浸透を図るには、ガイドラインとともに別途教育の場を設定するのが効果的です。また、後ほど述べるようなインシデントの抑制にも教育は重要な役割を果たします。

教育を実施していない原因は様々でしょうが、教育を行うリソースや時間が足りない、あるいは、どのような教育コンテンツを準備すればよいかわからない、という現場が多いことが推測できます。

従業員教育の重要性と必要性は理解しつつも、実施にはハードルが高いと感じられる場合、まずは従業員の利用状況を把握することから始め、それを受けて、必要な情報を少しずつ提供していく、という方法でも効果的だと考えられます。

神奈川県横須賀市役所の例をご紹介します。同市役所では、2023年4月から職員全員にChatGPTを自由に使ってもらう取り組みを始めました。開始の約1週間後にアンケートを実施し、ChatGPTに向かない作業を行うなどの課題を把握すると、「チャットGPT通信」と銘打って情報発信を行いました。そこでは、ChatGPTの効果的な使い方や、裏技やプロンプト(指示文)の例などをわかりやすく紹介しました。そして、約1か月後に2回目のアンケートを実施したところ、「従来の方法では得られなかったアイデアや知識をChatGPTにより得ることができた」と回答した職員は、1回目の46%から54.3%に増加したと報告しています。

この例では、1回目のアンケート結果から浮かび上がった課題に対応するため情報発信を行ったこと、その情報発信においては身近な例を取り上げ、ChatGPTの利用で効率が上がりやすい作業を提案するなどしたこと、また組織全体で取り組んだことなどが功を奏したと考えられます。法人組織と自治体とでは、扱う情報の質や機密度も異なりますが、アプローチの仕方は法人組織にとっても示唆に富んでいます。

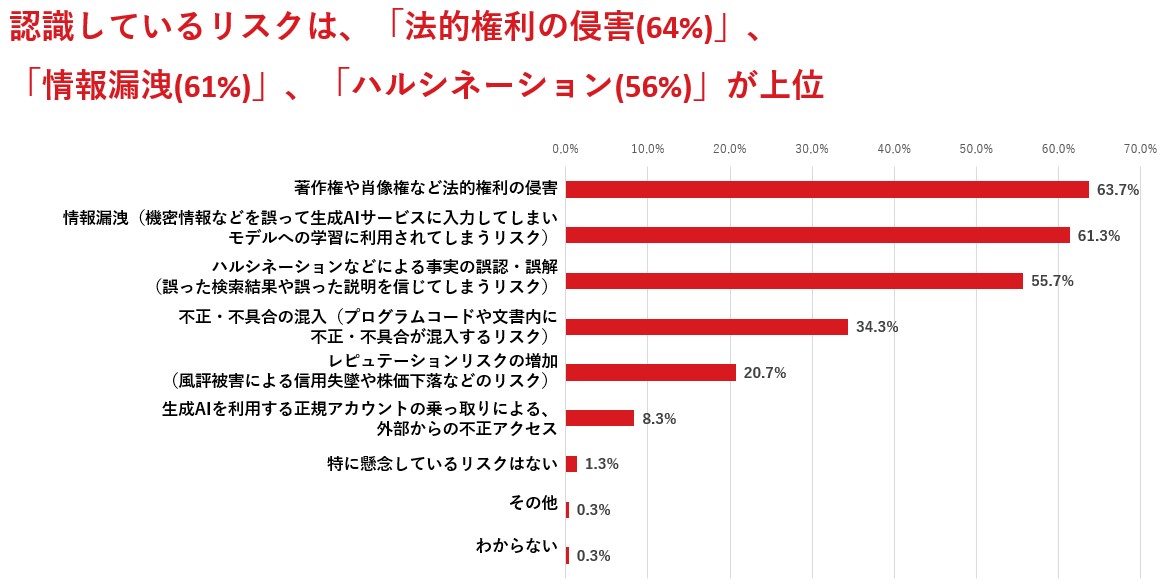

図:生成AIの業務利用においてリスクとして認識しているものを上位3つまで回答。

「生成AIとセキュリティに関する意識調査」より。

生成AI特有の課題として、プロンプト(指示文)の入力をシステムだけで制限することが難しいため、入力内容はユーザの判断に依存するという点が挙げられます。また、生成AIの出力結果に法的権利侵害を含む問題がないかどうかや、出力結果が正しいかどうかをユーザ自身が検証する必要があり、それもユーザの判断に依存します。そのため、繰り返しとなりますが、ガイドラインの制定や従業員教育などの人的・組織的な対応が重要です。

また、「生成AIの普及により、外部からの攻撃リスクは増大すると思うか」という問いに対しては、「増大すると思う」という回答者は65.7%に上りました。一方、「増大すると思わない」もしくは「わからない」とした回答者は34.3%となり、一定数の組織にとって、認識しているリスクは使用方法の誤りによる情報漏洩や著作権侵害・事実誤認など、「内向き」であるとも読み取れます。AIを悪用した攻撃事例、あるいは利用しているAIに対する攻撃事例の報告数が少ないことも大きいですが、すでに実例が報告され始めているほか、様々な研究機関が外部からの攻撃リスクに警鐘を鳴らしたり、攻撃の実証実験を行ったりしているため、先んじて情報収集に努めることをお勧めします。

では、外部からの攻撃リスクにはどのようなものがあるのでしょうか。実例のほかに、実例は確認されていないものの今後の発生が懸念される脅威として、これまで当メディアで取り上げてきた例をいくつか紹介します。

●生成AIを用いたディープフェイク動画による詐欺:2024年2月、詐欺グループが香港のある多国籍企業のビデオ会議において、ディープフェイク技術を悪用して同社の最高財務責任者(CFO)になりすまし、2500万米ドル(約38億円)を送金させる事件が発生。

●生成AIでランサムウェアを作成:2024年5月、生成AIを悪用してランサムウェアを作成したとして、警視庁が川崎市の男性を逮捕。

●ビジネスメール詐欺(BEC):攻撃者が生成AIを悪用し、フィッシング攻撃用の文章作成、スペルや文法の修正、さらに自らは話せない言語での文章生成など行う可能性あり。

●プロンプトインジェクション:生成AIの中でも特に「大規模言語モデル(LLM)」に対して、意図的に誤作動を起こさせるようなプロンプト(指示文)を与え、サービス提供側が出力を禁止している情報などを引き出す攻撃。これにより、攻撃者はシステムの制御を奪ったり、機密情報を盗んだり、不正な操作を行ったりする可能性あり。

他の脅威については、次の記事も参考にしてください。

参考記事:

・2025年のサイバーセキュリティ動向を予測する~AI・APT・ランサムウェアのリスク状況に注意

・OWASPが提示するAIリスクのTop 10を読み解く

・2024年パリ・オリンピックに便乗するサイバー犯罪者 ~生成AIも利用する詐欺の手口とは?~

生成AIのリスクに対しては技術的対策も視野に

上記のような様々なリスクを低減するには、ガイドライン制定や従業員教育は必要不可欠ではありますが、人的対策では限界があるため、技術的対策も併せて取る必要があります。では、どのような技術的対策を講じればよいのでしょうか?

ここでは、当社のソリューションである「Trend Vision One - Zero Trust Secure Access (ZTSA) – AI Service Access」の機能を例にご紹介します。ZTSAでは、自組織が利用・提供するプライベートな生成AIサービスと、ChatGPTをはじめとしたパブリックな生成AIサービスの両方において、ゼロトラスト原則に基づいたアクセス制御を提供します。次のような機能で、生成AIサービスの利用状況を監視し、生成AIサービスのプロンプトとレスポンスを検査することで、AIコンテンツを識別、フィルタリング、分析し、パブリックおよびプライベートクラウド環境における潜在的な機密情報漏洩や安全でない出力を防ぐことができます。

●アクセス制御

●プロンプトフィルタリング

●プロンプトインジェクション防止

●レスポンスフィルタリング

生成AIへのアクセス制御にゼロトラストアプローチを採用することで、利便性と安全とのバランスを保つことが期待できます。お使いのセキュリティソリューションの機能を確認する際に、ぜひ参考にしてください。

サイバーセキュリティにも生成AIの活用を

ここまで、組織で利用している生成AIに起因するリスクについて紹介してきました。最後に、生成AIをサイバーセキュリティにどう活用するか?についても考察します。

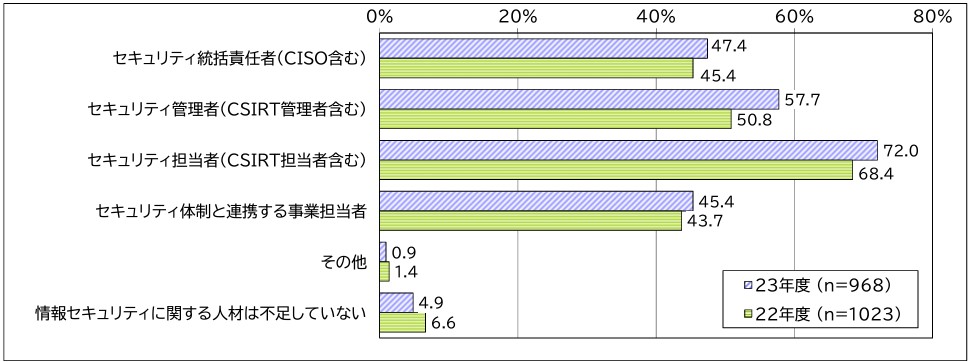

昨今多くの組織で、サイバーセキュリティを担う人材の確保に課題を抱えています。一般社団法人 日本情報システム・ユーザー協会(JUAS)の調査報告書によれば、CISO、CSIRT管理者・担当者などの情報セキュリティの各職種について「人材が不足している」という回答はいずれも40%を超えており、しかも2022年度から2023年度で割合が上昇しています。セキュリティ人材は高度な専門性を求められるうえ、教育に時間や費用がかかることなどから需給バランスが改善しないと同報告書で述べられています。

図:情報セキュリティ人材不足状況。

JUAS「企業IT動向調査報告書2024 ユーザー企業のIT投資・活用の最新動向(2023年度調査)」より

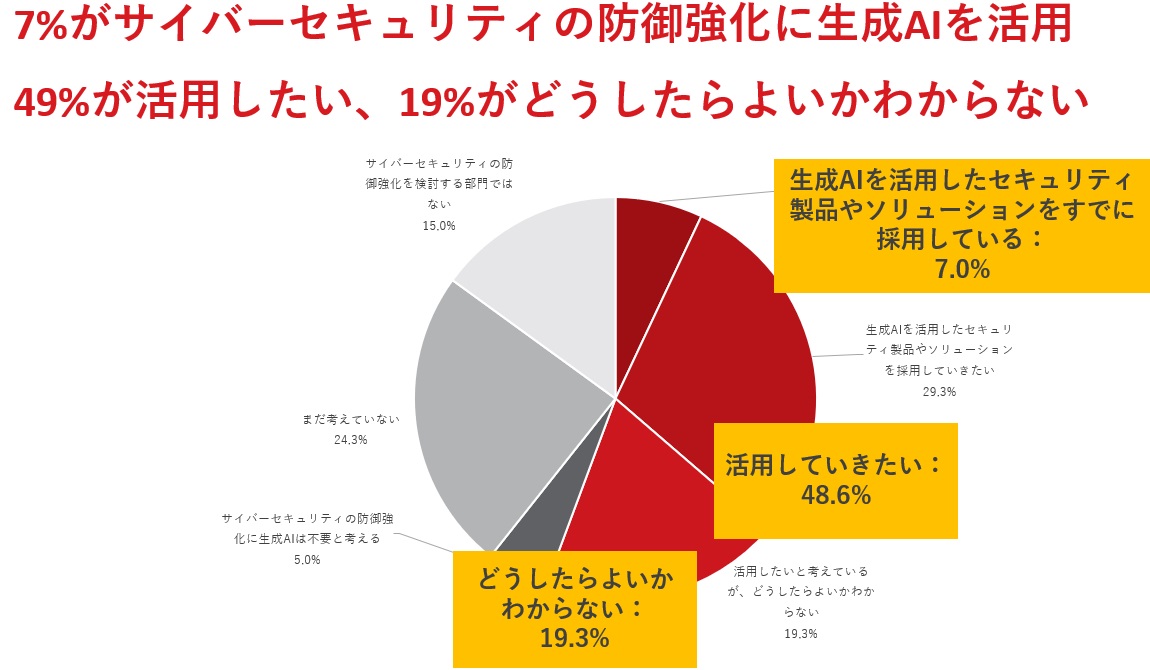

このような人材不足を補う方法のひとつとして、AIのサイバーセキュリティでの活用が期待されています。実際に今回トレンドマイクロが行った調査でも、「サイバーセキュリティの防御強化に、生成AIを活用していくことを考えているかどうか」という問いに対して、すでに活用しているという回答者は7.0%、活用したいと考えている回答者は48.6%に上っています。一方で、どうしたらよいかわからないという回答者も19.3%でした。

図:サイバーセキュリティの防御強化に、生成AIを活用していくことを検討している回答者の割合。

「生成AIとセキュリティに関する意識調査」より。

生成AIをサイバーセキュリティで活用する場合、以下のようなユースケースが考えられます。

●膨大な量のログをリアルタイムで分析し、通常のパターンとは異なる動きを検出する

●過去の攻撃データを学習・分析し、未知のマルウェアを検出する

●環境内の潜在的な脆弱性やリスク要因を特定し、優先順位をつけて対応策を提案する

●レポートの作成補助に生成AIを利用して時間を短縮する

●フィッシングや偽情報などの一次チェック機能として活用し、悪意のあるコンテンツかどうかを人間が判断する時間を短縮する

●メール添付ファイルなどのコンテンツをマルチモーダル(テキスト、画像、音声、動画など、複数のデータ種)で理解し、より高い精度で悪意あるコンテンツを検知する

前述の「Trend Vision One」においても、AIを活用した機能を実装しています。AIが攻撃経路とリスク軽減策を予測する「Attack Path Prediction」、メール文体のAI分析によるBEC対策である「Writing Style DNA」、そして、セキュリティ人材不足や高度なナレッジ不足に直面するSOC(Security Operation Center)を支援するサイバーセキュリティアシスタント「Trend Companion」などを備えています。

こうしたAI活用方法によって、人間の作業時間や労力を削減できるだけでなく、高度な専門知識や技術がなくても対応できるようになることが期待されます。2025年の崖をいよいよ迎える今年、人材不足は今後も続くことが予想されますが、少ない人数で効率的にセキュリティ運用業務をこなしていくには、AIを活用したセキュリティソリューションを検討・導入することをお勧めします。

Security GO新着記事

安心=安全×信頼:2030年のセキュリティ社会4つのシナリオ

(2025年4月23日)

データ・サプライチェーンとは?マネジメント上の課題を解説する

(2025年4月23日)

「AI事業者ガイドライン」から読み解くAI利用時のセキュリティ対策

(2025年4月22日)