Agentic AIとは?汎用人工知能(Artificial General Intelligence)へのマイルストーン

2024年後半は、Agentic AI(自律型AI)の開発が加速しました。「AIエージェント」「エージェントAI」とも呼ばれ、OpenAIが目指す汎用人工知能の実現に向けた5段階のロードマップうち、3段階目とされています。

公開日:2024年10月22日

更新日:2025年2月14日

今回は、現在のAIブームをけん引するOpenAIが全社会議で明らかにしたAIの今後について紹介し、そのなかでも、近い将来ChatGPTのような対話型AIに取って代わると考えられている自律型AI(Agentic AI)について紐解きます。

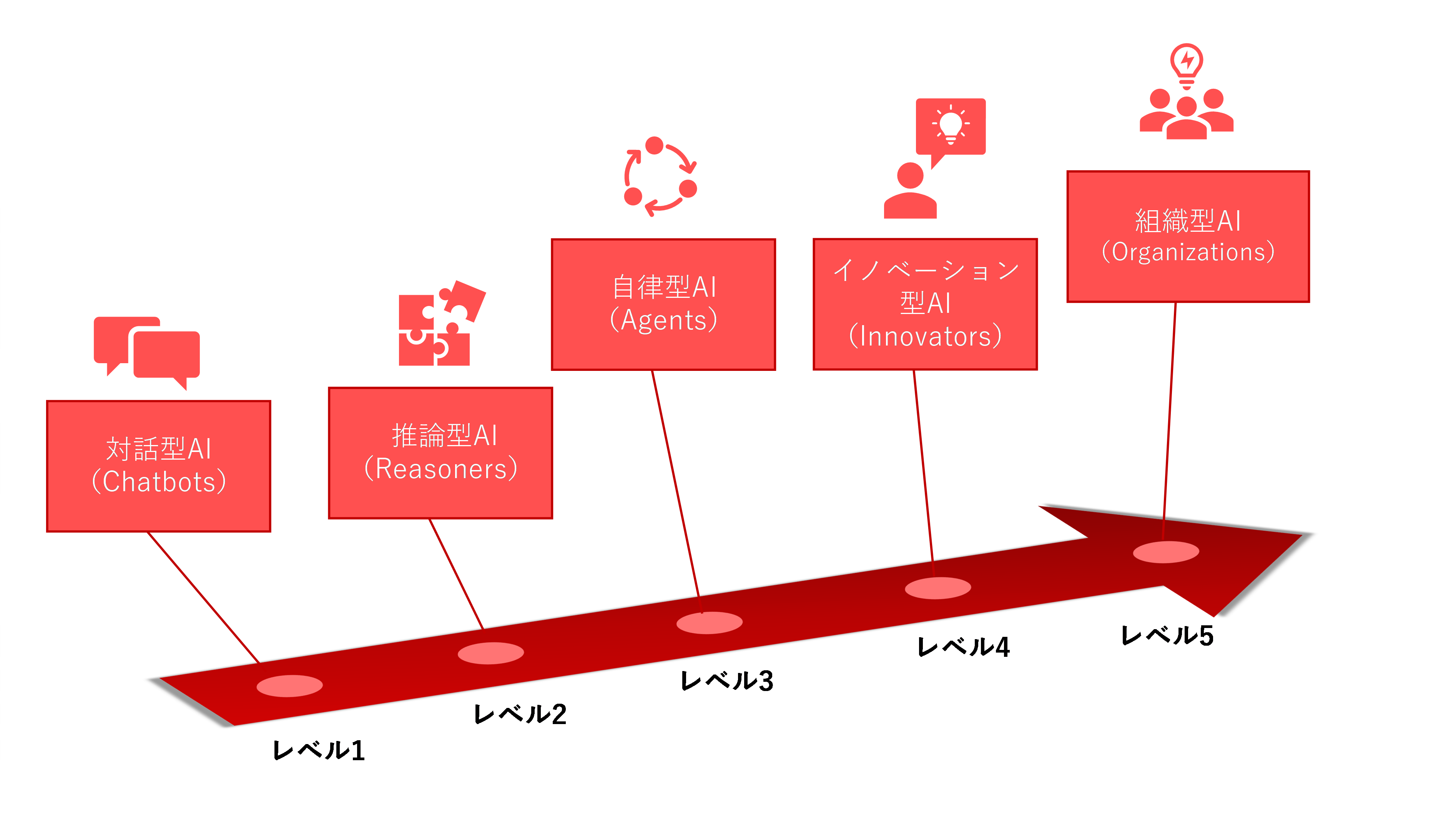

OpenAI、AGIに至る5段階のロードマップを発表

OpenAIは2024年7月の全社会議で、汎用人工知能(Artificial General Intelligence。以降AGI)の実現に向けた進捗状況を示す5段階のロードマップを発表したと各メディアで報じられました。

まずAGIとは、人間のように様々なタスクや課題に対処できる知識や能力を持ち、自己学習を繰り返して成長し、未経験の状況にも柔軟に対応でき、複雑な情報を分析したうえで自ら判断や意思決定を行える人工知能とされています。

このように人間の能力を凌駕するほどの人工知能の実現に向けた5つの段階とは、どのようなものでしょうか?次に概要を述べます。

人間の言語のニュアンスや幅広いトピックを理解し、文法的に正確かつ文脈に適した、人間のようなテキストを生成します。現在はこの段階で、GPT-4やGPT-3.5などのモデルがあります。

●レベル2: 推論型AI(Reasoners)

OpenAIはこのレベルに到達する直前であると考えています。人間レベルの問題解決能力を備えた推論型AIであり、情報や提案を提供する現在の対話型AIとは異なり、高度な論理的推論を用いて複雑な問題を独立して解決できます。医療、法律、工学、金融などの幅広い分野に問題解決スキルを適用できます。この汎用性がポイントです。

●レベル3: 自律型AI(Agents)

ユーザに代わって自律的なアクションを実行できるAIです。ユーザによる継続的な入力や監視は必要なく、データ分析、事前定義されたルール、および経験からの学習によって意思決定を行います。また、自律的でありながらユーザと協働することもできます。

英語ではAgentic AIまたはAgentive AIと表記されることもあります。これについては次の段で説明します。

●レベル4: イノベーション型AI(Innovators)

既存の問題を解決するだけでなく、新しいアイデアを生み出し、斬新なソリューションを作成し、イノベーションを推進するように設計された高度なAIです。クリティカル・シンキングによって、タスクのより良い進め方や目標をより効率的に達成する方法を探ることができます。研究開発活動に従事することもできます。

●レベル5: 組織型AI(Organizations)

AIが組織全体の作業を実行できるようになる状態です。意思決定、管理、運用実行などのさまざまな機能を統合し、組織内の複数の分野(例えば財務、人事、マーケティング、生産、物流、顧客サービスなど)にわたって自律的に機能します。内外のデータから継続的に学習し、変化する状況に適応し、プロセスを改善し、戦略をリアルタイムで更新します。

一部の報道によれば、OpenAIのCEO、サム・アルトマンは今後10年程度でレベル5に達すると推測しているようです。現在はレベル2に達する直前のようですが、実際のところ、それ以降の各レベルのタイムラインは明らかになっていません。

いずれにしても、人間が入力するプロンプトに応答したり定義済みのタスクを実行したりするだけの現在のAIではなく、自律的に行動できるAIはレベル3からということになります。それに到達した暁には、LLM(大規模言語モデル)登場時を上回る衝撃を社会に与えることになるかもしれません。

このレベル3の自律型AIについて、もう少し踏み込んで、OpenAIのホワイトペーパーの記載を紹介します。

Agentic AIとは?

Agentic AIという英語に対して、「AIエージェント」、「エージェントAI」または「エージェント型AI」のような日本語が定着しつつあるように見受けられます。ただ、「エージェント」という言葉から通常想起するのは、代理人や仲介者のようなイメージではないでしょうか。一方Agentic AIの場合は、能動的な行為者の意味合いが強いと思われるため、ここでは「エージェント」は使用せず、ひとまず英語のままの表記とします。

OpenAIのホワイトペーパーでは、冒頭の「定義」において、「Agentic AIシステムは、あらかじめ行動を指定しなくても、長期にわたり一貫して目標達成に貢献する行動がとれることを特徴としている」と説明しています。また、「Agenticnessの程度」を「直接の監督が制限された複雑な環境において、システムが状況に適応しながら複雑な目標をどの程度達成できるか」と定義したうえで、次の4点にブレイクダウンしています。

●目標の複雑さ(AIシステムの目標を人間が達成するにはどのぐらい難しいか?システムが達成しうる目標の範囲はどのぐらいか?)

●環境の複雑さ(どのぐらい複雑な環境において、システムは目標を達成できるか?)

●適応能力(今までにない状況や予想もできない状況に対し、システムはどのぐらいうまく適応し反応できるか?)

●独立した実行(人間の介入や監督が限られるなかで、システムは目標をどのぐらい確実に達成できるか?)

「定義」ではさらに、「我々はAgentic AIについて、自身で目標を設定する完全自律型のシステムではなく、人間が決定する環境において、人間が定義する目標を追求するものとして構想している」と述べているのは興味深い点かもしれません。自律的AIと言われると、人間の手を離れていわば「自分勝手に」行動するようなイメージを抱きがちですが、OpenAIの構想はそうではなく、あくまで主導権は人間にあり、人間は目標達成のためにAIを適切に使う必要があるのがポイントと思われます。

その研究開発において、AIが人間社会に及ぼす影響や倫理的な影響などについて継続的議論が必要であることは以前から言及されています。また、法規制の動きも進んでおり、たとえばEU AI規則は2024年3月に欧州議会で可決、2025年2月から段階的に適用される予定です。同規則ではユースケース別にリスク分類を行い、「許容できないリスク」に分類されたAIは利用禁止とされ、「高リスク」に分類されたAIシステムには満たすべき要件が定められ、これには適切な水準のサイバーセキュリティも含まれます。

参考記事:

・生成AIのビジネス活用と考慮すべきリスク

・EU AI法(EU AI Act)の概要と特徴の解説~日本企業が備えるべきこととは?~

AIが人間に負の影響を及ぼさないように研究開発を進め、法規制を適用したとしても、AIが作成者、ユーザ、または人類全体の利益に反して行動する可能性はゼロにはならないでしょう。上記AGIの実現に向けた各レベルにおいて、リスクが変容したり増大したりする可能性も考えられます。

トレンドマイクロでは引き続き、サイバーセキュリティの観点から、AI起因またはAI関連の脅威をウォッチし、ソリューションを提案し、情報を発信していきたいと考えています。

本記事は2024年8月29日にUSで公開された記事「AI Pulse: Sticker Shock, Rise of the Agents, Rogue AI」を基にしています。

<関連記事>

・生成AIのビジネス活用と考慮すべきリスク

・EU AI法(EU AI Act)の概要と特徴の解説~日本企業が備えるべきこととは?~

・【AI Pulse】ディープフェイクを悪用した詐欺とインフルエンスオペレーション

・AIがセキュリティにもたらすものとは? 立命館大学上原教授にインタビュー

・AI TRiSM(エーアイトリズム)とは何か?~AI時代に必要なフレームワーク~

Security GO新着記事

時事通信社のサイバーセキュリティ最前線~「知る」を支えるデジタル基盤を守るには?

(2026年2月13日)

LLMとSLMは何が違う?AIの規模、制御、そしてリスク

(2026年2月12日)

社長を騙りLINEに誘導する「CEO詐欺」の手口を解説

(2026年2月6日)