Artificial Intelligence (AI)

「CES 2025」で発表されたAIデジタルアシスタントとそのセキュリティリスクの包括的な分析

本稿では、2025年1月7日~10日に米国ラスベガスで開催された世界最大級のテクノロジー見本市「CES 2025」で発表されたさまざまなAIデジタルアシスタントの機能について、トレンドマイクロの調査による評価マトリックスを用いて分析しました。これにより、この新興技術が潜在的なセキュリティ脅威にどのように対応できるのかを評価しました。

- 今年のCESでは、高度なAIデジタルアシスタントが多数発表され、日常生活にシームレスに統合されることが期待されています。

- しかし、AIデジタルアシスタントの進化に伴い、データプライバシーの問題や個人情報の悪用の可能性など、深刻なサイバーセキュリティリスクも浮上しています。

- トレンドマイクロは、これらの製品をケーススタディとして取り上げ、前回記事で取り上げたAIデジタルアシスタントマトリックスに基づいて評価を行い、この新興技術が直面する可能性のある問題や脆弱性について考察しました。

- 常時音声を監視し、重要な情報を取り扱うこれらのアシスタントは、音声コマンドの操作やアイデンティティの盗用といった攻撃のリスクを抱えています。こうしたリスクを軽減するためには、強固なセキュリティ対策とユーザの認識向上が不可欠です。

AIデジタルアシスタント(DA)の発展は、技術革新の重要な局面を迎えています。この技術は、環境とのインタラクションを劇的に変革し、シームレスな利便性、パーソナライズされたサービス、そして効率性の向上を提供します。2025年1月7日~10日に米国ラスベガスで開催された世界最大級のテクノロジー見本市「CES 2025」では、こうした革新的なAIデジタルアシスタントが発表され、常時待機型のホームアシスタント、個別に対応するウェルネスコーチ、旅行プランナーなど、多様な活用が期待されています。

しかし、AIデジタルアシスタントが高度化するにつれ、さまざまなサイバーセキュリティの脅威が浮かび上がってきました。これらのシステムは、機密性の高い個人データを取り扱い、重要なデバイスへのアクセスを管理し、複雑なエコシステムの中で動作します。そのため、適切な暗号化技術の導入や安全なデータ保存プロトコルの実装が不可欠です。こうしたリスクを理解することは、ユーザの安全と信頼性を確保するために重要です。

トレンドマイクロで実施した前回の調査をもとに、本稿ではCES 2025で発表された注目すべき3つのAIデジタルアシスタントを取り上げ、それらの潜在的な脅威を評価します。これらの製品は革新的な新技術であるため、公表されている機能説明を基に評価を行いました。また、一般に公開されているオープンソースデータを活用し、この技術が抱える可能性のあるセキュリティ上の課題を特定しました。こうした問題を指摘することで、製品メーカーに対し、顧客の保護を考慮した対策を講じるよう促すことを目的としています。

常時待機型AIデジタルアシスタント

ソフトウェア企業「Bee」が開発した常時待機型AIデジタルアシスタントは、リアルタイムの応答を提供するために継続的な音声監視を行います。この機能は利便性を大幅に向上させる一方で、深刻なセキュリティリスクを引き起こす可能性があります。Bee社のウェアラブルデバイス「Bee Pioneer」にはマイクが搭載されており、音声データをBee AIに送信する仕組みになっています。

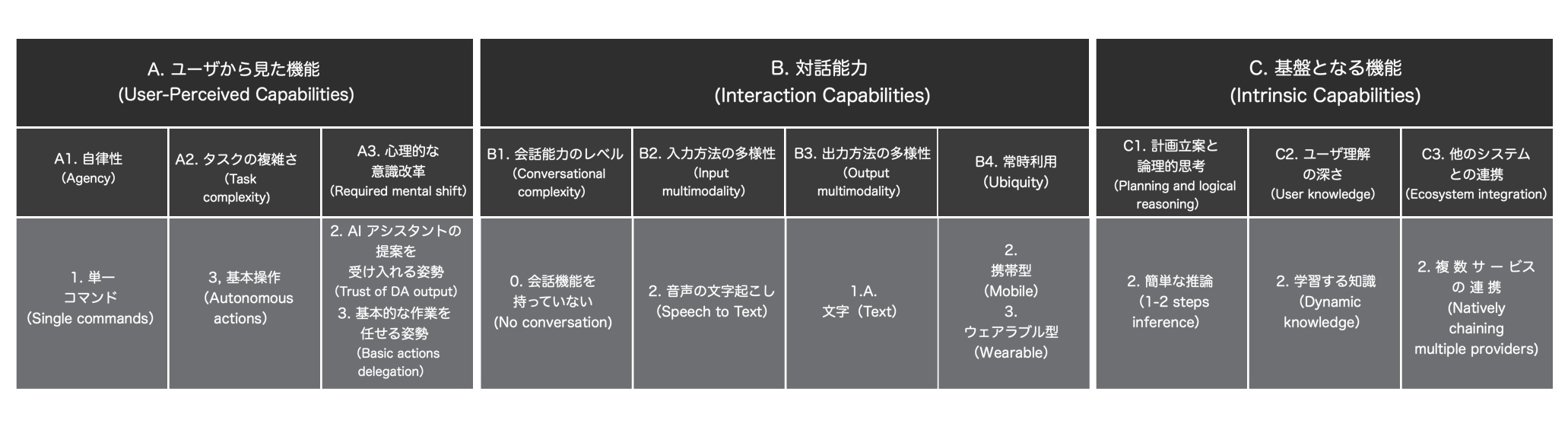

トレンドマイクロで実施した前回の調査により、これまでの研究で構築したAIデジタルアシスタントの評価フレームワークに基づき、このAIデジタルアシスタントの機能をマッピングしました(表1参照)。

- 自律性(Agency):一般的なケースでは、AIデジタルアシスタント(DA)が情報を提供するだけの場合、エージェンシーのレベルは0「情報提供のみ(Informational only)」になります。しかし、上記の記事によると、BeeはAIに指示を出して好みに合ったレストランを探すといった基本的なアクションを実行できるため、より高いレベルである1「単一コマンド(Single commands)」に分類されます。

- タスクの複雑さ(Task Complexity):Beeはユーザの入力に基づき、自律的にアクションを実行できるため、3「基本操(Autonomous actions)」と評価しました。

- 心理的な意識改革(Required Mental Shift):Beeは主に要約やインサイト、リマインダーを提供するため、ユーザの関与度は低く、2「AI アシスタントの指示を信頼する姿勢(Trust of DA Instructions)」に分類されます。しかし、エージェンシーの観点から考慮すると、Beeは基本的なアクションを実行できるため、ユーザがより積極的に関与する必要があり、3「基本的な作業を任せる姿勢(Basic actions delegation)」とすることもできます。

- 会話能力のレベル(Conversational Complexity):Beeは実際の会話を行うことができないため、0「会話機能を持っていない(No conversation)」と評価されます。

- 入力方法の多様性(Input Multimodality):Beeは2「音声の文字起こし(Speech-to-Text)」と評価されており、音声入力を利用します。

- 出力方法の多様性(Output Multimodality):1.A「文字(Text)」に分類され、出力はテキストのみとなっています。

- 常時利用(Ubiquity):BeeはiPhoneアプリとして提供されるため、2「携帯型(Mobile)」、またApple Watchや単独のタグとしても利用できるため、3「ウェアラブル型(Wearable)」と分類されます。

- 計画立案と論理的思考(Planning and Logical Reasoning):公開されている情報に基づき、2「簡単な推論(1-2 Steps inference)」と評価しました。

- ユーザ理解の深さ(User Knowledge):Beeはユーザとのやり取りを通じて、習慣を学習し適応するため、2「学習する知識(Dynamic knowledge)」に分類されます。ユーザの周囲にいる他の人々についても学習しますが、これを3「人間関係の理解(Community)」とするには、他者の情報を実際に保持する必要があるため、今回は該当しません。

- 他のシステムとの連携(Ecosystem Integration):2「複数サービスの連携(Natively chaining multiple providers)」と評価されており、他のデバイス(スマートフォンなど)と連携し、外部サービスともやり取りできます(エージェンシーの例を参照)。

Bee社製のようなデバイスには、データプライバシーの問題が大きく関わってきます。常時音声を記録することで、機密性の高い会話が意図せず収集され、悪用されるリスクが高まります。暗号化の標準が不十分で、データ保存のセキュリティが確保されていない場合、攻撃者がこれらのデータを傍受し、不正行為(例えばアイデンティティの盗用)に利用する可能性があります。特に狙われやすいのは、アカウント情報を盗み、連携アプリにログインして機密性の高いデータを抜き取る方法です。また、音声コマンドの操作リスクも考慮すべき重要な課題です。合成音声や録音された音声を用いることで、不正な操作が行われる可能性があります。音声入力を利用するB2「入力方法の多様性(Input Multimodality)」に関しては、以下のような未来の脅威が想定されます。

- スキル名の類似性を悪用した攻撃(Skill squatting)

- 正規を装う悪意あるスキル(Trojan skill)

- メタバース内の悪意あるアバターによるなりすまし詐欺(Malicious Metaverse avatar DA phishing)

- AIアシスタントを悪用した心理操作(DASE: Digital assistant social engineering)

- 進化する不正広告の脅威(The Future of Malvertising)

- 進化する標的型フィッシング(The future of spear phishing)

- 意味検索の最適化(SEO)を悪用した攻撃(Semantic Search Engine Optimization abuse)

- エージェントを利用した攻撃(Agents Abuse)

- 外部からの悪意あるAIアシスタント(Malicious External DAs)

AIウェルネスコーチ

パナソニック社のAIウェルネスコーチ「Umi」は、個別最適化された健康・ウェルネスアドバイスを提供します。Umiは、同社のウェルネスポートフォリオの一環として開発され、ユーザのバイオメトリクス(生体情報)や行動データを収集し、フィットネス、睡眠、栄養に関するパーソナライズされた指導を行います。しかし、こうした高度な機能は、ユーザに対してセキュリティリスクをもたらす可能性もあります。

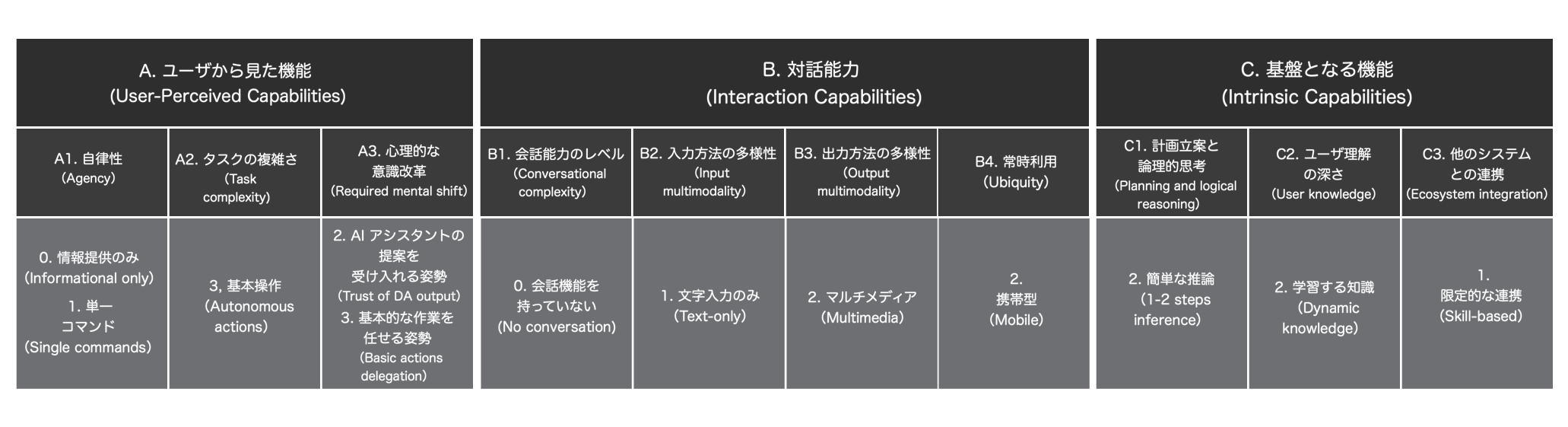

トレンドマイクロで実施した前回の調査により、これまでの研究に基づき、AIデジタルアシスタントの評価フレームワークを用いて、AIウェルネスコーチの機能をマッピングしました(表2参照)。

- 自律性(Agency):現時点で得られている情報が限られているため、エージェンシーのスコアは0「情報提供のみ(Informational Only)」としました。ただし、アシスタントが「ユーザの代わりにアクションを実行する」ことの具体的な意味によっては、1「単一コマンド(Single Commands)」に該当する可能性もあります。

- タスクの複雑さ(Task Complexity):事前に定義された入力に基づいて特定のアクションを実行できるため、3「基本操作(Autonomous actions)」と評価しました。

- 必要な思考の変化(Required Mental Shift):アシスタントは主に通知やインサイトを提供するため、ユーザの関与度は低〜中程度と考えられ、2「AI アシスタントの指示を信頼する姿勢(Trust of DA instructions)」に分類されます。しかし、特定のタスクをユーザの代わりに実行できる場合は、ユーザの関与度が高まり、3「基本的な作業を任せる姿勢(Basic actions delegation)」となる可能性もあります。

- 会話能力のレベル(Conversational Complexity):構造化されたやり取りを超えた実際の会話には対応していないため、0「会話機能を持っていない(No conversation)」と評価されます。

- 入力方法の多様性(Input Multimodality):主にテキスト入力をサポートするため、1「文字入力のみ(Text-only)」としました。

- 出力方法の多様性(Output Multimodality):テキストとグラフィックを使用した出力を行うため、2「マルチメディア(Multimedia)」と評価されます。

- 常時利用(Ubiquity):CESでのデモではモバイルアプリとして紹介されたため、2「携帯型(Mobile)」と評価しました。今後、他のデバイスへの展開も考えられます。

- 計画立案と論理的思考(Planning and Logical Reasoning):構造化された論理的アクションを処理できるため、2「簡単な推論(1-2 steps inference)」と評価されます。

- ユーザ理解の深さ(User Knowledge):ユーザの習慣について動的に学習することが想定されるため、2「学習する知識(Dynamic Knowledge)」に分類されます。ただし、他のユーザとの相互作用を広範に追跡することはないため、3「人間関係の理解(Community)」には該当しません。

- 他のシステムとの連携(Ecosystem Integration):1「限定的な連携(Skill-based)」と評価されており、Precision NutritionやSleepLabsといった外部サービスとの統合が可能です。

さらにトレンドマイクロの調査によると、生体認証データを扱うAIウェルネスコーチには重大なリスクが存在します。心拍数や睡眠パターンといった健康データは極めて機密性が高く、万が一流出した場合、詐欺師による偽造医療記録や誤った健康アドバイスのリスクが発生します。さらに、ウェルネスコーチはサードパーティの健康機器やアプリと連携するため、攻撃対象となる範囲が広がります。これらの接続のどこかに脆弱性があると、攻撃者がシステムに侵入し、ユーザの機密情報にアクセスできる可能性があります。

また、ソーシャルエンジニアリング攻撃もウェルネスデバイスにとって大きな脅威となります。MyFitnessPalのデータ漏洩では、ウェルネスアプリの脆弱性によって何百万ものユーザ情報が流出しました。これは、AIを活用したウェルネスデバイスにおいて強固なセキュリティ対策が不可欠であることを示しています。サイバー犯罪者が医療従事者を装い、健康データを利用してより説得力のある詐欺を仕掛ける可能性もあります。健康データが直接引用された攻撃は、被害者にとって非常に信憑性が高く、個人情報を漏らしたり、不必要なサービスに支払いをしてしまうリスクが高まります。最悪の場合、攻撃者がウェルネスアプリのエコシステムと不正に連携し、偽の健康サービスを提供する可能性もあります。ウェルネスコーチはC2「ユーザ理解の深さ(User Knowledge)」を保持しており、このレベルでは以下のような未来の脅威が想定されます。

- スキル名の類似性を悪用した攻撃(Skill squatting)

- 正規を装う悪意あるスキル(Trojan skill)

- AIアシスタントを悪用した心理操作(DASE: Digital assistant social engineering)

- 進化する標的型フィッシング(The future of spear phishing)

- 意味検索の最適化(SEO)を悪用した攻撃(Semantic Search Engine Optimization abuse)

- エージェントを利用した攻撃(Agents Abuse)

- 外部からの悪意あるAIアシスタント(Malicious External DAs)

AIトラベルコンシェルジュ

デルタ航空のAIコンシェルジュは、個人の旅行データを分析し、カスタマイズされた推奨を提供することで旅行体験を向上させます。このAI搭載のデルタコンシェルジュは、同社のFly Deltaアプリに統合される予定です。旅行計画を簡素化することを目的としていますが、このようなAIデジタルアシスタントはさまざまなセキュリティリスクを引き起こす可能性があります。

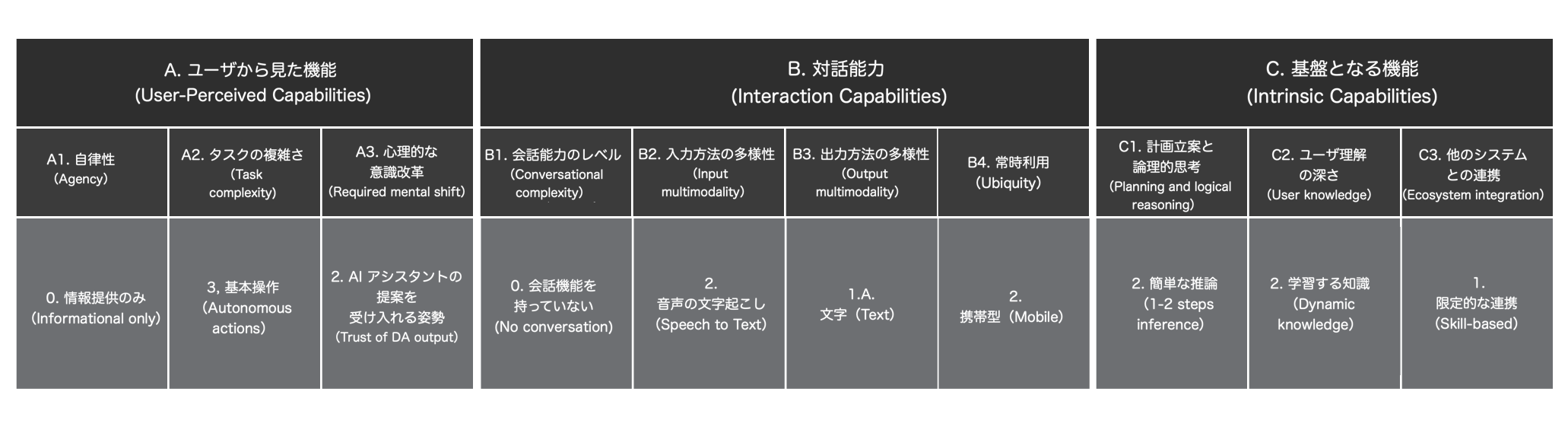

トレンドマイクロで実施した前回の調査により、これまでの研究に基づき、AIデジタルアシスタントの評価フレームワークを用いて、AIコンシェルジュの機能をマッピングしました(表3参照)。

- 自律性(Agency) – 現時点で得られている情報が限られているため、エージェンシーのスコアは0「情報提供のみ(Informational only)」としました。ただし、アシスタントが「ユーザの代わりにアクションを実行する」ことの具体的な意味によっては、1「単一コマンド(Single commands)」に該当する可能性もあります。

- タスクの複雑さ(Task Complexity) – 事前に定義されたアクションを自律的に実行できるため、3「基本操作(Autonomous actions)」と評価しました。

- 心理的な意識改革(Required Mental Shift) – アシスタントは主に通知やリマインダー(例:旅行の最新情報など)を提供するため、ユーザの関与度は低〜中程度と考えられ、2「AI アシスタントの指示を信頼する姿勢(Trust of DA instructions)」に分類されます。ただし、アシスタントのアクション実行能力が向上すれば、関与度が高まり、3「基本的な作業を任せる姿勢(Basic actions delegation)」となる可能性もあります。

- 会話能力のレベル(Conversational Complexity) – 自由な会話には対応せず、構造化されたやり取りのみに限定されるため、0「会話機能を持っていない(No conversation)」と評価されます。

- 入力方法の多様性(Input Multimodality) – 音声入力を利用するため、2「音声の文字起こし(Speech-to-Text)」としました。

- 出力方法の多様性(Output Multimodality) – 1A「文字(Text)」と評価されており、主にテキストやグラフィックによる情報提供を行います。

- 常時利用(Ubiquity) – 航空会社のサービスおよびモバイルアプリと統合されているため、2「携帯型(Mobility)」と評価しました。将来的に他のプラットフォームへ拡張される可能性もあります。

- 計画立案と論理的思考(Planning and Logical Reasoning) – 2「簡単な推論(1-2 steps inference)」と評価され、例えばビザの有効期限を認識し、通知を送信するなどの構造化された論理的アクションを処理できます。

- ユーザ理解の深さ(User Knowledge) – 2「学習する知識(Dynamic Knowledge)」と評価され、ユーザの旅行習慣を把握します。ただし、広範なユーザ間の相互作用を追跡するわけではないため、3「人間関係の理解(Community)」には該当しません。

- 他のシステムとの連携(Ecosystem Integration) – 1「限定的な連携(Skill-based)」と評価され、UberやJobiなどのパートナーサービスと連携し、外部プラットフォームとある程度の相互作用が可能です。

デルタ社のAIデジタルアシスタントは、旅行の好み、旅程、支払い情報などの機密データを扱うため、サイバー犯罪者にとって魅力的な標的となります。データ漏洩が発生すると、個人情報の盗用や金融詐欺につながる可能性があります。攻撃者はまた、このコンシェルジュを悪用してフィッシングメッセージを送信し、不正な旅行アラートを装ってユーザを騙し、パスワードや支払い情報を盗む可能性があります。アプリ内でのやり取りに限られていたとしても、攻撃者が盗んだデータを基に、もっともらしい偽の旅行コンシェルジュのメールを送信することで、より信頼性のあるフィッシング詐欺を仕掛ける可能性があります。

将来的に、この種の旅行関連アシスタントは、複数のプロバイダーを横断して旅行予約を完全に自動化するようになると予測されます。しかし、こうした進化は新たな脅威も伴います。例えば、サプライチェーン攻撃やデータポイズニング攻撃が発生する可能性があり、悪意のある人物が旅行の空席状況を操作して偽の情報を注入することが考えられます。また、国家が監視対象とする人物に対し、こうした技術が監視の一環として悪用される恐れもあります。

認証機構が脆弱である場合、不正なアカウントアクセスのリスクが高まります。攻撃者がユーザアカウントを乗っ取ると、旅行プランの変更、不正な予約、支払い情報の盗難などが発生する可能性があります。サイバー犯罪者が旅行費用を不正に削減しながら世界中を移動する手口があることは、過去のトレンドマイクロの調査でも明らかになっています。こうした脆弱性は、ユーザの信頼を損なうだけでなく、旅行者に経済的および物流上の損害をもたらす可能性があります。

AIトラベルコンシェルジュはC2「ユーザ理解の深さ(User Knowledge)」を保持しており、前述の通りレベル2に分類されます。このため、適用される未来の脅威は以下の通りです。

- スキル名の類似性を悪用した攻撃(Skill squatting)

- 正規を装う悪意あるスキル(Trojan skill)

- メタバース内の悪意あるアバターによるなりすまし詐欺(Malicious Metaverse avatar DA phishing)

- AIアシスタントを悪用した心理操作(DASE: Digital assistant social engineering)

- 進化する不正広告の脅威(The Future of Malvertising)

- 進化する標的型フィッシング(The future of spear phishing)

- 意味検索の最適化(SEO)を悪用した攻撃(Semantic Search Engine Optimization abuse)

- エージェントを利用した攻撃(Agents Abuse)

- 外部からの悪意あるAIアシスタント(Malicious External DAs)

Trend Vision One™

Trend Vision One™ は、セキュリティを簡素化し、企業が脅威をより迅速に検出・阻止できるようにするサイバーセキュリティプラットフォームです。複数のセキュリティ機能を統合することで、企業の攻撃対象領域の管理を強化し、サイバーリスクの可視性を向上させます。このクラウドベースのプラットフォームは、世界16カ所の脅威研究センターと2億5千万のセンサーからのAIと脅威インテリジェンスを活用し、包括的なリスクインサイト、早期の脅威検出、および自動化されたリスク・脅威対応を単一のソリューションとして提供します。

まとめ

AIデジタルアシスタントの機能は多岐にわたり、それによって直面するセキュリティリスクも異なります。これらのシステムは、単純な音声操作ツールから、高度なAIエージェントまで進化し、トランザクションの実行、IoTエコシステムの管理、複雑なワークフローの自動化を可能にします。しかし、AIデジタルアシスタントは進化を続けている一方で、多くの現行の実装では、真のマルチモーダル機能、シームレスな統合、そして文脈認識能力が十分に備わっていません。これらの制約があるにもかかわらず、AIデジタルアシスタントはすでに、データプライバシーの侵害、敵対的AI操作、高度なソーシャルエンジニアリング攻撃といったリスクにユーザをさらしています。本レポートでは、AIデジタルアシスタントマトリックスを活用し、これらのAIデジタルアシスタントを代表例として分析し、実際の利用シナリオにおいて直面する可能性のあるセキュリティ課題を検討しました。

前回トレンドマイクロが実施した調査では、AIデジタルアシスタントの機能と対応するセキュリティリスクをマッピングすることの重要性を強調し、適切な防御策の実装に向けた洞察を提供しました。各機能レベルには、それぞれ特有の脆弱性が存在します。

- 基本的なAIデジタルアシスタント(単純な音声操作による問い合わせ処理):データの傍受、盗聴、不正アクセスのリスクがある。

- コンテキスト認識型アシスタント(ユーザの行動や履歴に基づいて応答を調整するシステム):セッションハイジャック、推論によるプライバシー漏洩、意思決定の操作リスクがある。

- 高度に統合されたAIシステム(クロスプラットフォームでのタスク自動化、金融取引の実行、自律的な意思決定を行うアシスタント):高度なソーシャルエンジニアリング、敵対的入力攻撃、自動化の悪用、権限昇格攻撃といった脅威にさらされる。

セキュリティ対策は、AIデジタルアシスタントの機能拡張に追いついていません。現行の多くの実装では、マルチモーダルなインタラクション、シームレスなエコシステム統合、適応型のセキュリティメカニズムが不足しており、これらの欠如が新たなリスクを生み出しています。このギャップは、AIの自律性の進化を見越した防御策の必要性を浮き彫りにしています。開発者は、脆弱性が発生した後に対応するのではなく、AIの進化に合わせてスケール可能なセキュリティフレームワークを設計する必要があります。

また、ユーザの意識向上もAIの進化と並行して進める必要があります。多くのユーザは、AIデジタルアシスタントを単純なツールと認識しており、機密データへのアクセスや意思決定の権限を与えることのリスクを過小評価しがちです。ユーザは、AIシステムに依存することで生じるトレードオフを理解し、適切なリスク管理を行うことが求められます。

業界が、より高度でマルチモーダルかつ深く統合されたAIデジタルアシスタントへと進化していく中で、セキュリティは常に基盤として考慮されるべきです。AIの進化に対応した防御策が整備されなければ、これらのシステムは信頼できるデジタルパートナーではなく、攻撃者にとって魅力的な標的になってしまうリスクを抱えています。

参考記事:

CES 2025: A Comprehensive Look at AI Digital Assistants and Their Security Risks

By Vincenzo Ciancaglini, Salvatore Gariuolo, Stephen Hilt, Rainer Vosseler

翻訳:与那城 務(Platform Marketing, Trend Micro™ Research)