大統領選挙でも悪用されうる生成AI

米大統領選挙に対する脅威として米国家情報長官室(ODNI)は、AIを筆頭の懸念材料として挙げています。生成AIの悪用リスクが選挙など民主主義の核となる仕組みにまで及んでいる現状について事例を交えて解説します。

この記事の主要なポイント

●インターネットとSNSの普及により、誤情報や偽情報が瞬く間に拡散されるようになりました。AIツールの登場で、この問題はさらに深刻化し、正確でない情報の作成と拡散が容易になっています。

●生成AIには生産性向上などの利点がある一方で、ディープフェイクやフェイクニュースの作成にも悪用されかねません。それらの技術の手軽さ、速さ、拡張性が、一般のネットユーザにもより一層の警戒を必要とする状況を生み出しています。

●ディープフェイク技術は、信憑性の高い偽のコンテンツを作り出すことで、個人の評判を傷つけ、虚偽情報を広め、世論を操作する可能性があり、選挙の公正性に重大な脅威をもたらしています。

●「何も信用せず、すべてを検証する」というゼロトラストモデルが不正選挙対策にも適用できます。AIとディープフェイクを悪用した脅威に侵害されないように、徹底した事実確認を行う必要があります。

選挙は民主主義制度の根幹をなす仕組みであり、国民が投票を通じて政治的意思を表明する重要な機会です。しかし、選挙システムにテクノロジーが導入されるにつれ、選挙を支えるインフラだけでなく、投票所に足を運ぶ有権者自身にも深刻なサイバーセキュリティリスクがもたらされています。本稿では、次の問いを投げかけます。「私たちの一票は本当に自由意思によるものなのか、それとも見えない力によって操られているのでしょうか。」

プロパガンダ(特定の意見や信念を広めるために情報を操作し、感情に訴える手法や活動)そのものは昔から存在しましたが、今日の状況が異なるのは、ニュースや情報を伝える媒体が新聞やテレビからインターネットやSNSへと変化したことです。これにより、誤情報が急速に広まりやすくなり、事実に基づかないフェイクニュースがこれらのプラットフォームを通じて広められています。

さらに最近では、AIツールがこうした活動を後押しし、信じられないほどの速さで大量の虚偽情報コンテンツを生み出すことを可能にしています。これらのコンテンツには創作された文章や画像といった情報だけでなく、ディープフェイクを悪用して作成された精巧な偽の音声や動画も含まれます。

「意見」はどのように作り上げられ、操作されるか

他人の考えを変えようとすること自体は必ずしも悪いことではありません。日常の会話、ニュース、広告など、私たちは常に様々な情報を発信し、お互いに影響を受けています。このように自由な意見交換は、個人の成長と社会の進歩に欠かせません。ただし、言動には倫理的・法的な制限があります。自分自身の主張の優れている点を論じることと、虚偽の情報を用いて嘘をつくことは全く別物です。

私たちの意見は、得られた情報と個人的な先入観の相互作用によって形成されます。私たちは新しい情報を受け取ると、それを解釈し、認識を形成し、自分自身のオリジナルなメッセージとして再構築します。一方でプロパガンダは、センセーショナルな見出し、挑発的なツイート、先入観を利用した動画などを用いて、他社の認識を意図的に作り変えて、このプロセスを操作します。

誤情報を用いた工作活動は複数のメディアを通じて発信されるため、情報の受け手は多面的に誤情報に接することとなります。このプロセスを通じて誤った認識がより強化されることとなり、情報の受け手は真実と虚偽の区別がますます難しくなります。

この段階で、レオン・フェスティンガーの認知的不協和理論(自分の中で矛盾する認知を同時に抱えた際に覚える不快感やストレス)が作用し、自分の歪んだ現実認識に合う情報だけを求めるようになります。その結果、偏向的な主張ばかりを述べる動画を視聴したり、偏った意見を述べるニュースを購読したり、場合によっては過激な思想を擁するオンライングループに参加したりして、自分の信念を正当化しようとします。こうして、私たちは自分の信念だけが反響する「エコーチェンバー」(SNSなどで自身と同じ意見や考えを持つ人々とだけ交流している状態)の中に閉じ込められてしまうのです。

参考記事:フィルターバブルとは? 意味と危険性をわかりやすく解説

これは一種の洗脳や認知的ハッキングの状態と言えるでしょう。コンピュータシステムへの不正アクセスではなく、人々の認識そのものを操作することが目的となるのです。

参考記事:インフルエンスオペレーションとは?

生成AIが選挙にもたらしたリスク

生成AIは、ここ2年間で大きな話題を呼んでいます。生産性、創造性、コミュニケーションに多くの利点をもたらす生成AIは、仕事場や家庭に急速に浸透しました。しかし、生成AIの持つメリットそのものが、デジタル、物理的、そして政治的な様々な脅威を可能にするリスクを含んでいます。

生成AIには複数の悪用方法があります。例えば、フェイクニュースの迅速な作成、精巧なディープフェイク動画や音声の制作、ハッキングの自動化、説得力のあるフィッシングメッセージの作成などです。これらの情報が世論を操作するほどの影響力を持つ場合、選挙の公正性が脅かされる可能性があります。さらに、生成AIはSNS向けの魅力的なコンテンツ作成を助け、情報操作者が母国語話者でなくともほぼネイティブ並みの言語能力と文化的理解を提供します。

こうしたAIの潜在的なリスクは、AI技術のアクセスの容易さ(技術に詳しくない人でも簡単に利用できる)、生成速度(迅速に出力を生成できる)、拡張性(大規模に運用できる)などの特徴に後押しされ、ますます大きくなっています。

例えば、AIが搭載されたボットは、説得力のあるフェイクニュース記事を生成し、SNS上で人間のようなやり取りを模倣することもできます。これらのボットは瞬時に誤情報を作成するだけでなく、素早く効率的に拡散することができ、民主的プロセスの公平性に重大な脅威をもたらします。

さらにコンテンツ生成AI技術は、正しい情報と偽の情報を組み合わせ、どういった内容が最も効果的で広く共有されるかを学習するため、より巧妙な工作活動につながる可能性があります。

またテキストコンテンツの生成技術は、偽のウェブサイトの内容生成や特定の文体の模倣に使用できます。これは、政治家や候補者などの個人の文体を装った形で不正行為に悪用される可能性があります

2024年8月、CNNとCIR(Centre for Information Resilience、偽情報対策などを行うイギリスの非営利組織)の調査で、SNSプラットフォーム「X」で56件の偽アカウントが発見されました。これらのアカウントは2024年の米国大統領選挙でのトランプ候補やJ・D・ヴァンス副大統領候補を宣伝する組織的な工作活動の一部でした。ただし、トランプ陣営がこれに関与しているという証拠はありません。

同調査では、SNS上での怪しい活動に共通するパターンが明らかになりました。すべてのアカウントのアイコンは魅力的な若い女性の画像が使用されており、それらの画像は盗用されたものやAIによって生成されたものでした。画像はしばしば加工され、トランプやMAGA(「Make America Great Again:アメリカを再び偉大に」)のスローガンが画像内に追加されていました。

米国政府機関のFMIC(The Foreign Malign Influence Center、米国の民主主義や国益に対する悪意ある国外脅威について諜報活動を行う機関)も、説得力のある合成コンテンツ(音声や動画を含む)を作成するなどして、生成AIが選挙で利用されている事例を指摘しています。また最近のインドの選挙で、ナレンドラ・モディ首相や他の政治家(故人を含む)が意見の分かれる問題を議論する様子のAI生成広告に何百万人もが接触したことも指摘されています。

最近、米国司法省は、FOXニュースやワシントンポストなどの有名メディアを模倣した偽ニュースサイトを押収しました。これらの偽サイトには、読者の感情をロシアの利益に有利に傾けるように設計された記事が含まれていました。

ディープフェイクはすでに選挙で悪用されている

ディープフェイク技術の急速な進歩により、非常にリアルな画像や動画の作成が可能になりました。これは不正選挙や虚偽情報拡散の新たな手段となり、影響力のある個人や様々な業界の評判に深刻な被害を与える可能性があります。特に公人は、雑誌の写真、ニュースインタビュー、演説などメディアでの広範な生体情報が露出するため、悪用されるリスクが高くなっています。

ディープフェイク関連技術の発展により、技術に習熟していないサイバー犯罪者や政治犯でも、候補者や政治的イベントについて誤解を招きやすい巧妙な偽情報を作成できるようになりました。前章でも触れたインドの事例のようにインターネット上でのリアルタイムな交流が盛んな現代では、何百万人もの人々が不正なコンテンツにすぐに接触してしまう可能性があります。このリスクは、個人の信頼性の損害、偽情報の拡散、世論の操作、社会不安や政治的分断の助長に繋がります。

2024年8月、SNSは大統領候補カマラ・ハリスが虚偽の発言をしているAI生成動画広告で溢れかえりました。この偽の映像はイーロン・マスクのXアカウントで共有され、彼はそれを「パロディ」として擁護しました。さらに最近の動画では、ハリス候補が1980年代に性産業に関与していたという虚偽の主張がされました。これらの動画は虚偽であると証明されましたが、すべてのユーザが虚偽であることを認識したわけではないでしょう。

FMICが報告した別の事例では、中華人民共和国の関係者とみられる人々が台湾の大統領選挙に先立って複数の動画をオンラインに投稿したとされています。これらの動画では、AIで生成されたニュースキャスターが、これまたAIで作成されたと見られる本を使用して、当時の台湾の大統領についてのスキャンダル疑惑を議論していました。

これらの事例によってもたらされる深刻な問題の一つとして、多くの人々がオンライン上で流布されているすべての情報の真実性を疑い始めることが挙げられます。つまり、オンライン上の情報全体が疑わしいとみなされることにより、実際に現実で起こった真実の情報すら信用できなくなります。

これは選挙活動の文脈においては、オンラインで発信される支持政党の本来のメッセージが、多数の偽情報に埋もれて有権者に届かなかったり、その政党オリジナルのメッセージかどうか疑わしいと判断されたりするリスクを示しています。

また逆に支持政党が行った失言などを、自身の先入観に基づいて排除するための言い訳として「ディープフェイクによって作られたものだ」と誤認する恐れもあります。

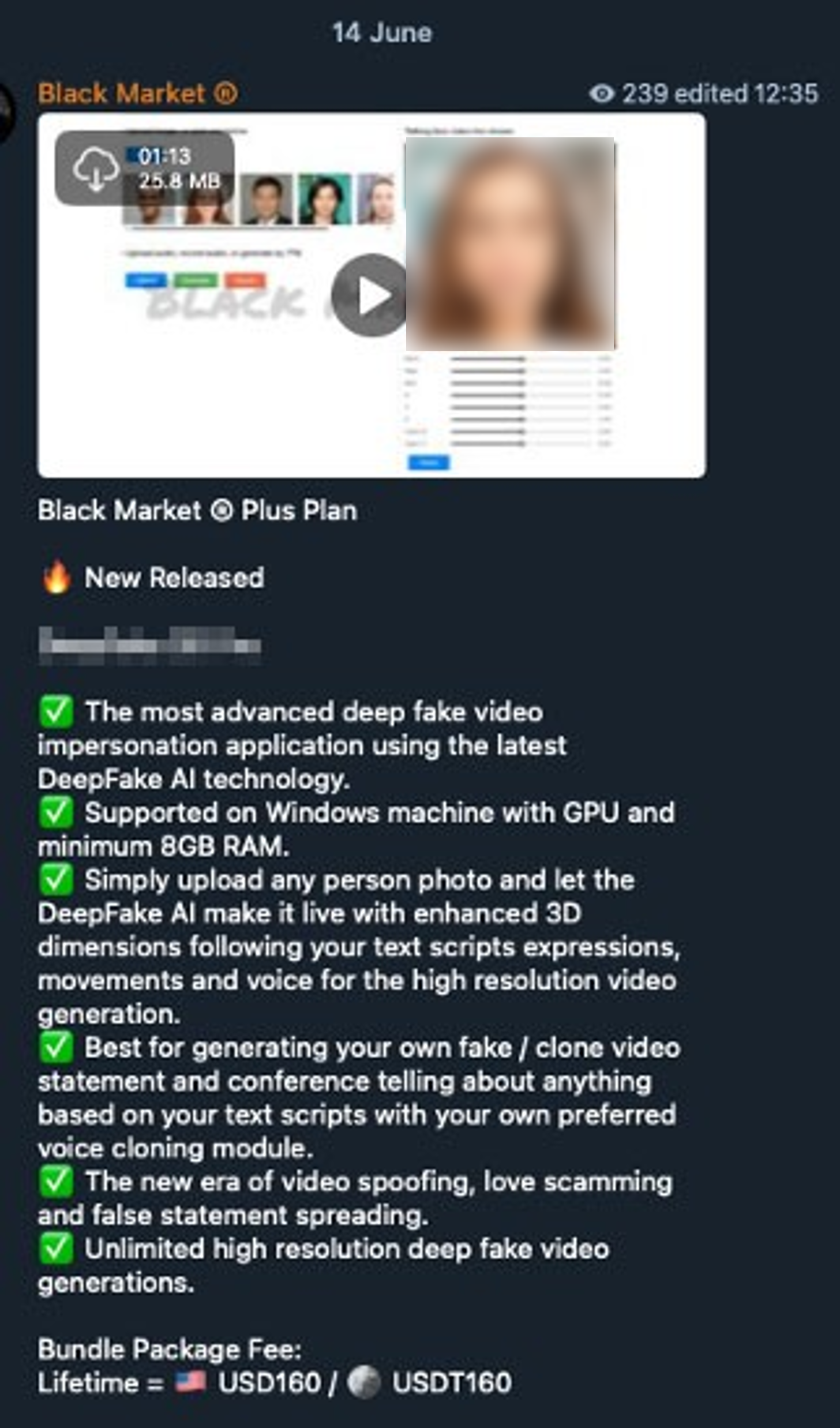

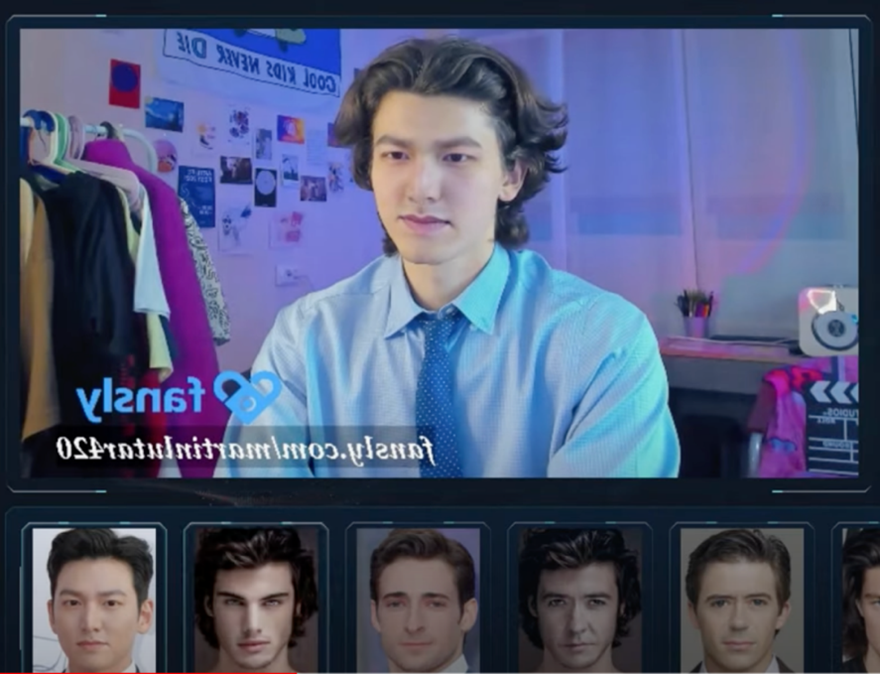

ディープフェイク技術が専門分野から誰でも使えるアプリへと進化したことは、世界中の民主主義に対する脅威の増大を意味します。ダークウェブで容易に入手可能なDeepfake 3D Pro、Deepfake AI、SwapFace、AvatarAI VideoCallSpooferなどのツールは、この脅威の増大を示しています。これらのツールは認証システムをすり抜け、問題のある動画を作成し、リアルタイムのビデオ通話を偽装することができ、結果として選挙の公正性を侵害することができます。

自分の意思を操作されないためには

プロパガンダやフェイクニュースが偽の現実を作り出す今の時代、私たちの意見や投票が操作されるのを防ぐ最も重要な防御策は、判断力を磨くことです。選挙に関連する情報の真偽を確認し、誤った情報がさらに広がるのを止める必要があります。

有権者であり情報の消費者でもある私たちは、不正選挙に対する防衛ラインの最前線に位置しています。批判的思考を働かせ、センセーショナルな見出し、怪しげなウェブサイト、文法の誤り、加工された画像、日時の欠如、出典不明のデータなどの、危険信号に注意を払うことでニュースの信頼性を見極める必要があります。

具体的な対策事項としては下記などが挙げられます。

・ニュース記事の見出しだけで判断せず内容をしっかり読む

・他のニュース媒体と照らし合わせる

・リンクや情報源を調べる

・著者の背景を確認する

・画像の真偽を確かめる

・ファクトチェック機関に相談する

また、重要なニュースがどのように展開されるかを観察することで、情報源の信頼性を判断することもできます。ニュースの情報源を複数持ち、信頼できる媒体を中心に、共有や転送を行う前によく考えることで、選挙に関連するフェイクニュースの拡散を防ぐことができます。

なお、警戒すべき範囲は、ニュースだけでなく、SMS、メール、仕事用アプリなど、情報を得るすべての媒体に及ぶ必要があります。信頼できるサイトから情報を得るのは良い習慣ですが、選挙に関する情報を読んだら、さらに別のメディアからも確認を取ることが重要です。信頼できるサイトでも、意図せずに間違った情報を広めてしまう可能性があることを忘れるべきではないでしょう

さらに、有権者はトレンドマイクロ ディープフェイクスキャンのような無料ツールを使って、ライブビデオ通話中にAIの顔交換技術を悪用する人々から身を守ることができます。この技術によって、ディープフェイクの「顔交換」技術で作成された偽情報の可能性があるコンテンツを見分けて警告を受け取ることができます。

サイバーセキュリティの分野では、「何も信用せず、すべてを確認する」というゼロトラストの考え方が存在しますが、特に選挙に関する情報を扱う場面でもこれは適用できます。これは単に何も信じないという意味ではなく、信頼する前に事実を確認し検証するということです。結局のところ、選挙のサイバーセキュリティにおけるAIとディープフェイクの悪用に対する最良の防御は、私たちの警戒心と懐疑的な態度です。情報操作者は常に人々の混乱や弱点につけ込もうとするからです。

これらは大変な課題だといえるでしょうか。確かにそうかもしれません。しかし、私たち自身と大切な人たちのために、これらを実践する責任が求められているのです。

関連記事:

・【AI Pulse】ディープフェイクを悪用した詐欺とインフルエンスオペレーション

・「ディープフェイクに関する実態調査2024年版」から見えてきた脅威を解説

・不正選挙につながりかねないサイバーリスクとは?

Security GO新着記事

MirrorFace(ミラーフェイス)とは?~警察が注意喚起を行った標的型攻撃グループを解説~

(2025年4月17日)

データ・サプライチェーンとは?マネジメント上の課題を解説する

(2025年4月17日)

セキュリティ・クリアランスとは?なぜ日本で必要性が高まっているのか?

(2025年4月15日)