AIセキュリティとは何か?(前編)~AIのセキュリティリスクとその対策を考える~

AI時代におけるセキュリティリスクとは何か。そして、私たちが取り得るリスク低減策とは?約20年前からAI技術に投資し、研究と製品開発を行ってきたトレンドマイクロの知見を交え、全2回にわたって考察します。

本記事に関連して、LLMアプリケーションに堅牢なセキュリティを実装するための開発者向けの包括的ガイド、「LEARNアーキテクチャ ~大規模言語モデル(LLM)アプリケーションセキュリティ実装のための5つのベストプラクティス~」も、あわせて参考にしてください。

AIセキュリティとは?

AIの活用が急速に進み、翻訳や資料作成などの業務への活用や、特定のユースケースに合わせた大規模言語モデル(LLM:Large Language Model)アプリケーションの構築、展開もさかんに行われています。一方で、AIにどのようなセキュリティリスクが存在しているのかという疑問や、それらのリスクに対してどのように対策を講じるべきかという課題を持つ方も多いのではないでしょうか?

現在、専門家やセキュリティ企業などが指摘しているAIのセキュリティリスクには、機密情報の漏洩、脆弱性を悪用した攻撃、プロンプトインジェクションなどが挙げられます。トレンドマイクロでは、こうしたリスクからLLMアプリケーションを含むAI環境を保護するためのセキュリティ対策を「AIセキュリティ」と考えています。

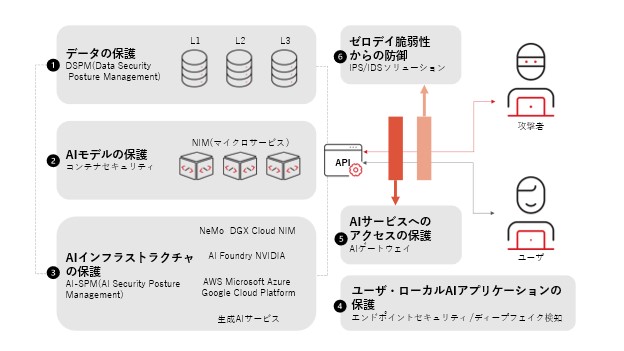

対策の検討にあたっては、LLMアプリケーションを構成するデータ・モデル・インフラストラクチャ、そのアプリケーションを利用するユーザ、アプリケーションへのアクセス、脆弱性などにおけるリスクを理解し、それらのリスクを低減するために何が必要かを確認することが重要です。

LLMアプリケーションの概要

まず、大規模言語モデル(LLM:Large Language Model)について軽く触れておきます。LLMとは生成AIの種類の一つであり、自然言語処理に優れたAIのモデルです。膨大な量のテキスト情報を学習したモデルであり、チャットや文書作成など、自然言語を扱う場において利用されています。よく知られるLLMとしては、OpenAI社の「GPT-3」、「GPT-4」や、Google社の「BERT」などが挙げられます。LLMには、広範なデータセットや特定分野に関する専門的なデータセットがトレーニングされたモデルや、特定のユースケースに応じてRAG技術によって外部ソースからのデータが統合されたモデルなどが存在し、LLMアプリケーションに活用されています。

またLLMでは、「プロンプトテンプレート」を活用することもできます。プロンプトテンプレートは、事前に準備された定型文のようなもので、立場(例:あなたは編集者です)、目的・背景(例:xxの魅力を発信しようとしています)、出力形式(例:箇条書きで、それぞれ200字程度で作成してください)などの入力項目があります。これに従って指示を入力することで、LLMのレスポンスの品質や内容をある程度制御し、用途や期待に沿った回答を得ることに役立ちます。

LLMアプリケーションの用途は、チャットボットやコンテンツ生成、翻訳、感情分析など多岐にわたり、教育や医療、カスタマーサービスなどのさまざまな分野で活用されています。

AIセキュリティの現状

冒頭で述べた通り、自組織向けのLLMアプリケーションに対するセキュリティ対策を講じるにあたって、課題を感じている方が多いと推測されます。

たとえば、開発が優先されるあまりに、セキュリティ対策の検討が開発段階の後半になって初めて行われ、セキュリティ担当者にとっていっそう複雑な作業となってしまう。あるいは、そもそもAIに関するナレッジが、セキュリティ部門や担当者に不足している。また、AI環境にはどのようなリスクや脆弱性があるのかについて十分に把握できていない、など。これが、LLMアプリケーション開発の現状ではないでしょうか。

上記のような課題に対して、次の解決策が考えられます。

●Security by design:セキュリティリスク低減を目的とした、開発の早期段階でのセキュリティ設計。

●クロスファンクションチームへの投資:各部門が他部門の専門領域に対する相互理解を深め、ナレッジのギャップを埋めることを目指す。つまり、開発部門はセキュリティリスクや脆弱性に対する理解を深め、一方のセキュリティ部門は機械学習アルゴリズムやLLMデータの処理などに対する理解を深める、など。

つまり、LLMアプリケーションのセキュリティ課題を解決するためには、ツールを導入するなどの技術的なソリューションだけではなく、組織的な戦略を考慮することが必要なのです。

AIセキュリティリスクにはどのようなものがある?

LLMアプリケーションの開発、利用にあたって、具体的にどのようなセキュリティリスクがあるのでしょうか?トレンドマイクロでは、LLMアプリケーションには、以下のようなアタックサーフェス(攻撃対象領域)が存在すると考えています。

●入力データ:AIモデルはデータに大きく依存しています。攻撃者は入力データを操作して不正確な出力を生成することができます。この手法は「敵対的攻撃(adversarial attacks)」として知られています。たとえば、AIモデルの入力データとして使用する画像に、人間にはわからない微小なノイズを足し合わせます。すると、その画像が示すものは、人間にとっては変更ありませんが、AIモデルはまったく別のものと認識してしまうことがあります。

●トレーニングフェーズ中のモデル:トレーニングフェーズ中に攻撃者がトレーニングデータセットにアクセスできる場合、偏ったデータや悪意のあるデータを導入してモデルを汚染させる可能性があります。これは「データポイズニング(data poisoning)」として知られています。

●APIおよびインターフェース:LLMアプリケーションがAPIを公開している場合、悪用される可能性があります。例えば、攻撃者は不正なリクエストを送信したり、インジェクション技術を使用したりすることによってAIにおけるデータ処理を操作しようとする場合があります。

●デプロイ済みのモデル:モデルがデプロイされた後、攻撃者は、モデルのふるまいを把握するために繰り返しクエリを送信してモデルを再構築しようとする「モデル抽出(model extraction)」のような手法を使用して、機密情報を抽出しようとする可能性があります。

●ユーザインターフェース:ユーザインターフェースが適切に保護されていない場合、攻撃者は不正アクセスを試みたり、悪意のあるスクリプトを注入したりすることができます。

●サードパーティライブラリ:多くのAIアプリケーションはサードパーティのライブラリやフレームワークに依存しています。これらに脆弱性がある場合、その脆弱性を悪用してアプリケーション全体を侵害する可能性があります。

●クラウドインフラストラクチャ:AIモデルがクラウドプラットフォーム上にホストされている場合、設定ミスにより、不正アクセスや攻撃(例:DoS攻撃)にさらされることがあります。

また、OWASP(オワスプ、Open Worldwide Application Security Project)は、定期的に発行するドキュメント「OWASP Top 10」(Webアプリケーションセキュリティに関する最も重大な10のリスクについてのランキングと修正のガイダンス)にて、2023年以降AI特有のリスクという新たなセクションを追加しています。2025年版の「OWASP Top 10 for LLM Applications 2025」では以下のようなリスクが提唱されています。

1. プロンプトインジェクション(Prompt Injection)

2. 機微な情報の漏洩(Sensitive Information Disclosure)

3. サプライチェーンの脆弱性(Supply Chain)

4. データおよびモデルの汚染(Data and Model Poisoning)

5. 不適切な出力(Improper Output Handling)

6. 過剰な代理行為(Excessive Agency)

7. システムプロンプトの漏洩(System Prompt Leakage)

8. ベクトルおよび埋め込みの脆弱性(Vector and Embedding Weaknesses)

9. 誤った情報(Misinformation)

10. 無制限のリソース消費(Unbounded Consumption)

上記のようなアタックサーフェスやリスクを把握することによって、組織はLLMアプリケーションに対して必要なセキュリティ対策を開発段階で適切に講じることが重要です。

参考記事:OWASPが提示するAIリスクのTop 10を読み解く(2023年のVersion 1.1版の解説)

6つのステップをひとつずつ順に見ていきましょう。

1. データの保護

昨今のデータ環境は複雑であり、LLMアプリケーションにおいて中核を担うため、セキュリティ対策を講じる上で、データの保護は非常に重要です。組織は、特に適切なデータ分類の難しさという課題に直面しています。適切なデータ分類がされていない場合、機密情報が不適切に取り扱われたり、露出したりするリスクがあります。データセキュリティポスチャマネジメント(DSPM)は、データを体系的に識別・分類し、機密性や規制要件に基づいた適切な保護を実現する、データ保護に有効な解決策の一つです。

2. AIモデルの保護

AIモデルは、スケーラビリティ、柔軟性、統合の容易さから、コンテナへの展開が進んでいます。その一方で、コンテナも攻撃のターゲットとなるリスクがあります。コンテナ上で実行されるAIモデルを保護するためには、脆弱性の検査やリアルタイムでの脅威検知をはじめとする堅牢なコンテナセキュリティ対策を実施する必要があります。

3. AIインフラストラクチャの保護

AIインフラストラクチャのセキュリティ、コンプライアンス、および整合性を維持するためには、AIセキュリティポスチャマネジメント(AI-SPM:AI Security Posture Management)が有効です。AI-SPMは、プロアクティブなリスク管理や設定ミスの特定、脆弱性の管理、コンプライアンス準拠状況の管理を実現し、組織にとって必要なリスクの把握、軽減、資産の保護、内部および外部のLLMアプリケーションに対する信頼向上へ貢献します。

4. ユーザおよびローカルAIアプリケーションの保護

多くの組織がAIをビジネスに取り入れていますが、データのプライバシーは依然として懸念事項であり、制限なくアクセスが行われる可能性のあるAIアプリケーションをどの程度信頼すべきかの基準は、容易には決定できません。例えば、従業員が許可されていないAIアプリケーションに機密情報を誤ってアップロードした場合、悪意のあるユーザがその情報を悪用するリスクがあります。また、不正コードを実行したり、危険なwebサイトにリダイレクトしたり、データを強要したり、ランサムウェアのペイロードを解放したりするためのソーシャルエンジニアリング攻撃を仕掛ける可能性があります。

こういったリスクに対して、ローカルAIアプリケーションの活用は、情報漏洩リスクを最小限に抑えるだけでなく、クラウドサービスと比較してプライバシーリスクを軽減します。情報漏洩の防止に有効なローカルAIアプリケーションですが、ローカルAIモデルの改ざんによって誤った出力を引き起こすリスクも存在します。AIモデルの改ざんを防止するために、AIアプリケーションが動作しているエンドポイント環境に対する監視や保護が必要です。

5. AIサービスへのアクセスの保護

組織がAI活用を推進する際には、自組織のLLMアプリケーションを含むAIサービスへのアクセスのセキュリティ対策も講じることが重要です。関連するリスクには、許可されていないAIサービスの使用、会社のポリシーへの非準拠、機微な情報の流出、悪意のあるプロンプトインジェクション攻撃などが挙げられます。さらに、セキュリティが確保されていないレスポンスは予測不可能な動作を引き起こし、特に組織がホストするプライベートAIモデルに対するDoS攻撃はAIサービスの運用を妨げる可能性があります。

これらのリスクを軽減するためには、ゼロトラスト原則に基づいたプライベートおよびパブリックAIサービスへのアクセス制御やプロンプト/レスポンスフィルタリング、接続制限が有効です。

6. ゼロデイ脆弱性からの防御

ゼロデイ攻撃は未知の脆弱性を狙い、機密情報の漏洩、事業停止、企業信頼度の低下を引き起こす可能性があります。AIが処理する機密データは、サイバー攻撃者にとって非常に魅力的であるため、攻撃者はセキュリティパッチが提供される前に脆弱性を悪用した攻撃を実行する可能性があります。ゼロデイ攻撃のリスク低減のために、IPS/IDSソリューションを活用し、リアルタイムでの脅威検知や挙動監視などが有効です。

トレンドマイクロが提案するAIセキュリティのベストプラクティス

トレンドマイクロでは、これまでAIや機械学習の技術を、マルウェア検知やセキュリティ運用アシストなどに活用するべく開発、提供してきました。その開発経験をもとに、LLMアプリケーションのセキュリティを確保するためのベストプラクティスを開発者が実装できるように、包括的なセキュリティフレームワークとして「LEARNアーキテクチャ」を提唱しています。

プロンプトインジェクション、データの公平性およびプライバシーの問題、ハルシネーション(生成AIが事実でない内容や存在しない事象について、もっともらしく回答する現象)などのリスクを特定のベストプラクティスにマッピングし、前述の「OWASP Top 10 for LLM Applications」に整合させることによって、開発者が安全で信頼性が高いLLMアプリケーションを構築することへ貢献します。

LLMアプリケーションに堅牢なセキュリティを実装するための、開発者向けの包括的なガイド、「LEARNアーキテクチャ ~大規模言語モデル(LLM)アプリケーションセキュリティ実装のための5つのベストプラクティス~」はこちらから入手できます。ぜひ参考にしてください。

次回「AIセキュリティとは何か?」の後編では、「Security for AI(AIのためのセキュリティ)」と「AI for Security(セキュリティのためのAI)」という2つの視点から、組織にはどのような対策が必要なのかを考えます。

後編はこちら。

<関連記事>

・AIセキュリティとは何か?(後編)~Security for AIとAI for Security~

・ディープフェイクとは?

・プロンプトインジェクションとは?

・AIの発展とその影響:2024年の世界の動向まとめ

・RAGとは?ChatGPTなどの生成AIの性能を向上する仕組み

・OWASPが提示するAIリスクのTop 10を読み解く(2023年のVersion 1.1版の解説)

Security GO新着記事

MirrorFace(ミラーフェイス)とは?~警察が注意喚起を行った標的型攻撃グループを解説~

(2025年4月17日)

データ・サプライチェーンとは?マネジメント上の課題を解説する

(2025年4月17日)

セキュリティ・クリアランスとは?なぜ日本で必要性が高まっているのか?

(2025年4月15日)