AIアシスタントのサイバーリスク分析 ~Alexa、ChatGPTからEDITHまで~

「アイアンマン」や「スパイダーマン」に登場するEDITHは、様々なシステムと繋がり無数の武装ドローンを操作できる架空のAIアシスタント。実在のAlexa、Siri、ChatGPT、Copilotなどとあわせ、AIアシスタントのサイバーリスク分析を試みました。

映画「アイアンマン」や「スパイダーマン」を見ていて、EDITHのようなAIアシスタントがあればどんなにいいだろうと思った方もいるかもしれません。あるいは、使い方次第では恐ろしいことになるに違いないと不安になった方もいるでしょう。もちろんEDITHはコミックや映画の中の存在ですが、現実の世界にもAIアシスタントは存在します。ご存じのとおり、AmazonのAlexa、AppleのSiri、それからChatGPT、Microsoft Copilotなどです。これらのAIアシスタントが「使い方次第では恐ろしいことになる」のは、現時点では考えにくいのですが、AIアシスタントが進化を続け、機能が高くなればなるほどリスクも増大していくことが考えられます。

トレンドマイクロでは、各AIアシスタントの機能にレベル付けを行い、想定されるサイバーリスクとのマッピングを行いました。この記事ではその一部を紹介します。全体のレポートは次のリンクからご覧ください。

参考記事:発展するAIアシスタント:そのセキュリティ懸念とリスク管理

AIアシスタントとは

AIアシスタントとは、音声などで入力した人間の依頼に応えるシステムのことです(ただし、その定義は常に変化していることにご留意ください)。

具体的には、AmazonのAlexa、AppleのSiri、Google アシスタントなどを指します。スマートスピーカーなど専用の機器にこれらのソフトウェアが搭載されており、たとえば音声で質問を入力すると、回答が返ってきます。Google アシスタントが搭載された機器であるGoogle Homeを例にすると「OK Google 今何時?」というように音声で質問すると、答えが返ってきます。

AIアシスタントを搭載した機器と言えば、上記のように、Googleアシスタントが搭載されたスマートスピーカー「Google Home」、Alexaが搭載されたスマートスピーカー「Amazon Echo」などを思い浮かべる方が多いと思いますが、実は他にも様々な機器に搭載されています。たとえばAlexaは、AmazonのWebサイトによると、スクリーン付きのEcho Showシリーズ、高音質な3Dサウンドを再生するEcho Studio、Fire TVシリーズやFireタブレットシリーズなどのAmazonデバイスをはじめ、自動車やスマートフォン、パソコン、ヘッドフォン、テレビ、電子ピアノなどの他社製品にいたるまで、さまざまなデバイスに搭載されているようです。

当社ではAIアシスタントのリスクを分析するにあたって、Alexa、Siri、MicrosoftのCortana、Google アシスタントを第1世代のAIアシスタントと位置付けています。これらのAIアシスタントは2014年頃に誕生しました。AIアシスタントやスマートスピーカーの市場を切り開いた製品であるといえるでしょう。

AIアシスタントを取り巻く身近な問題

AIアシスタントを取り巻く身近な問題にはどのようなものがあるでしょうか。

まず1つ目には「誤作動」が挙げられます。通常AIアシスタントでは、質問をインプットするには「特定の言葉+質問」が必要です。Google Homeを例にすると「OK Google」が特定の言葉、「今何時?」が質問です。「特定の言葉」は、日常の会話すべてにGoogle Homeが反応しないようにするために、「Google Homeに話しかけている」ということを明確にする言葉です。しかし、たとえば自宅からオンラインミーティングに参加していると、突然後ろでAmazon EchoやGoogle Homeが話し出したという経験がある方は多いのではないでしょうか。オンラインミーティングで話している言葉が、AIアシスタントへ問いかける特定の言葉(OK Googleなど)に近しい場合などに誤作動を起こしているのかもしれません。

他にも「ハルシネーション」、つまりAIが誤った回答を出してしまう、ということも多くの方が経験していると思います。最近では、Google検索などで言葉を検索する際、検索結果の上部にAIによる要約が表示されることもありますが、明らかに間違った内容を目にした方もいるのではないでしょうか。

このように身近な問題だけであれば、それ程の影響はないかもしれませんが、AIアシスタントの進化に伴って、起こり得るリスクが増大する可能性があります。ここからはAIアシスタントの進化とそれに伴うリスクを解説します。

機能のレベル付けから見えるAIアシスタントの進化

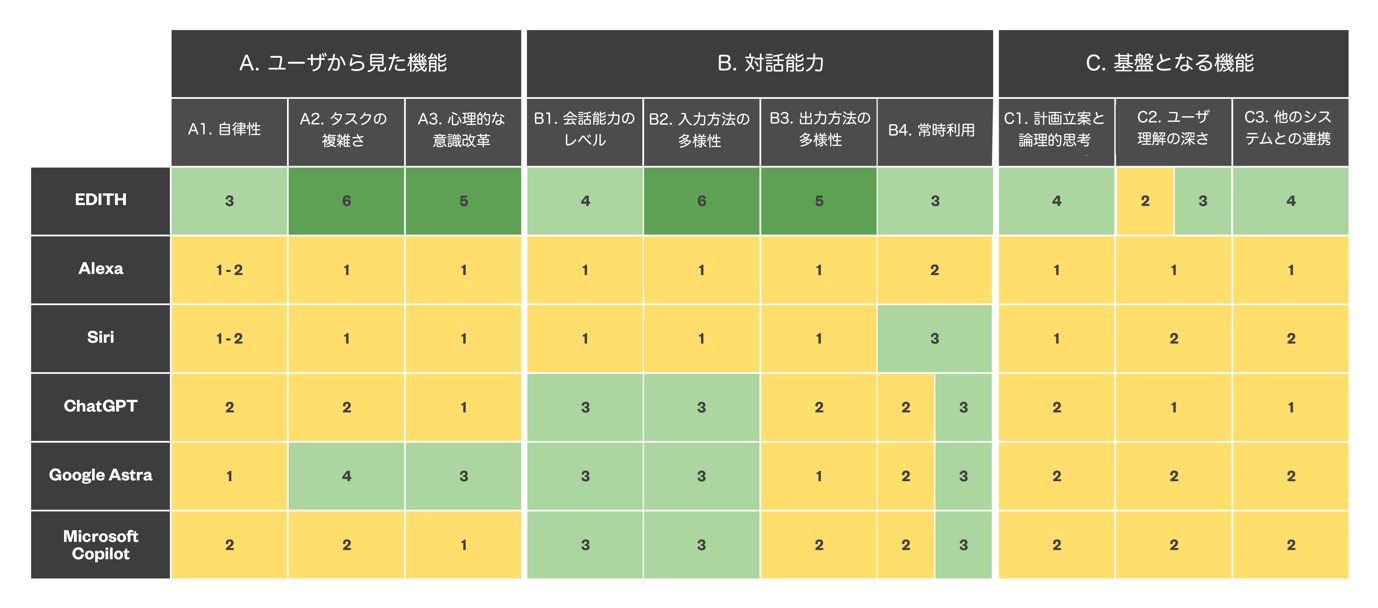

トレンドマイクロでは、AIアシスタントのリスクを分析するにあたり、AIアシスタントを3世代に分類しました。第1世代は、Alexa、Siri、Cortana、Google アシスタントです。第2世代(現在)は、ChatGPT、Microsoft Copilot、Google Astraです。そして、第3世代は、「アイアンマン」や「スパイダーマン」の世界に出てくるトニー・スタークの創造物である EDITH(Even Dead I'm The Hero)です。EDITHはフィクションですが、将来の発展の可能性を示す興味深い例であるため、第3世代として分析に加えます。

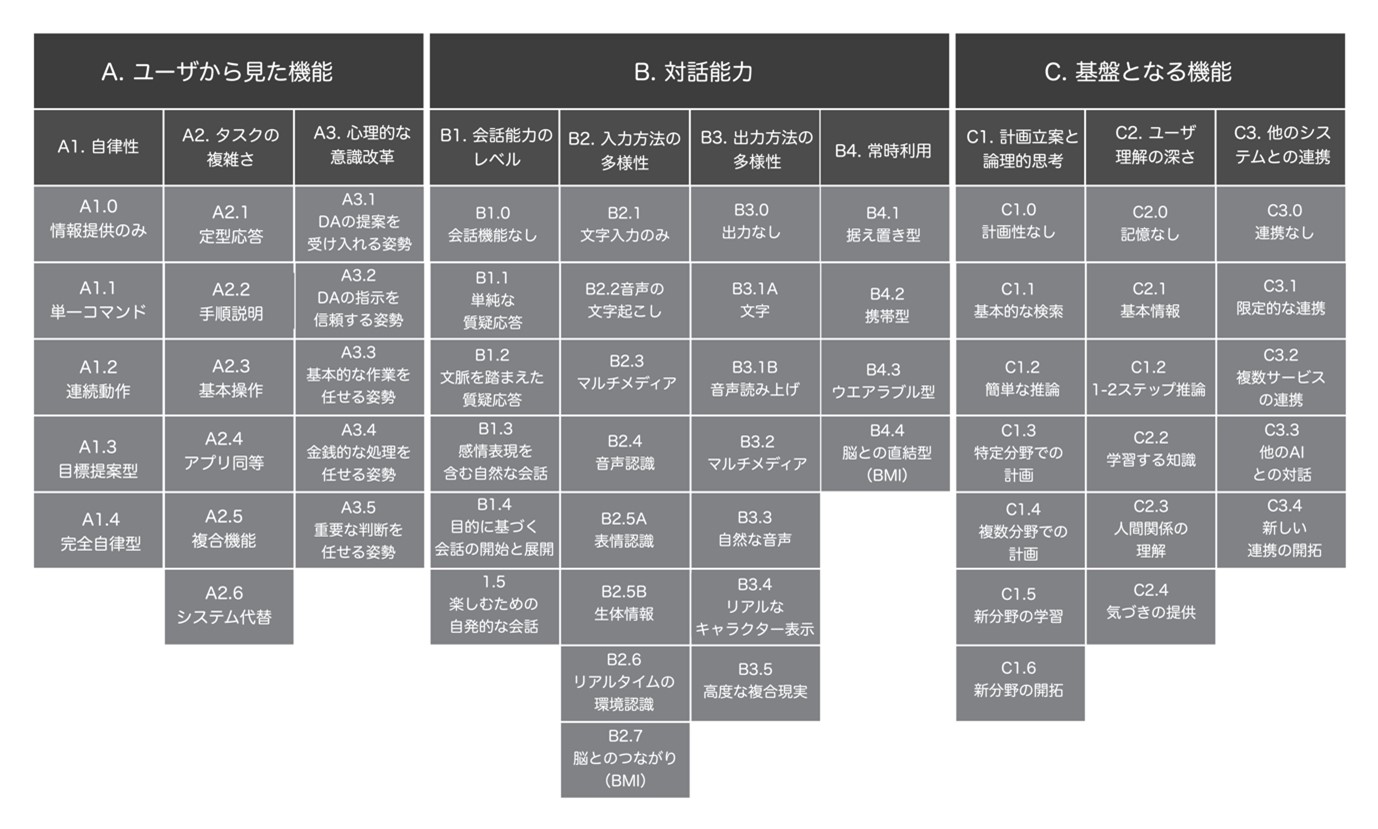

AIアシスタントの機能を3つのカテゴリに分類(下図のA、B、C)、さらに10の項目に細分化し(A1~A3、B1~B4、C1~C3)、各世代についてレベル付けを行いました。

上図のうち、たとえば「A.ユーザから見た機能」というカテゴリの「A1.自律性」という項目は、以下の5つのレベルに分類できます。

| A1.0 | 情報提供のみ:リクエストに応じてのみ情報を提供 |

| A1.1 | 単一コマンド:アラームの設定など、一つのコマンドで一つの動作を実行 |

| A1.2 | 連続動作:「おやすみ」という一つの命令で、シェードを下ろし、照明を消すなど、複数の動作を連続して実行 |

| A1.3 | 目的提案型:ユーザの承認を得たうえで、特定の目標を達成するためのアクションを提案 |

| A1.4 | 完全自律型:ユーザの利益を考慮しながら独立して意思決定を行い、監督なしで行動 |

表:自律性の5つのレベル

AlexaやSiriなど第1世代のAIアシスタントはA1.2までのレベル、つまり「単一コマンド:アラームの設定など、一つのコマンドで一つの動作を実行」や「連続動作:『おやすみ』という一つの命令で、シェードを下ろし、照明を消すなど、複数の動作を連続して実行」などを実行できると考えられます。第3世代のEDITHは、「目的提案型:ユーザの承認を得たうえで、特定の目標を達成するためのアクションを提案」できるレベルにあると考えられます。「アイアンマン」や「スパイダーマン」の映画をご覧になるとわかりますが、EDITHは現在の状況を把握し、それを操作する人物(ここではスパイダーマンことピーター・パーカー)に「〇〇を用いて攻撃しますか?」などの提案をします。

そのほかのAIアシスタントも含めて、それぞれの機能をレベル付けした結果は以下のとおりです。

AIアシスタントで考えるべきサイバーリスク

ここまでAIアシスタントの世代や種類ごとに提供する機能を見てきました。機能に差があるということは、サイバーリスクによる影響の有無や影響度も異なるということです。高機能な方が、リスクが大きくなる場合もあれば、高機能なことでその脅威が通じなくなるという両面が存在します。リスクの具体的な内容をあげ、AIアシスタントの機能レベルとマッピングし、脅威がどう影響するのかを見ていきたいと思います。

具体例として「スキル名の類似性を悪用した攻撃(Skill squatting)」を見ていきたいと思います。この攻撃は、正規のスキル名と似た発音の名前や、ユーザが間違えやすい発音を利用するものです。攻撃者が、正規のスキルと紛らわしい名前の悪意あるスキルを作成します。ユーザが正規のスキルを呼び出そうとして名前を少し違って発音すると、AIアシスタントが誤って悪意あるスキルを起動してしまう可能性があります。例えば、「ホテル(Hotel)」を探すスキルに対して「ハウテル(Howtel)」という紛らわしい名前のスキルを作成するといった手法です。

この攻撃では、B1.会話能力のレベルが1のもの(具体例としてはAlexaやSiri)には影響を与える懸念があります。逆に、単純なキーワードや質問によるものではなく、文脈まで読み取って対応するといった会話能力のレベルが3であるChatGPTやMicrosoft Copilotではやり取りが高度になることもあり、影響を与える懸念は低いと言えます。

次にもう1つの例を見ていきたいと思います。「メタバース内の悪意あるアバターによるなりすまし詐欺(Malicious Metaverse avatar DA phishing)」です。AIアシスタントになりすました悪意のあるアバター(偽物)が、本物のAIアシスタントの見た目や振る舞い、話し方を真似し、ユーザの信頼を得て、パスワードや個人情報、金融情報といった機密情報を引き出すといった攻撃です。以下の図を見ると、先ほどの例とは逆に、機能が高度なものに対する懸念が高いことがわかると思います。そもそもメタバースが存在するような状況でなければ実現しないような脅威であるためです。

このように進化が見込まれるシステムにおいては、その時々で考えられる脅威のシナリオも変わってきます。今後進化が加速するであろうAIアシスタントにおいては、その変化が顕著であることが伺えます。一般的に、セキュリティ対策は年月の経過や社会情勢の変化などとともに“常識が変わる”ことが多々あります。AIアシスタントのサイバーリスクを含め、常に最新の動向を把握し、その時々で必要な対策をご検討下さい。

AIアシスタントのサイバーリスク分析に関する詳細は、以下の記事をご覧ください。

発展するAIアシスタント:そのセキュリティ懸念とリスク管理

現在および将来のAIアシスタントが持つ機能を分析し、攻撃者の視点から考えることで、次世代AIアシスタントがもたらす潜在的な脅威に正面から向き合い、一般の人々が注意すべき危険性を明らかにすることにしました。

詳しくはこちら→

執筆者

高橋 昌也

トレンドマイクロ株式会社

シニアスペシャリスト

PCサーバ Express5800、ファイアウォール、ネットワーク検疫、シンクライアントのプロダクトマーケティングマネージャーに従事した後、2009年にトレンドマイクロ入社。

2012年当時、業界に先駆けて日本国内への標的型攻撃(APT)について、統計データを用いた情報発信をリード。

現在は、リサーチャーと連携し、サイバーリスクマネジメントやAIセキュリティに関する情報発信を行う。

取引先への個人情報監査やサプライチェーンリスクマネジメントも担う。

主なメディア出演:日本テレビ(NEWS ZERO)、フジテレビ(めざましテレビ)、テレビ朝日(報道ステーション)、TBS(林先生が驚く初耳学!)、日本経済新聞、朝日新聞、毎日新聞、読売新聞、産経新聞など