Inteligência artificial (IA) é uma tecnologia que capacita computadores e máquinas a aprender, entender, criar, resolver problemas, prever resultados e tomar decisões.

Índice

No nível mais básico, IA se refere a sistemas de computador ou máquina que usam tecnologias como machine learning (ML), redes neurais e arquiteturas cognitivas para executar tipos de tarefas complexas que antes apenas seres humanos eram capazes de realizar.

Isso inclui tudo, desde criação de conteúdo até planejamento, raciocínio, comunicação, aprendizado com a experiência e tomada de decisões complexas. Dito isso, como os sistemas e ferramentas de IA são tão amplos e variados, nenhuma definição única se aplica perfeitamente a todos.

Desde que a IA foi introduzida pela primeira vez na década de 1950, ela transformou praticamente todos os aspectos da vida moderna, da sociedade e da tecnologia. Com sua capacidade de analisar grandes quantidades de dados, entender padrões e adquirir novos conhecimentos, a IA se tornou uma ferramenta indispensável em praticamente todos os campos da atividade humana, de negócios e transporte a saúde e Cibersegurança.

Entre outras aplicações, as organizações usam IA para:

- Reduza custos

- Impulsionar a inovação

- Capacitar equipes

- Otimizar operações

- Acelerar a tomada de decisões

- Consolidar e analisar descobertas de pesquisas

- Oferecer suporte e atendimento ao cliente rápidos

- Automatizar tarefas repetitivas

- Auxiliar na geração de ideias

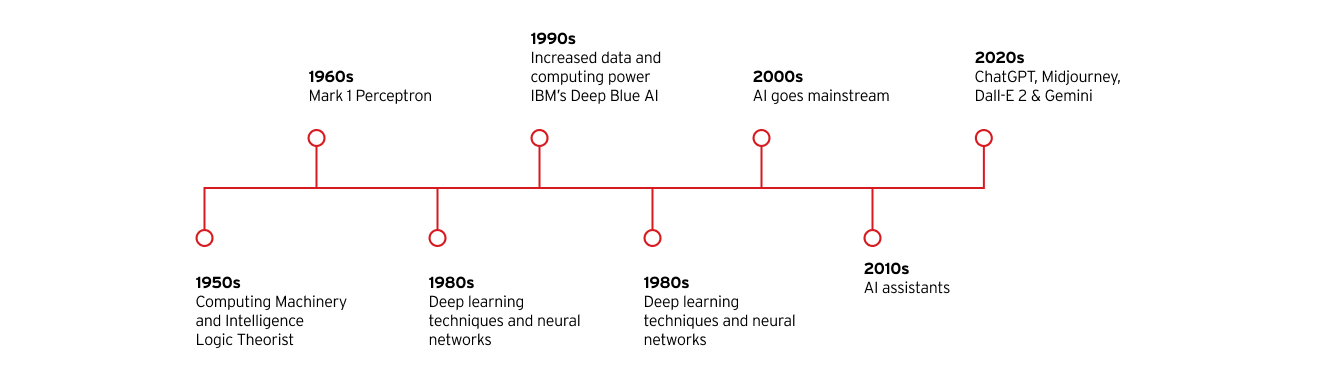

Uma breve história da IA

A ideia de uma máquina que pode pensar por conta própria remonta a milhares de anos. Em seu contexto moderno, inteligência artificial como conceito definido pode ser rastreada até o ano de 1950, quando o matemático e cientista da computação Alan Turing — criador do famoso “Teste de Turing” — publicou seu artigo influente sobre o conceito de inteligência artificial, Computing Machinery and Intelligence.

Nas décadas desde que o artigo de Turing foi publicado pela primeira vez, a IA passou por uma evolução dramática em seu escopo e recursos, impulsionada por avanços exponenciais em poder de computação, sofisticação algorítmica, disponibilidade de dados e introdução de tecnologias como machine learning, data mining e redes neurais.

Principais marcos na evolução da inteligência artificial

Ano

Etapas

Década de 1950

- Publicação de "Computing Machinery and Intelligence" de Alan Turing

- John McCarthy cria o termo "inteligência artificial"

- Criação do Logic Theorist, o primeiro programa de IA

Década de 1960

- Criação do Mark 1 Perceptron, o primeiro computador a aprender por tentativa e erro

Década de 1980

Crescimento das técnicas de aprendizado profundo e redes neurais

Década de 1990

- Aumento dos dados e do poder de computação acelera o crescimento de, e investimento em, IA

Deep Blue da IBM derrota o campeão mundial de xadrez Garry Kasparov

Década de 2000

- A IA se torna mainstream com o lançamento do motor de busca com IA do Google, o sistema de recomendação de produtos da Amazon, o sistema de reconhecimento facial do Facebook e os primeiros carros autônomos

Década de 2010

- Assistentes de IA como Siri da Apple e Alexa da Amazon são introduzidos

- O Google lança seu framework de machine learning de código aberto, TensorFlow

- A rede neural AlexNet populariza o uso de unidades de processamento gráfico (GPUs) para treinar modelos de IA

Década de 2020

- A OpenAI lança a terceira iteração do seu popular modelo de linguagem ChatGPT

- A onda GenAI continua com o lançamento de geradores de imagens como Midjourney e Dall-E 2 e chatbots LLM como Gemini do Google

Como a IA funciona?

Sistemas de IA funcionam ao ingerir grandes quantidades de dados e usar processos cognitivos humanos para analisar e avaliar esses dados. Ao fazer isso, os sistemas de IA identificam e categorizam padrões e os usam para executar tarefas ou fazer previsões sobre resultados futuros sem supervisão ou instruções diretas de humanos.

Por exemplo, um programa de IA gerador de imagens como Midjourney que recebe grandes quantidades de fotografias pode aprender a criar imagens "originais" com base em instruções dadas por um usuário. Da mesma forma, um chatbot de IA de atendimento ao cliente treinado em grandes volumes de texto pode aprender a interagir com clientes de uma maneira que imita agentes humanos de atendimento ao cliente.

Embora cada sistema seja diferente, todos os modelos de IA geralmente são programados seguindo o mesmo processo de cinco etapas:

- Treinamento— o modelo de IA recebe grandes quantidades de dados e utiliza uma série de algoritmos para analisar e avaliar esses dados.

- Raciocínio—o modelo de IA categoriza os dados recebidos e identifica quaisquer padrões nessas informações.

- Ajuste fino—à medida que o modelo de IA testa diferentes algoritmos, ele aprende quais tendem a ser mais bem-sucedidos e ajusta suas ações de acordo.

- Criação—o modelo de IA utiliza o que aprendeu para executar tarefas atribuídas, tomar decisões ou criar música, texto ou imagens.

- Aprimoramento—por fim, o modelo de IA faz ajustes contínuos e constantes para melhorar sua precisão, efetivamente "aprendendo" com sua experiência.

Machine learning vs. deep learning

A maioria dos sistemas modernos de IA utiliza uma variedade de técnicas e tecnologias para simular os processos da inteligência humana. As mais importantes dessas são deep learning e machine learning (ML). Embora os termos machine learning e deep learning às vezes sejam usados como sinônimos, na verdade são processos bastante distintos no contexto do treinamento de IA.

Machine learning usa algoritmos para analisar, categorizar, classificar, aprender e interpretar grandes quantidades de dados para produzir modelos precisos e prever resultados sem precisar ser instruído exatamente sobre como fazê-lo.

Deep learning é uma subcategoria de machine learning que atinge os mesmos objetivos utilizando redes neurais para imitar a estrutura e a função do cérebro humano. Vamos explorar ambos os conceitos com mais detalhes a seguir.

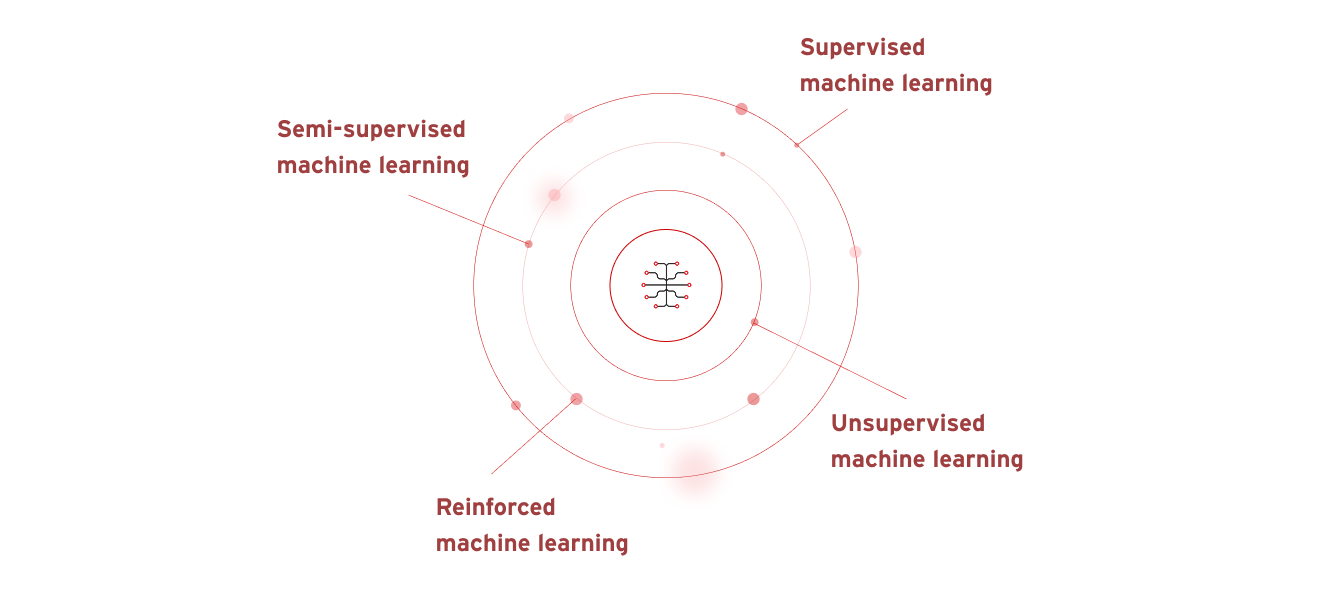

Princípios básicos de machine learning

Existem quatro tipos principais de machine learning:

- Supervised machine learning— a IA utiliza conjuntos de dados que são conhecidos, definidos e classificados para descobrir padrões antes de aplicar o algoritmo.

- Semi-supervised machine learning—a IA é treinada com um conjunto de dados rotulado e conhecido, que depois aplica a conjuntos de dados maiores, não rotulados e desconhecidos.

- Unsupervised machine learning—a IA aprende a partir de conjuntos de dados que são desconhecidos, não rotulados e não classificados.

- Reinforced machine learning—o modelo de IA não é treinado inicialmente com nenhum conjunto de dados, então aprende por tentativa e erro e altera seus comportamentos até alcançar o sucesso.

Machine learning é o que permite que carros autônomos respondam às mudanças no ambiente ao ponto de poderem levar seus passageiros com segurança ao destino escolhido. Outras aplicações de machine learning vão desde o reconhecimento de imagem e fala, aplicativos de tradução de idiomas, aplicativos impulsionados por IA, e mineração de dados para detecção de fraude em cartões de crédito, diagnósticos de saúde, e recomendações em mídias sociais, produtos ou marcas.

Aprendizado profundo e redes neurais

O aprendizado profundo é uma forma de machine learning baseada no uso de redes neurais avançadas — algoritmos de machine learning que imitam como os neurônios no cérebro humano funcionam para identificar padrões complexos em grandes conjuntos de dados.

Por exemplo, mesmo crianças muito pequenas conseguem distinguir instantaneamente seus pais de outros adultos porque seus cérebros conseguem analisar e comparar centenas de detalhes únicos ou distintivos em um piscar de olhos, desde a cor dos olhos até expressões faciais difíceis de diferenciar.

As redes neurais replicam o modo como os cérebros humanos funcionam ao analisar milhares ou milhões de detalhes nos dados que recebem para detectar e reconhecer padrões maiores entre eles. Sistemas de IA generativa (ou “GenAI”) como o ChatGPT da OpenAI ou o gerador de imagens Midjourney, por exemplo, usam aprendizado profundo para ingerir e analisar grandes quantidades de imagens ou texto, e então usam esses dados para criar novos textos ou imagens que são semelhantes — mas diferentes — dos dados originais.

Quais são os avanços mais recentes em IA?

Nos últimos anos, inovações revolucionárias em processamento de linguagem natural, visão computacional, aprendizado por reforço e tecnologias de ponta como redes adversárias generativas (GANs), modelos transformadores, e verdadeiras máquinas habilitadas por IA (AIEMs) expandiram enormemente os recursos dos sistemas de IA para imitar mais de perto os processos da inteligência humana, gerar conteúdo mais realista e realizar tarefas cada vez mais complexas.

Avanços em machine learning e aprendizado profundo

Nos últimos anos, inovações revolucionárias em processamento de linguagem natural, visão computacional, aprendizado por reforço e tecnologias de ponta como redes adversárias generativas (GANs), modelos transformadores, e verdadeiras máquinas habilitadas por IA (AIEMs) expandiram enormemente os recursos dos sistemas de IA para imitar mais de perto os processos da inteligência humana, gerar conteúdo mais realista e realizar tarefas cada vez mais complexas.

Avanços em machine learning e aprendizado profundo

Avanços revolucionários em algoritmos de machine learning e aprendizado profundo permitiram que pesquisadores e desenvolvedores criassem sistemas de IA incrivelmente sofisticados para uma grande variedade de aplicações no mundo real.

Aplicativos de chatbot, por exemplo, são usados por milhões de empresas todos os dias para responder perguntas, vender produtos e interagir com seus clientes. As empresas também usam algoritmos de IA para descobrir tendências com base em compras passadas e fazer recomendações personalizadas de novos produtos, marcas ou serviços.

No campo do reconhecimento automático de fala (ASR), serviços de IA como Siri e Alexa usam processamento de linguagem natural (NLP) para traduzir fala humana em texto escrito. Da mesma forma, os avanços nas redes neurais de “visão computacional” impulsionadas por IA facilitaram a marcação de fotos em mídias sociais e tornaram os carros autônomos mais seguros.

Outros exemplos do uso de IA com machine learning ou aprendizado profundo incluem algoritmos automatizados de negociação de ações, robôs inteligentes que podem executar tarefas repetitivas em fábricas ou linhas de montagem, e o uso de machine learning para ajudar bancos a identificar transações suspeitas e impedir fraudes financeiras.

O papel em evolução da IA na Cibersegurança

Quando se trata do papel da IA na Cibersegurança, há duas áreas distintas, mas inter-relacionadas a considerar: Segurança da IA e Cibersegurança da IA.

A AI security (também chamada de segurança para IA) refere-se ao uso de medidas de Cibersegurança para proteger a pilha de IA de uma organização, reduzir ou eliminar os riscos de segurança da IA, e proteger cada sistema de IA, componente e aplicação em toda a rede, desde os Endpoints até os modelos de IA. Isso inclui:

- Proteger a stack de IA, infraestrutura, modelos e dados de treinamento contra ataques

- Manter a integridade dos dados das pipelines de machine learning e aprendizado profundo

- Abordar questões de viés de IA, transparência, explicabilidade e outras preocupações éticas

Garantir que o uso ou desenvolvimento da IA esteja totalmente em conformidade com todas as leis, políticas e regulamentações relevantes

A Cibersegurança da IA cobre todas as diferentes formas pelas quais ferramentas habilitadas por IA podem, de forma proativa, aprimorar as defesas de Cibersegurança de uma organização mais rapidamente, com maior precisão e eficácia do que qualquer equipe humana de Cibersegurança ou centro de operações de segurança (SOC) poderia. Isso inclui o uso da IA para:

- Identificar ameaças cibernéticas e defender-se contra ataques cibernéticos em tempo real

- Eliminar lacunas e vulnerabilidades de Cibersegurança mais rapidamente e com maior precisão

- Automatizar a detecção e resposta a ameaças e outras ferramentas de Cibersegurança para resposta a incidentes mais rápida

- Aprimorar a inteligência contra ameaças para capacitar ou dar suporte a uma gestão de ameaças mais eficiente

- Automatizar tarefas rotineiras como varredura de vulnerabilidades e análise de logs de dados para liberar a equipe de Cibersegurança a fim de lidar com ameaças mais complexas

Exemplos de aplicações de IA em Cibersegurança

As organizações já estão usando IA de várias formas para aprimorar sua postura de Cibersegurança, detectar e responder a ataques cibernéticos, e defender suas redes contra ameaças cibernéticas como violações de dados, ataques de negação de serviço distribuída (DDoS), ransomware, malware, ataques de phishing e ameaças à identidade.

Na área de detecção e resposta a ameaças, a IA pode identificar e prever ameaças cibernéticas, analisar padrões em registros de atividades e tráfego de rede, autenticar e proteger senhas e registros de usuários, empregar reconhecimento facial e logins CAPTCHA, simular ataques cibernéticos, fazer varreduras em busca de vulnerabilidades na rede, e criar defesas automatizadas contra ameaças novas ou emergentes. Isso inclui ferramentas como:

- Firewalls de próxima geração impulsionados por IA (NGFWs)

- Gerenciamento de informações e eventos de segurança da IA (SIEM)

- Sistemas de segurança de endpoint e nuvem de IA

- Detecção e resposta de rede de IA (NDR)

- Detecção e resposta estendidas de IA (XDR)

Quando um ataque ocorre, a IA também pode oferecer estratégias eficazes de remediação ou responder automaticamente a incidentes de segurança com base nas políticas e playbooks predefinidos da organização. Isso pode ajudar a reduzir os custos e minimizar os danos de um ataque, além de permitir que as organizações se recuperem mais rapidamente.

Quais considerações éticas estão envolvidas no desenvolvimento e uso da IA?

A IA claramente oferece uma série de vantagens poderosas em relação a outros tipos de sistemas computacionais. Mas, como com qualquer nova tecnologia, há riscos, desafios e questões éticas que precisam ser considerados no desenvolvimento, adoção e uso da IA.

Viés e justiça

Os modelos de IA são treinados por seres humanos usando dados provenientes de conteúdos existentes. Isso cria o risco de que o modelo possa refletir ou reforçar quaisquer vieses implícitos contidos nesse conteúdo. Esses vieses podem potencialmente levar a desigualdade, discriminação ou injustiça nos algoritmos, previsões e decisões tomadas com base nesses modelos.

Além disso, como o conteúdo que eles criam pode ser tão realista, ferramentas GenAI têm o potencial de ser mal utilizadas para criar ou disseminar desinformação, informação enganosa, conteúdo prejudicial, e vídeos, áudios e imagens deepfake.

Preocupações com privacidade

Também há diversas preocupações com a privacidade envolvendo o desenvolvimento e uso da IA, especialmente em indústrias como saúde, setor bancário e serviços jurídicos, que lidam com informações altamente pessoais, sensíveis ou confidenciais.

Para proteger essas informações, as aplicações impulsionadas por IA devem seguir um conjunto claro de boas práticas em segurança de dados, privacidade e proteção de dados. Isso inclui o uso de técnicas de anonimização de dados, implementação de criptografia robusta de dados e a adoção de defesas avançadas de Cibersegurança para proteger contra roubo de dados, vazamentos e ataques de hackers.

Conformidade regulatória

Muitas agências e estruturas regulatórias, como o Regulamento Geral de Proteção de Dados (GDPR), exigem que as empresas sigam conjuntos claros de regras quando se trata de proteger informações pessoais, garantindo transparência, prestação de contas e proteção da privacidade.

Para cumprir com essas regulamentações, as organizações devem garantir que possuem políticas corporativas de IA para monitorar e controlar o uso de dados usados na construção de novos modelos de IA, e proteger qualquer modelo de IA que possa conter informações sensíveis ou pessoais contra agentes mal-intencionados.

Qual é o futuro da tecnologia de IA?

O que acontecerá no futuro da IA é, claro, impossível de prever. Mas é possível fazer algumas suposições fundamentadas sobre o que vem a seguir com base nas tendências atuais no uso e na tecnologia de IA.

Tendências emergentes na pesquisa em IA

Em termos de pesquisa em IA, inovações em sistemas autônomos de IA, meta-IA e meta-aprendizado, aprendizado aberto com LLMs (modelos de linguagem de grande porte), digital twins e testes de validação de riscos com red teaming, e a tomada de decisão conjunta homem-IA podem revolucionar a forma como a IA é desenvolvida.

Novos sistemas complexos como IA neuro-simbólica, verdadeiras máquinas habilitadas por IA (AIEMs), e machine learning quântico provavelmente também ampliarão ainda mais o alcance e as capacidades dos modelos, ferramentas e aplicações de IA.

Outra tecnologia com potencial para revolucionar a forma como a IA funciona é o avanço em direção à agentic AI de próxima geração — uma IA que tem a capacidade de tomar decisões e agir por conta própria, sem orientação, supervisão ou intervenção humana.

Segundo o analista de tecnologia Gartner, até o ano de 2028, a agentic AI poderá ser usada para tomar até 15% de todas as decisões de trabalho do dia a dia. As interfaces de usuário (UI) de agentic AI também poderão se tornar mais proativas e orientadas por personas, à medida que aprendem a agir mais como agentes humanos com personalidades definidas, executar tarefas de negócios mais complexas, tomar decisões empresariais mais importantes e fornecer recomendações mais personalizadas aos clientes.

Impactos potenciais da IA na força de trabalho

À medida que a IA aumenta a eficiência operacional e assume tarefas rotineiras, e à medida que motores GenAI como ChatGPT e Midjourney se tornam mais poderosos e amplamente utilizados, há preocupações válidas sobre o possível impacto da IA nos empregos em inúmeras indústrias.

Mas, assim como ocorreu com a introdução da internet, computadores pessoais, telefones celulares e outras tecnologias disruptivas no passado, a IA provavelmente também criará novas oportunidades e até mesmo novas indústrias inteiras que precisarão de trabalhadores qualificados e talentosos.

Como resultado, mais do que lidar com a perda de empregos, o maior desafio pode ser determinar como treinar trabalhadores para essas novas oportunidades e facilitar suas transições de indústrias em declínio para setores em crescimento.

O papel da IA na abordagem de desafios globais

Além de aumentar a eficiência operacional e aprimorar a Cibersegurança, a IA tem o potencial de ajudar a resolver alguns dos maiores desafios enfrentados pela humanidade hoje.

No campo da saúde, a IA pode ajudar médicos a fazer diagnósticos mais rápidos e precisos, rastrear a disseminação de surtos pandêmicos e acelerar a descoberta de novos medicamentos, tratamentos e vacinas.

As tecnologias de IA podem melhorar a velocidade e a eficiência das respostas emergenciais a desastres causados por humanos e a eventos climáticos severos.

A IA também poderia ajudar a enfrentar as mudanças climáticas ao otimizar o uso de energia renovável, reduzir a pegada de carbono das empresas, rastrear o desmatamento global e os níveis de poluição oceânica, além de melhorar a eficiência de sistemas de reciclagem, tratamento de água e gerenciamento de resíduos.

Outras tendências e desenvolvimentos prováveis

Algumas das prováveis tendências futuras, recursos e aplicações para a IA incluem:

- Large language model (LLM) security para proteger os LLMs contra ataques maliciosos, uso indevido em geral, acessos não autorizados e outras ameaças cibernéticas. Isso inclui medidas para proteger os dados dos LLMs, modelos e seus sistemas e componentes associados.

- IA personalizada e centrada no usuário para oferecer um atendimento mais customizado, inteligente e personalizado ao cliente, incluindo marketing por e-mail e segurança de Endpoint.

- Uso de modelos de IA para facilitar testes com red teaming e exercícios com digital twins ao simular ataques aos sistemas de TI de uma organização, a fim de testar vulnerabilidades e mitigar eventuais falhas ou fraquezas.

Onde posso obter ajuda com IA e Cibersegurança?

O Trend Vision One™ oferece proteção incomparável de ponta a ponta para toda a pilha de IA em uma única plataforma unificada com tecnologia de IA.

Aproveitando os recursos completos do Trend Cybertron — a primeira IA proativa de Cibersegurança do mundo — o Trend Vision One inclui um conjunto de recursos de IA agêntica que evoluem continuamente com base em inteligência do mundo real e operações de segurança.

Isso permite que ele se adapte rapidamente a ameaças emergentes para aprimorar a postura de segurança de uma organização, melhorar a eficiência operacional, transformar operações de segurança de reativas para proativas e proteger todas as camadas da infraestrutura de IA.

Fernando Cardoso é o Vice-Presidente de Gerenciamento de Produto na Trend Micro, com foco no mundo em constante evolução de IA e cloud. Sua carreira começou como Network and Sales Engineer, onde aprimorou suas habilidades em datacenters, cloud, DevOps e Cibersegurança — áreas que continuam sendo sua paixão.

Perguntas Frequentes (FAQs)

O que é uma IA?

Inteligência artificial (ou “IA”) é um computador que usa tecnologia para imitar a forma como os seres humanos pensam, funcionam e tomam decisões.

O que a IA realmente faz?

Modelos de IA usam algoritmos complexos e se baseiam em grandes quantidades de informações "aprendidas" para responder perguntas ou gerar conteúdo com base em comandos do usuário.

A Siri é uma IA?

Siri é uma forma simples de IA que usa tecnologias como machine learning e reconhecimento de fala para entender e responder à fala humana.

A IA é boa ou má?

Como todas as tecnologias, a IA não é inerentemente boa ou má. É uma ferramenta que pode ser usada tanto para fins positivos quanto negativos.

Qual é o principal objetivo da IA?

O principal objetivo da IA é permitir que os computadores tomem decisões mais inteligentes, realizem tarefas mais difíceis e aprendam com a experiência sem intervenção humana constante.

Por que a IA foi criada?

A IA foi desenvolvida para ajudar a automatizar tarefas repetitivas, resolver problemas complexos e possibilitar pesquisa e inovação mais avançadas em diversas indústrias.

Quais são os riscos da IA?

Alguns riscos apresentados pela IA incluem preocupações sobre viés e justiça, riscos à privacidade, riscos de cibersegurança e o potencial de substituição de empregos.

Quem criou a IA?

Os cientistas da computação Alan Turing (1912 – 1954) e John McCarthy (1927 – 2011) são geralmente considerados os “pais” não oficiais da IA.

O que é IA na vida real?

Há muitos exemplos de IA em nossas vidas diárias, desde softwares em smartphones no bolso até chatbots que respondem a perguntas comuns de atendimento ao cliente.

O que é uma IA simples?

Alguns exemplos de IAs simples incluem assistentes de voz como a Siri ou Alexa, mecanismos de busca inteligentes como o Google, chatbots de atendimento ao cliente e até aspiradores robóticos.

Quais são as desvantagens da IA?

Algumas desvantagens da IA incluem preocupações com privacidade e viés, riscos de cibersegurança e o impacto potencial em empregos em certas áreas.

Quais são 5 desvantagens da IA?

Dependendo de como é usada, a IA pode causar perda de empregos, gerar desinformação, comprometer informações privadas, reduzir a criatividade e levar à dependência excessiva da tecnologia.

Como eu ativo a IA?

A maioria das ferramentas de IA pode ser ativada ou desativada nas configurações de celulares, computadores, aplicativos de software ou sites.

Posso usar IA gratuitamente?

Muitas ferramentas de IA, como mecanismos de busca ou a Alexa, são completamente gratuitas. Outras, como o ChatGPT, oferecem opções gratuitas e pagas. A IA de nível comercial geralmente é paga.

Qual IA é totalmente gratuita?

A maioria das empresas de IA oferece versões introdutórias gratuitas, incluindo Microsoft Copilot, Grammarly, Google Gemini e ChatGPT.

Qual é o aplicativo de IA mais popular neste momento?

Atualmente, os aplicativos de IA mais populares incluem ChatGPT, Google Maps, Google Assistente, Microsoft Copilot e Google Gemini.

Qual é o aplicativo de escrita com IA que todos estão usando?

Alguns dos aplicativos assistidos por IA mais populares são Grammarly, ChatGPT, Writesonic, Jasper e Claude.

Qual é o aplicativo de IA que todos estão usando gratuitamente?

Google Gemini, Copilot da Microsoft e ChatGPT estão entre os aplicativos gratuitos de IA mais amplamente usados atualmente.

Qual é o melhor chatbot de IA agora?

O “melhor” chatbot depende do que você precisa, mas alguns dos chatbots de IA mais populares incluem Perplexity, Google Gemini, Jasper e ChatGPT.

Qual é um exemplo de IA na vida cotidiana?

Exemplos comuns de IA na vida cotidiana incluem smartphones, mecanismos de busca com IA, chatbots de atendimento ao cliente e assistentes de voz digitais como a Siri e a Alexa.

Artigos Relacionados

As 10 Principais Ameaças & Mitigações para LLMs e Aplicativos GenAI em 2025

Gerenciando riscos emergentes à segurança pública

Até Onde os Padrões Internacionais Podem Nos Levar?

Como escrever uma política de Cibersegurança para IA generativa

Ataques maliciosos aprimorados por IA entre os principais riscos

Ameaça crescente de identidades deepfake