網路犯罪

不受控制的 AI:資安界忽略了什麼?

本文是有關「不受控制的 AI」(Rogue AI) 議題一系列文章的第四篇,請持續鎖定來取得更多技術指引、個案研究以及分析洞見。

先前在這一系列中,我們深入探討了何謂不受控制的 AI,以及我們如何發現不受控制的 AI。在上一篇文章,我們也討論了一些可能的防範措施。我們的目的是希望能夠拋磚引玉來促進有關網路資安未來威脅的辯論,並找出最有效的方法盡可能降低這些威脅對個人、企業和社會的風險。

本篇將探討目前業界在 AI 風險評估方面所做的努力。雖然目前已經有一些不錯的研究成果,但人們卻仍忽略了應該將因果關係與攻擊情境連結。

有誰在做些什麼?

在資安界,不同領域對不受控制的 AI 有不同的觀點:

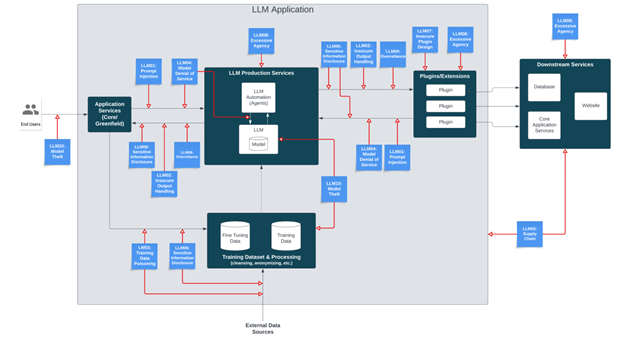

- OWASP 聚焦在漏洞與防範,發表了 LLM 應用程式 10 大漏洞 (Top 10 for LLM Applications) 報告,並在 LLM AI 網路資安與治理檢核表 (LLM AI Cybersecurity and Governance Checklist) 中提供了一些高階指引。

- MITRE 專門研究駭客的攻擊手法與技巧,藉由 ATLAS 矩陣將 MITRE ATT&CK 框架延伸至 AI 系統。

- MIT 最新發表的 AI 風險資料庫 (AI Risk Repository) 提供了一個包含 700 多種 AI 風險的線上資料庫,並依據原因和風險領域來分類。

以下讓我們逐一檢視。

OWASP

不受控制的 AI 和 OWASP 提出的 10 大 LLM 風險幾乎每一項都有關,除了「第 10 項:竊取模型」(LLM10:Model Theft) 之外,也就是「在未經授權的情況下存取、複製或外傳專屬 LLM 模型」。此外,「脫離正軌」的行為也不算是漏洞,也就是當 AI 遭到入侵或出現意外行為的情況。

脫離正軌:

- 可能的原因包括:提示注入、模型下毒、供應鏈、不安全的輸出,或是不安全的擴充元件。

- 如果在 10 大漏洞的「第 9 項:過度依賴」(LLM09:Overreliance) 的情況下,可能會有更大的影響。

- 可能導致「阻斷服務」(Denial of Service,LLM04)、「敏感資訊外洩」(Sensitive Information Disclosure,LLM06) 和/或「過多的代理權限」(Excessive Agency,LLM08)。

其中,「過多的代理權限」尤其危險,這是指 LLM「採取了一些行動而導致意外的後果」,並擁有過多的功能、權限或自主性。這一點可以透過確保系統與功能的適當存取,並透過「人機循環」(human-in-the-loop) 來加以防範。

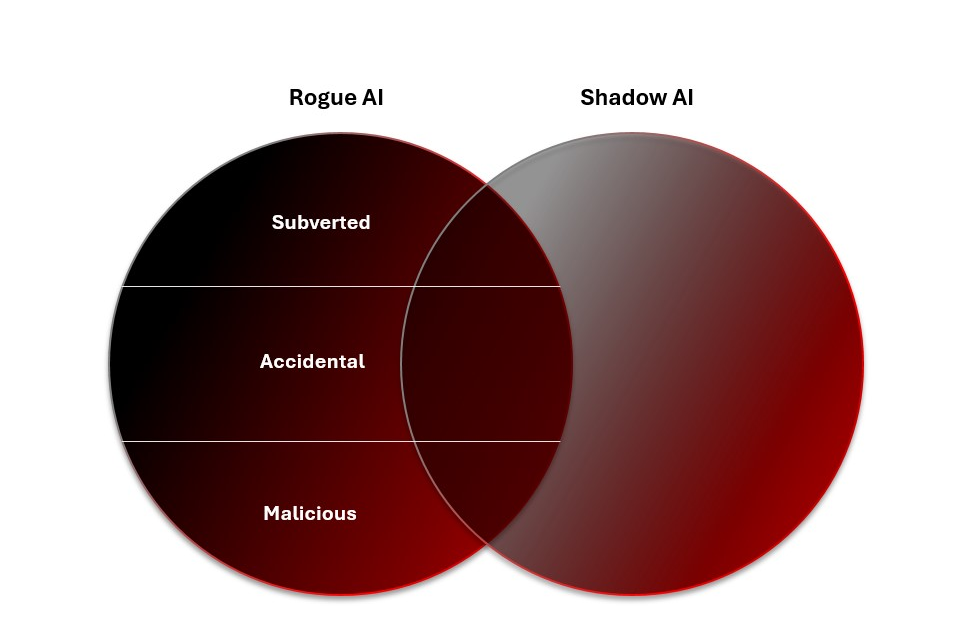

OWASP 的 10 大漏洞在防範不受控制的 AI 上提出了不錯的建議 (後面會再提到),但卻沒有顧慮到因果關係:也就是攻擊是否蓄意。他們的資安與治理檢核表也提供了一份方便的行動清單,確保 LLM 在各種風險情境下都能安全導入。它將「影子 AI」(Shadow AI) 列為許多企業機構最迫切的非駭客 LLM 威脅。然而壞蛋總是躲在暗處偷偷壯大,所以,缺乏治理的 AI 已經超出了政策所允許的 AI 用途。 假使無法掌握影子 AI 系統的可視性,那就無法知道他們是否已經變壞。

MITRE ATLAS

MITRE 的手法、技巧與程序 (TTP) 框架是任何網路威脅情報人員的首要參考資源,有助於將許多攻擊程序中的步驟分析標準化,讓研究人員更容易發現某些攻擊行動。儘管 ATLAS 將 ATT&CK 框架延伸至 AI 系統,但它無法直接解決不受控制的 AI 的問題。不過,「提示注入」、「越獄」和「模型下毒」等可用來破壞 AI 系統進而產生不受控制的 AI 的手法都已經列入了 ATLAS TTP 當中。

事實上,這些遭到破壞的 AI 系統本身就是 TTP:代理式 AI 系統可執行任何 ATT&CK 手法與技巧 (如偵查、資源開發、突破防線、存取機器學習模型、執行) 來造成破壞。所幸,目前只有高明的駭客才有辦法破解 AI 系統來達成其特定目的。不過,光知道他們已經在試圖進入這類系統,就足以令人擔心。

儘管 MITRE ATLAS 和 ATT&CK 已經涵蓋了遭人破壞的 AI,但卻還未涵蓋天生惡意 AI。目前並無駭客在目標環境安裝惡意 AI 系統的例子,儘管這只是時間早晚的問題:隨著企業開始採用代理式 AI,駭客也會開始這麼做。以這樣的方式將 AI 用於攻擊,本身就是一種技巧。從遠端部署 AI,就好像把 AI 當成惡意程式一樣,不過當然不只是這樣。而使用內含 AI 服務的代理機器人來發動攻擊,就如同使用 AI 殭屍網路一樣,但同樣也不只這樣。

MIT AI 風險資料庫

最後,還有 MIT 的風險資料庫,這是一個內含數百種 AI 風險的線上資料庫,還有一份詳細介紹該主題最新文獻的主題地圖。該資料庫廣泛收錄了業界對 AI 風險的各種觀點,可說是一項非常珍貴的資源,其收錄的風險有助於更全面的分析。很重要的是,它談到了因果關係的議題,包含三個主要層面:

- 誰是問題發生的原因 (人/AI/不明)

- 如何發生在 AI 系統中 (意外或蓄意)

- 何時發生 (之前、之後、不明)

「意圖」對於了解不受控制的 AI 尤其重要,儘管它只有在 OWASP 資安與治理檢核表的中提到。意外的風險通常來自於某項弱點,而非 MITRE ATLAS 攻擊技巧或 OWASP 漏洞。

此外,「風險是誰所造成」也有助於分析不受控制的 AI 的威脅。人類和 AI 系統都可能不小心導致不受控制的 AI 的產生,但天生惡意的 AI 則原本就是設計用來攻擊。天生惡意的 AI 理論上也可能試圖破壞現有的 AI 系統來使它變壞,或者設計用來製造自己的「後代」,儘管我們目前認為人類才是蓄意不受控制的 AI 的元凶。

了解風險的發生時機,是任何威脅研究人員的基本條件,他們應該對 AI 系統生命週期所有環節的狀況都瞭若指掌。換句話說,在部署前和部署後,都要對系統進行評估並檢查是否有脫離正軌的現象,以便揪出天生惡意、遭人破壞或意外變壞的 AI。

MIT 將風險分成 7 個關鍵群組和 23 個子群組,其中不受控制的 AI 直接歸類在「AI 系統安全、故障與限制」(System Safety, Failures and Limitations) 領域。其定義如下:

「與道德標準或人類的目標或價值觀 (尤其是設計者或使用者的目標) 相衝突的 AI 系統。這些衝突的行為有可能是人類在設計與開發過程中所造成,例如:獎勵駭客 (reward hacking) 與目標不當泛化 (goal mis-generalization) ,可能導致 AI 運用一些危險的能力 (如操弄、欺騙或當下狀況) 來追求力量、自我擴散,或達成其他目的。」

透過因果關係與風險情境來達成縱深防禦

基本上,採用 AI 系統會增加企業的攻擊面,而且可能是大幅度增加。企業必須更新其風險模型來將不受控制的 AI 的威脅列入考量。此時「意圖」將會是關鍵:意外變壞的 AI 在很多情況下都會造成傷害,而且不牽涉到駭客。但如果傷害是蓄意的,那麼誰正在使用什麼資源來攻擊誰,就是非常需要了解的情況。到底是駭客、還是天生惡意的 AI 正在攻擊您的 AI 系統來讓它變壞? 他們是否正在攻擊您的整個企業? 還有,他們使用的是您的資源、他們自己的資源,或是某個已遭破壞的 AI 代理。

這些全部都是企業所面臨的風險,不論部署前或部署後。儘管資安界已經有些不錯的研究來改善這類威脅的分析,但在不受控制的 AI 方面所缺乏的,是一套同時將因果關係與攻擊情境納入考量的方法。只要解決了這點,我們就能開始做好萬全準備,並徹底防範不受控制的 AI 的風險。