Cyberbedrohungen

Künftiges Social Engineering nutzt KI

Social Engineering bei Angriffen wird sich durch den Einsatz von KI und Bots erheblich verändern – gerade im Bereich des Fake Narrativs. Und auch neue Medien wie VR-Geräte oder Wearables weiten die Attacken aus. Wie sieht diese „Zukunftsmusik“ aus?

Ideen von Robert McArdle, Marco Balduzzi, Vincenzo Ciancaglini, Vladimir Kropotov, Fyodor Yarochkin , Rainer Vosseler, Ryan Flores, David Sancho, Fernando Mercês, Philippe Z Lin, Mayra Rosario, Feike Hacquebord, Roel Reyes

„Social Engineering“ bezeichnet eine Taktik von Cyberkriminellen, bei der ein Nutzer durch ein falsches Narrativ belogen wird, wobei die Gutgläubigkeit, Gier, Neugier oder andere sehr menschliche Eigenschaften des Opfers ausgenutzt werden. Das Ergebnis ist, dass das Opfer dem Angreifer bereitwillig private Informationen preisgibt - ob persönliche (z. B. Name, E-Mail), finanzielle (z. B. Kreditkartennummer, Krypto-Wallet) - oder dass es zur versehentlichen Installation von Malware/Backdoors auf seinem eigenen System kommt.

Moderne Angriffe lassen sich je nach Ziel in zwei breite Kategorien einteilen: Die Täter greifen entweder die Maschine oder den Benutzer an. Erstere Attacken gehen vor allem über die Ausnutzung von Schwachstellen, der „Angriff auf den Menschen“ (Social Engineering) ist aber nach wie vor weitaus häufiger. Alle bekannten, nicht auf Schwachstellen basierenden Angriffe beinhalten ein Social-Engineering-Element, bei dem der Angreifer versucht, das Opfer zu etwas zu überreden, das sich letztendlich nachteilig für das Opfer auswirkt.

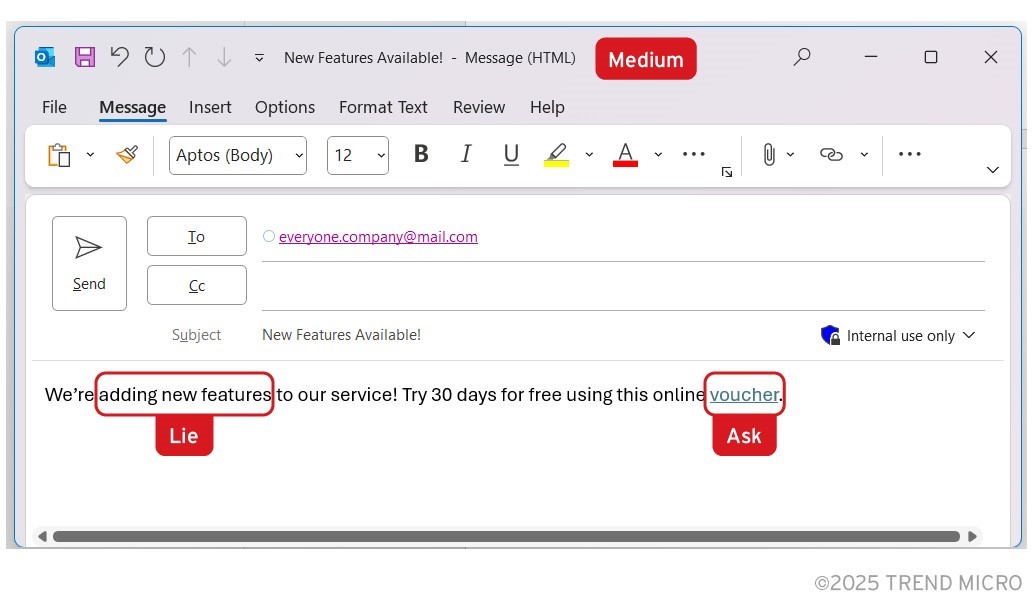

Jede Social Engineering-Interaktion lässt sich auf die folgenden Elemente herunterbrechen:

- Ein „Medium“, um eine Verbindung zum Opfer herzustellen, z. B. per Telefon, E-Mail, sozialem Netzwerk oder Direktnachricht.

- Eine „Lüge“, bei der der Angreifer eine Falschaussage aufbaut, um das Opfer zu überzeugen, innerhalb einer bestimmten Zeit zu handeln. Die Lüge hat oft auch eine eingebaute Dringlichkeit, wie z. B. eine zeitliche Begrenzung.

- Eine „Bitte“, d. h. die vom Opfer zu ergreifende Maßnahme, wie z. B. die Angabe von Anmeldedaten, die Ausführung einer schädlichen Datei, die Investition in ein bestimmtes Kryptosystem oder das Senden von Geld.

Bild 1. Das Medium, die Lüge und die Bitte in einem Social Engineering-Angriff

Im Laufe der Jahre gab es eine Vielzahl unterschiedlicher Plots im Bereich Social Engineering, und man könnte meinen, dass alle Ideen bereits verwendet wurden. Dennoch lassen sich Angreifer jedes Jahr neue Social-Engineering-Tricks einfallen.

Änderungen im Medium

Mit dem Aufkommen neuer Technologien erhalten Angreifer mehr Möglichkeiten, ihre potenziellen Opfer zu erreichen: KI-Tools, VR-Geräte wie Apple Vision Pro, der Humane-Anstecker, Ray-Ban-Brillen oder jedes neue Gerät, das Benutzer in Zukunft möglicherweise verwenden.

Wearables als Medium: Wearables sind besonders interessant, weil sie immer eingeschaltet sind und das volle Vertrauen ihrer Benutzer genießen. Jeder Schwindel, bei dem ein Wearable zum Einsatz kommt, hat eine höhere Chance, als vertrauenswürdig eingestuft zu werden, und somit dem Angreifer Zugriff auf das Device zu geben. Sie sind oft nicht dafür ausgelegt, Sicherheitstools einzusetzen oder sich regelmäßig zu authentifizieren, wodurch sie häufig normale Sicherheitskontrollen umgehen.

Unter Umständen gelingt dem Angreifer auch ein Zugriff auf das Konto des Benutzers und dessen Dashboard. So wird es möglich, die Daten zu nutzen, um den Benutzer weiter zu täuschen. Im Falle eines Fitnessgeräts kann der Angreifer etwa eine E-Mail an den Benutzer senden, in der er ihm mitteilt: „Ihre Schrittzahl war diese Woche ungewöhnlich niedrig; klicken Sie hier, um auf Ihr Dashboard zuzugreifen.“ Oder: „Die Firmware Ihres Geräts ist veraltet. Klicken Sie hier, um sie zu aktualisieren.“ Bei komplexeren Geräten besteht die Möglichkeit, die Kontrolle über das Gerät zu übernehmen und es für Denial-of-Service-Angriffe gegen andere oder für weitere böswillige Aktionen zu verwenden, je nach den Fähigkeiten des Geräts.

Chatbots als Medium: Die Idee dahinter ist, dem Chatbot falsche Informationen zuzuführen, um den Benutzer zum Handeln zu verleiten. Die Daten des Chatbots können z. B. durch die Eingabe falscher Informationen, das Entwenden von Trainingsdaten oder das Einfügen neuer Befehle manipuliert werden.

Werden intelligente Assistenten oder Wissensdatenbanken einbezohrn, könnte dies einen Zugriff auf den Computer des Opfers erfordern. Der wahrscheinlichste Anwendungsfall wäre im Rahmen eines Business Email Compromise (BEC)-Schemas, bei dem das Opfer über ein anderes Medium angewiesen wird, das Geld zu überweisen, und dann einen Chatbot als Verifizierungsinstrument verwendet. Die Verifizierung wäre erfolgreich, da die Daten verfälscht sind. Doch Achtung, diese Strategie ist nur bei privaten Chatbot-Installationen erfolgreich, bei denen die Trainingsdaten dynamisch sind (d. h. auf einem Repository basieren, das geändert werden kann) oder bei denen die Trainingsdaten über das Netzwerk zugänglich sind. Diese Methode wäre bei kommerziellen Chatbots wie OpenAI ChatGPT oder Anthropic Claude nicht anwendbar.

Als Verfeinerung der Attacke könnte ein digitaler Assistent durch Social Engineering dazu gebracht werden, im Namen des Benutzers böswillige Aktionen auszuführen, etwa eine Umfrage auszufüllen und so die persönlichen Daten preiszugeben oder einen bösartigen QR-Code anzeigen, den der Benutzer mit einem Mobiltelefon scannen kann. Ein noch futuristischeres Szenario wäre, dass ein digitaler Assistent den digitalen Assistenten des Ziels durch Social Engineering manipuliert.

Neue Mail-basierte Angriffe: Bei diesen Angriffen verwendeten Täter einen Bot, der von einem Large Language Model (LLM) angetrieben wird, um die Effektivität eines BEC-Angriffs zu erhöhen. Der LLM-Bot dient dazu, den gesamten bisherigen Nachrichtenverlauf zwischen dem Opfer und dem CEO zusammenzustellen. Anschließend kann er einen Thread in diesem vertrauenswürdigen Kanal fortsetzen, als wäre es der CEO, der den Schreibstil des CEO verwendet, um das Opfer davon zu überzeugen, das Geld zu überweisen. Manuell geschieht dies bereits, aber das Potenzial für eine Automatisierung dieses Angriffs mit KI ist nicht zu unterschätzen.

Virtuelle Realität (VR) und erweiterte Realität (AR): In VR/AR-Umgebungen kann der Angreifer die URL so gestalten, dass sie für bestimmte Personengruppen schädlich ist, vorausgesetzt, Objekte oder Avatar-Skins werden durch eine URL dargestellt – ähnlich wie bei Non Fungible Tokens (NFTs). Wenn das Item betrachtet oder mit ihm interagiert wird (z. B. eine Schachtel geöffnet oder ein Hut aufgesetzt wird), könnte die URL schädliche Aktionen ausführen. Noch heimtückischer ist, dass die URL nach IP oder anderen Bedingungen unterschiedlich agieren kann, z. B. nur Benutzer aus Deutschland betreffen. Ebenso öffnet die Verwendung von QR-Codes in diesen AR-Umgebungen Angreifern Tür und Tor, um schädliche URLs zu verbreiten, wenn diese automatisch gelesen werden. Beispielsweise könnte ein niedlicher Drache, der auf einem QR-Code steht, Benutzer dazu veranlassen, ihn zu scannen, was böswillige Aktivitäten auslöst.

Mehr und bessere QR-Code-Angriffe: QR-Code-Angriffe sind auch außerhalb der VR ein gutes Beispiel. Die Kill Chain wird zwischen den Geräten aufgeteilt und kaum korreliert. In der physischen Welt könnte dies ein Aufkleber mit einem bösartigen QR sein, der über dem ursprünglichen, legitimen QR angebracht ist. Im digitalen Bereich fügen Angreifer bösartige QR-Codes in E-Mails oder Webseiten ein.

Phishing-E-Mails mit bösartigen QR-Codes sind bereits bekannt, aber die Möglichkeiten sind noch vielfältiger. Wenn der Angreifer E-Mails während der Übertragung oder auf dem Server ändern kann, ließe sich der schädliche QR-Code zu einer legitimen E-Mail oder Webseite hinzufügen, so dass legitime ersetzt oder von Grund auf neue hinzukommen.

Verbesserung der Lügen

Die wichtigste Innovation, die Social Engineering-Lügen weiterentwickelt, ist KI. Die tatsächliche Lüge in einer Social Engineering-Story variiert je nach Jahreszeit, Land oder demografischer Gruppe. Doch dies kann sich aufgrund der Skalierbarkeit und Flexibilität, die KI bietet, sehr schnell ändern. Denn generative KI brilliert bei der Generierung von Bildern, Audios und Videos. Bei Texten zeichnet sie sich durch die Erstellung glaubwürdiger Inhalte und die schnelle Verarbeitung großer Textmengen aus. Diese neue Skalierbarkeit eröffnet viele neue Entwicklungen für den „Lügen“-Aspekt des Social Engineering.

Angreifer können nun für die Erstellung von Lügen die KI-Technologie selbst einsetzen. Zum Beispiel können Lügen über ChatGPT oder über VR sehr effektiv sein, weil das Interesse daran so groß ist. Außerdem lassen sich gefälschte KI-Tools erstellen, die in Wirklichkeit Malware sind. Schließlich erweist sich die Einbindung von Fake-Bildern und Videos in bestehende erfolgreiche Betrugsversuche gut für deren Glaubwürdigkeit. Diese Strategie ist in der aktuellen Bedrohungslandschaft eindeutig auf dem Vormarsch. Wir sind davon überzeugt, dass Deepfakes das Potenzial haben, bei Social Engineering-Betrugsschemata eine große Rolle zu spielen.

Eine weitere reale Möglichkeit stellt ein KI-basiertes dynamisches Lügensystem dar. Es würde automatisch mit dem Benutzer in Kontakt treten und mit ihm interagieren, um vor der „Bitte“ sein Vertrauen zu gewinnen.

Eine weitere künftige Entwicklung wäre die „vorhersehbare Lüge“. Dies ist eine Möglichkeit, die zu spammende Mail-Datenbank in Teile zu unterteilen. Jedem dieser Teile würden leicht unterschiedliche Lügen erzählt, mit dem Ziel, dass ein Teil der anvisierten Nutzer zunehmend der Lüge vertraut, die am besten zu sein scheint. Behauptet etwa ein Betrüger, das Ergebnis eines Ereignisses vorhersagen zu können, erhält die Hälfte der Datenbank ein Ja, die andere Hälfte ein Nein. Die Hälfte mit der richtigen Vorhersage, kann dann eine neue Ja/Nein-Vorhersage für das nächste Ereignis erhalten. Diejenigen, die zwei korrekte Vorhersagen hintereinander erhalten haben, würden viel eher geneigt sein, der Aufforderung zu vertrauen. Dies kann bei Themen im Zusammenhang mit Wetten, Aktienmärkten und Investitionen in Kryptowährung verwendet werden.

Um Lügen in einem Betrug zu verbessern, lassen sich Gruppen von Personen ansprechen, für diese spezifische Lügen erstellen, und so Social-Engineering-Angriffe auf potenzielle Opfer zuschneiden. Angreifer könnten über einen Katalog von KI-Chatbot-Anweisungen verfügen, die so konzipiert sind, dass sie hocheffektive Social-Engineering-Nachrichten für jeden Zieltyp mit einem bestimmten Hauptthema, z. B. Plagiat, erstellen.

Angreifer könnten auch externe Informationen sammeln, um die Daten anzureichern und die Opfer mit äußerst glaubwürdigen Lügen anzusprechen. Dies ähnelt dem früheren Szenario, aber die Anreicherung würde durch die Online-Suche nach weiteren Informationen über jede Zielperson erfolgen. Auch dies kann durch einen KI-Agenten automatisiert werden. Die von der KI generierten E-Mails würden diese Infos verwenden, um personalisierte Nachrichten zu verfassen.

Fazit

Gegenwärtig gibt es für Angreifer viel Spielraum, um bestehende Social-Engineering-Methoden zu verbessern und neue Tricks zu entwickeln, da wir immer mehr Optionen für Konnektivität und Technologien erhalten.

Themen, die Angreifer für Social Engineering verwenden, verändern sich, und KI lässt sich als solche einbeziehen, um Social Engineering zu automatisieren und skalierbarer zu machen. Weitere Verfeinerungen von Social-Engineering-Tricks sind beim derzeitigen Stand von GenAI sicherlich möglich.

Die meisten Innovationen für das Social Engineering werden wohl das „Medium“ und die „Lüge“ betreffen. Die Angreifer suchen immer neue Wege, um potenzielle Opfer zu erreichen. Auch verbessern sie die Lügen, das heißt sie perfektionieren die Geschichten, mit denen sie Opfer täuschen wollen. Die „Bitte“ wird sich wahrscheinlich am wenigsten ändern, da die Ziele der Angreifer im Allgemeinen gleich bleiben.

Unternehmen sollten proaktive Maßnahmen ergreifen, um den neuen Taktiken und Techniken der Cyberkriminellen einen Schritt voraus zu sein. Eine umfassende Sicherheitsstrategie ist notwendig, um sensible Informationen und Vermögenswerte zu schützen, die von diesen Social-Engineering-Betrügereien betroffen sein könnten.