Cyberbedrohungen

Auswirkungen der Risiken bösartiger KI mindern

Es gibt unterschiedliche Möglichkeiten, das Risiko und die Auswirkungen einer Rogue AI zu vermindern und Abhilfe für LLM-Schwachstellen zu schaffen. Als Ergänzung dazu eignet sich der Zero Trust-Ansatz und eine Layer übergreifende Verteidigung.

Unternehmen müssen sich aktiv um das Risiko durch KI-Angriffsfläche kümmern und es besser verwalten. So gibt es Möglichkeiten, Bedrohungen durch die Schaffung vertrauenswürdiger KI-Identitäten zu mindern. Auch Organisationen wie OWASP oder das MIT haben Anleitungen zur Erfassung von KI-Risiken sowie die effektive Abhilfemaßnahmen für LLM-Schwachstellen vorgeschlagen. Wir wollen nun die fehlenden Teile des Puzzles ergänzen, nämlich wie Zero Trust und mehrschichtige Verteidigungsmaßnahmen vor Rogue AI-Bedrohungen schützen können.

Ursächliche Faktoren für Rogue KI

LLM-Schwachstelle / Typ des Rogue |

Versehentlich |

Unterwandert |

Bösartig |

Exzessive Funktionalität |

Fehlkonfiguration von Fähigkeiten |

Geänderte oder direkt hinzugefügte Funktionen oder Umgehung von Schutz am Edgen |

Für bösartige Ziele erforderliche Funktionalität |

Exzessive Berechtigungen |

Fehlkonfiguration der Berechtigung |

Eskalierte Privilegien |

Muss alle Privilegien erwerben; zu Beginn keine |

Exzessive Autonomie |

Fehlkonfiguration von Aufgaben, die eine menschliche Überprüfung erfordern |

Mensch aus der Aufgabenschleife entfernt |

Nicht unter Kontrolle des Verteidigers |

Die oben genannten Ursachenfaktoren können dazu dienen, das mit Rogue AI Services verbundene Risiko zu identifizieren und zu mindern. Der erste Schritt besteht darin, die relevanten KI-Dienste ordnungsgemäß zu konfigurieren und mit die Festlegung zulässiger Verhaltensweisen eine Grundlage für die Sicherheit gegen alle Arten von Rogue AI schaffen. Der Schutz und das Sauberhalten der Punkte, an denen bekannte KI-Dienste Daten berühren oder Tools verwenden, verhindert in erster Linie unterwanderte Rogues. Als Kern der sicheren Nutzung gilt die Beschränkung von KI-Systemen auf die erlaubte Anwendung von Daten und Werkzeugen sowie die Überprüfung des Inhalts von Eingaben in und Ausgaben der KI-Systeme.

Bösartige Rogue AI kann Unternehmen von außen angreifen oder als KI-Malware innerhalb einer Umgebung agieren. Viele Muster, die zur Erkennung bösartiger Aktivitäten von Cyberangreifern taugen, können auch zur Erkennung der Aktivitäten bösartiger Rogues verwendet werden. Da jedoch neue Fähigkeiten die Umgehungsmöglichkeiten der Rogues verbessern, wird das Erlernen von Erkennungsmustern die nicht bekannten Unbekannten nicht abdecken. Hier muss maschinelles Verhalten auf den Geräten, in Workloads und in der Netzwerkaktivität identifiziert werden. In einigen Fällen ist dies die einzige Möglichkeit, bösartige Rogues zu erkennen.

Die Verhaltensanalyse kann auch andere Fälle von exzessiverFunktionalität, Berechtigungen oder Autonomie aufdecken. Anomale Aktivitäten auf Geräten, in Workloads und im Netzwerk können ein wichtiger Indikator für bösartige KI-Aktivitäten sein, unabhängig davon, wie sie verursacht wurden.

Umfassender Schutz über den OSI-Kommunikations-Stack

Für einen umfassenderen Ansatz bedarf es jedoch auf jeder Schicht des OSI-Modells einer umfassende Verteidigung in Betracht ziehen, und zwar wie folgt:

Physisch: Überwachen der Prozessornutzung (CPU, GPU, TPU, NPU, DPU) in Cloud-, Endpunkt- und Edge-Geräten. Dies gilt für KI-spezifische Workload-Muster, die Abfrage von KI-Modellen (Inferenz) und das Laden von Modellparametern in den Speicher in der Nähe der KI-spezifischen Verarbeitung.

Datenebene: Verwenden von MLOps/LLMOps-Versionierung und -Überprüfung, um sicherzustellen, dass Modelle nicht vergiftet oder ersetzt werden, Aufzeichnen von Hashes zur Identifizierung von Modellen. Verwendung von Software- und KI-Bills of Materials (SBoMs/MBoMs), um sicherzustellen, dass man der KI-Service-Software und dem Modell vertrauen kann.

Netzwerk: Begrenzen der KI-Dienste, die von außen zu erreichen sind, sowie der Tools und APIs, die KI-Dienste erreichen können. Erkennen nicht üblicher Kommunikatoren wie Mensch-Maschine-Übergänge und neuartige Maschinenaktivitäten.

Transport: Hier hilft etwa eine Begrenzung der Raten für externe KI-Dienste und Scannen nach nicht normalen Paketen.

Sitzung: Einfügen von Verifizierungsprozesse wie Human-in-the-Loop-Prüfungen, insbesondere bei der Instanziierung von KI-Diensten. Verwenden Sie Timeouts, um Session Hijacking zu entschärfen. Analysieren Sie die Authentifizierungen im Benutzerkontext und erkennen Sie anomale Sitzungen.

Applikations- und Präsentationsschicht: Identifizieren von Fehlkonfigurationen von Funktionalität, Berechtigungen und Autonomie (wie in der Tabelle oben), Verwenden von Schutzmaßnahmen für KI-Eingaben und -Ausgaben, z. B. Bereinigung von persönlichen (PII) und anderen sensiblen Informationen und Prompt-Injektionen oder System-Jailbreaks. Beschränkung der LLM-Agententools anhand einer Zulassungsliste, die APIs und Plugins einschränkt und nur die Nutzung wohlbekannter Websites erlaubt.

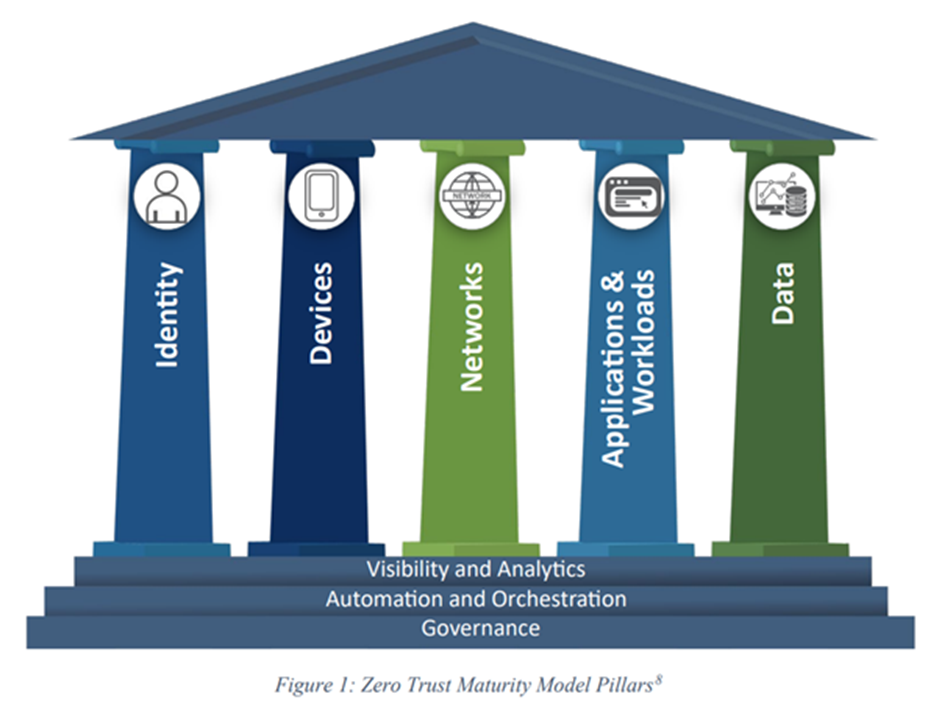

Das Zero Trust Maturity Model

Die Zero-Trust-Sicherheitsarchitektur hält viele Werkzeuge zur Minderung des Rogue AI-Risikos bereit. Entwickelt wurde es von der US Cybersecurity and Infrastructure Security Agency (CISA), um Bundesbehörden bei der Einhaltung der Executive Order (EO) 14028 (Improving the Nation's Cybersecurity) zu unterstützen. Es spiegelt die sieben Grundsätze von Zero Trust wider, wie sie in NIST SP 800-207 dargelegt sind:

- Alle Datenquellen und Computing Services werden als Ressourcen betrachtet.

- Die gesamte Kommunikation ist unabhängig vom Standort des Netzes gesichert.

- Der Zugriff auf einzelne Unternehmensressourcen wird pro Sitzung gewährt.

- Der Zugang zu den Ressourcen wird durch eine dynamische Policy bestimmt.

- Das Unternehmen überwacht und misst die Integrität und die Sicherheitslage aller eigenen und zugehörigen Vermögenswerte.

- Alle Ressourcenauthentifizierungen und -autorisierungen sind dynamisch und werden streng erzwungen, bevor der Zugriff erlaubt wird.

- Das Unternehmen sammelt so viele Informationen wie möglich über den aktuellen Zustand der Anlagen, der Netzwerkinfrastruktur und der Kommunikation und nutzt diese, um seine Sicherheitslage zu verbessern.

Für eine wirksame Risikominderung in einem Rogue AI-Kontext müssen Unternehmen die im CISA-Dokument beschriebene „fortgeschrittene“ Stufe erreichen:

„Wo immer möglich, automatisierte Kontrollmechanismen für den Lebenszyklus und die Zuweisung von Konfigurationen und Richtlinien mit säulenübergreifender Koordination; zentralisierte Sichtbarkeit und Identitätskontrolle; säulenübergreifende Durchsetzung von Richtlinien; Reaktion auf vordefinierte Abhilfemaßnahmen; Änderungen der geringsten Berechtigung auf der Grundlage von Risiko- und Zustandsbewertungen und Aufbau einer unternehmensweiten Awareness (einschließlich extern gehosteter Ressourcen)."

Die Säulen von Zero Trust entsprechen in etwa den Schichten des OSI-Modells, das einen strukturierteren Ansatz für die Festlegung von Ebenen in einem Kommunikations-Stack bietet. Die Steuerung zulässiger Aktionen für jede Säule ist der grundlegendste Schutz gegen Rogue AI: nur das tun, was ausdrücklich erlaubt ist. Automatisierung und Orchestrierung von Kontrollen, Zugriff, Reputation und Mustererkennung bilden die nächste Verteidigungsstufe. Die Sichtbarkeit über die Säulen des Zero Trust Maturity Model für normales und anormales Verhalten hinweg ermöglicht die Erkennung von unbekannten Unbekannten. Rogue KI kann durch strenge Richtlinien, andere Regeln und die Erkennung von ML-Aktivitäten und schließlich durch die Sichtbarkeit von Aktionen, die nicht normal, nicht beabsichtigt und daher falsch ausgerichtet sind, abgeschwächt werden.

Schichtübergreifender Schutz

Der erste Schritt auf dem langen Weg zur KI-Sicherheit ist die Einhaltung von Richtlinien. Das bedeutet nur zulassen, was angegeben ist, sicherstellen, dass die KI innerhalb einer streng kontrollierten Sandbox autorisiert wird, einschränken der Erstellung neuer Instanziierungen für die Nutzung von KI-Diensten, neuer Arten des Datenzugriffs oder der Nutzung von Tools. Außerdem muss sichergestellt werden, dass die KI über eine eigene Autorisierung verfügt, die sowohl durch die Identität der KI als auch durch die des Benutzers begrenzt ist. Sie muss genau definiert sein, so dass alle Eingaben und Ausgaben genau verstanden werden.

Reputation ist ebenfalls wichtig, denn sie bietet den schnellsten Weg, um bekannte böse oder gute Dinge zu erkennen. Dafür ist ein Tracking der KI-Identität erforderlich. Verschiedene Identitäten haben unterschiedliche Fähigkeiten und einen unterschiedlichen Ruf, abhängig davon, wie wahrscheinlich es ist, dass sie zu Rogues werden.

Die regelbasierte und auf ML-Mustern basierende Erkennung bietet eine weitere Verteidigungsschicht. Die Identifizierung von Dateninhalten verhindert die Offenlegung sensibler Informationen, Prompt Injections und Model Poisoning. Netzwerkbasierte Erkennungen weisen auf KI-Serviceverkehr hin. Einfache Regeln für die Gerätenutzung und Prozesse warnen vor unbeabsichtigter Nutzung.

Zero Trust bedeutet, dass alles, was bekannt ist, verifiziert werden muss, und alles, was unbekannt ist, Misstrauen entgegengebracht wird. Verhaltensanomalien sind in der Sicherheitsbranche seit langem eine Herausforderung und führen häufig zu falsch positiven Ergebnissen. Die Bereitstellung bestätigender Informationen erhöht die Sicherheit bei der Erkennung von Anomalien, sei es durch Reputation, Regeln, Muster oder andere.

Die Erkennung von Anomalien ist die letzte Schutzebene, die die Identifizierung von bisher unbekannten Aktivitäten ermöglicht. Die Einrichtung einer automatischen Überwachung des KI-Verhaltens für jede der fünf Säulen von Zero Trust ist sinnvoll:

- Identität: Menschliche und maschinelle Identität und Verhalten,

- Geräte: Awareness für physische und virtuelle Vermögenswerte,

- Netzwerke: Erlaubte, verbotene und von der Norm abweichende Kommunikation,

- Anwendungen und Workloads: Vertrauenswürdige und nicht vertrauenswürdige API/Rechenleistung.

- Daten: Inhaltsbezogene Schutzmaßnahmen wie Data Loss Prevention, Data Security Posture Management (DSPM) und Data Detection and Response (DDR).

Die oben genannten Punkte dienen als Ergänzung und nicht als Ersatz für die OWASP-Schutzmaßnahmen. Mit einem rigorosen, systematischen Ansatz zur Risikominderung auf allen OSI-Ebenen und Zero-Trust-Säulen können Unternehmen ihre KI-Programme mit der Gewissheit aufbauen, dass die von verwendete KI mit den Zielen des Anwenders übereinstimmt.