Cyberbedrohungen

Vertrauen in GenAI: Der Zero Trust-Ansatz

Unternehmen setzen voll auf GenAI, aber je mehr sie sich auf KI-Modelle verlassen, desto mehr Risiken sind sie ausgesetzt. Um höhere Sicherheit für ihre Daten zu gewährleisten empfiehlt sich die Umsetzung eines Zero Trust-Ansatzes.

Beim Einsatz generativer KI-Lösungen (GenAI) stehen Unternehmen vor vier zentralen Sicherheitsherausforderungen. Sie müssen sicherstellen, dass die Art und Weise, wie KI eingesetzt wird, den Compliance-Anforderungen entspricht, dass sensible Daten nicht versehentlich offengelegt werden und dass KI-Modelle selbst nicht dazu verwendet werden, dem Unternehmen zu schaden. Und sie müssen Netzwerk- und Sicherheitsteams Einblick in KI-Plattformen gewähren, um die Nutzung effektiv zu verwalten.

Nach der anfänglichen Einführung generativer KI (GenAI) stellen Unternehmen jetzt tiefer gehende Fragen: „Wie können wir den größten Nutzen aus unseren KI-Modellen ziehen?“, „Wie werden sich diese Modelle verändern?“ und - ganz wichtig – „Wie können wir die Nutzung von KI in unserem Unternehmen sicher gestalten?“

In gewisser Weise sind alle drei Gedankengänge miteinander verbunden. KI-Modelle funktionieren mit Daten, von denen es bis zum nächsten Jahr weltweit etwa 175 Zettabyte geben wird. Laut IDC werden 80 % dieser Daten unstrukturiert sein, ein digitaler Haufen von Screenshots, KI-Eingaben und Nachrichten von Kollaborations-Apps, von denen die meisten nicht angemessen identifiziert oder durch herkömmliche Tools geschützt werden können.

Anstatt diese „unstrukturierten Daten“ ohne Analyse und Wert für das Unternehmen liegen zu lassen, könnte GenAI sie aufnehmen und nutzen. Wenn jedoch niemand weiß, was die Daten enthalten, besteht das Risiko, dass GenAI Informationen preisgibt, die privat bleiben sollten.

Die Analysten von Gartner gehen davon aus, dass bis 2027 mehr als die Hälfte der von Unternehmen eingesetzten GenAI-Modelle branchenspezifisch oder auf eine bestimmte Geschäftsfunktion zugeschnitten sein werden - im Vergleich zu etwa einem Prozent im Jahr 2023. Dadurch ergeben sich für Unternehmen neue Optimierungsmöglichkeiten für Abläufe, die Produktivität der Mitarbeiter zu steigern und digitale Kundenerlebnisse neu zu gestalten. Allerdings gibt es ein weiteres Aber: Je mehr GenAI-Tools mit vertraulichen oder sensiblen Betriebsdaten arbeiten, desto größer ist das Risiko, dass geschützte Informationen nach außen dringen.

Ein Unternehmen, das ein GenAI-Modell trainiert, um die Bruttomarge zu steigern, muss das Modell beispielsweise mit verschiedenen Arten von Unternehmensdaten füttern. Wenn diese Daten nicht richtig klassifiziert sind, könnten sensible Daten offengelegt oder missbraucht werden, wenn die KI Inhalte generiert.

Grundsätzlich stehen Unternehmen, die GenAI-Systeme einsetzen, vor vier großen Sicherheitsherausforderungen:

- Sichtbarkeit: Netzwerk- und Security Operations Center (SOC)-Teams haben keinen Einblick in KI-Plattformen. Deshalb können sie die Nutzung nicht überwachen oder kontrollieren und die damit verbundenen Risiken verwalten.

- Compliance: Es ist schwierig, unternehmensweite Richtlinien einzuführen und zu wissen, wer innerhalb des Unternehmens welche KI-Dienste nutzt.

- Exponierung: Sensible Daten können versehentlich von Mitarbeitern, die mit GenAI-Diensten interagieren, oder von GenAI selbst durch eine nicht authentifizierte Service Response exponiert werden. Das führt dazu, dass Endbenutzern unzulässige Daten zur Verfügung gestellt werden.

- Manipulation: Böswillige Akteure können GenAI-Modelle mit Eingaben ausnutzen, die so derart gestalten, dass sie unbeabsichtigte Aktionen auslösen oder ein böswilliges Ziel erreichen (Prompt-Injection-Angriffe). Beispiele hierfür sind Jailbreaking/Modell-Duping, Virtualisierung/Rollenspiele und Sidestepping.

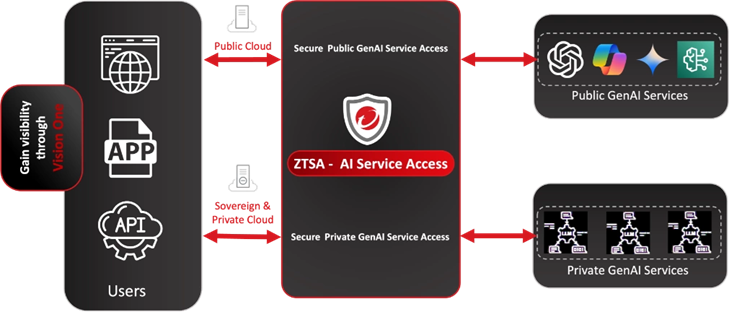

Der Zero-Trust-Ansatz bietet hier ein hervorragendes Framework, um Sicherheitsprobleme anzugehen und gleichzeitig Unternehmen die Möglichkeit zu geben, die Vorteile von GenAI in vollem Umfang zu nutzen. Ein Beispiel einer geeigneten Lösung ist Trend Micro Vision One ZTSA - AI Service Access. Das Tool stellt eine Cloud-native Plattform zur Verfügung, die jeden Benutzer schützt, der auf öffentliche oder private GenAI-Services innerhalb einer Organisation zugreift.

Damit ist eine Zero Trust-Zugangskontrolle für öffentliche und private GenAI-Dienste gegeben. Das Tool kann die KI-Nutzung überwachen und GenAI-Aufforderungen und -Antworten prüfen. Dabei werden KI-Inhalte identifiziert, gefiltert und analysiert, um potenzielle sensible Datenlecks oder ungesicherte Ausgaben in öffentlichen und privaten Cloud-Umgebungen zu vermeiden.

Zu den Kernfunktionen gehören:

- Echtzeit-Überwachung aller GenAI-Aktivitäten und sofortige Erkennung von Verstößen gegen KI-Inhalte

- Zentrale Verwaltung des Mitarbeiterzugangs zu GenAI und dessen Nutzung

- Prompt-Prüfung, um Datenlecks und bösartige Einfügungen zu verhindern

- Inhaltsfilterung zur Gewährleistung der Einhaltung von Compliance-Anforderungen

- Abwehr von Angriffen auf große Sprachmodelle (LLM)

Netzwerk- und Sicherheitsadministratoren erhalten auch Unterstützung bei der Bewältigung spezifischer GenAI-Systemrisiken wie unsichere Plugins und Erweiterungen, Angriffe auf die Lieferkette und Denial-of-Service (DoS)-Angriffe auf KI-Modelle. Durch die Priorisierung dieser Risiken und die proaktive Anwendung einer dynamischen risikobasierten Zugriffskontrolle auf GenAI-Services können Sicherheitsteams die Widerstandsfähigkeit des Unternehmens verbessern.

Zum Beispiel kann ein Administrator risikobasierte Bedingungen für eine ausgewählte Anzahl von Nutzern in einer Organisation ständig laufen lassen, um deren Risikowerte kontinuierlich zu überwachen und Zugriffskontrollregeln durchzusetzen, um den Zugriff auf GenAI-Services bei Bedarf automatisch zu sperren.