Cyberbedrohungen

AI Act: EU gibt der Nutzung von KI ein Regelwerk

Mit dem AI Act hat die EU das weltweit erste rechtlich verbindliche Regelwerk für KI-Systeme geschaffen. Es stuft KI-Systeme nach dem damit verbundenen Risiko ein und formuliert entsprechende Forderungen. Ziel: bessere KI und Schutz der Anwender.

Die EU hat den weltweit ersten rechtlich verbindlichen Rechtsakt auf den Weg gebracht hat. Die Verordnung (EU) 2024/1689 (AI-Act) legt fest, wie künstliche Intelligenz in der EU eingesetzt werden darf, welche Regelungen für Hersteller, Betreiber, Bevollmächtigte, Importeure und Händler von KI gelten. Die meisten Regelungen gelten ab dem 2. August 2026. Der Act ist als Verordnung konzipiert, und daher entfallen Umsetzungen in nationales Recht (wie z.B. bei NIS2) und die damit verbundenen Fristen. Unternehmen, besonders kleine und mittlere Unternehmen, sollen damit entlastet werden.

Ziel der neuen Regeln ist die Entwicklung einer besseren KI in Europa und weltweit, aber auch die Gewährleitung des Schutzes der Privatsphäre. Alles, was in der EU passiert, muss sich an den EU-Grundrechten orientieren. Das heißt unter anderem, jeder kann selbst entscheiden, was mit seinen Daten geschieht.

Die meisten KI-Systeme sind harmlos und können helfen, Probleme zu lösen. Doch müssen manche KI-Systeme auf ihre Gefahren hin untersucht werden. Dies betrifft besonders deren Entscheidungsfindung, denn häufig sind die Gründe, Vorschläge und Ergebnisse von KI-Anwendungen nicht nachvollziehbar. Auch Fragen an das KI-System nach der Entscheidung können falsch sein. Und deshalb ist auch nicht zu klären, ob jemand ungerecht behandelt wurde. Dies gilt z.B. für eine Bewerbung oder einen Antrag auf Sozialleistungen.

Definition von „KI Systemen“

Der Begriff „KI“ wird in der EU-Verordnung sehr weit gefasst:

„KI-System“ ein maschinengestütztes System, das für einen in unterschiedlichem Grade autonomen Betrieb ausgelegt ist und das nach seiner Betriebsaufnahme anpassungsfähig sein kann und das aus den erhaltenen Eingaben für explizite oder implizite Ziele ableitet, wie Ausgaben wie etwa Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen erstellt werden, die physische oder virtuelle Umgebungen beeinflussen können.

Der AI-Act betrifft Technologien, die über den allgemeinen Begriff der KI hinausgehen. Nach dieser Definition fallen selbst Bayes'sche Filter, gemeinhin als Spamfilter bekannt, unter den Begriff der KI. Von komplexeren Verfahren wie dem maschinellen Lernen ganz zu schweigen. Dies führt sogar dazu, dass in Kapitel 1(12) der Begriff „KI-System“ sehr weit gefasst wird. Der Entwurf ist noch klarer formuliert. Im Anhang werden die relevanten Techniken im Detail beschrieben. Es geht um

a) Konzepte des maschinellen Lernens, mit beaufsichtigtem, unbeaufsichtigtem und bestärkendem Lernen unter Verwendung einer breiten Palette von Methoden, einschließlich des tiefen Lernens (Deep Learning);

b) Logik- und wissensgestützte Konzepte, einschließlich Wissensrepräsentation, induktiver (logischer) Programmierung, Wissensgrundlagen, Inferenz- und Deduktionsmaschinen, (symbolischer) Schlussfolgerungs- und Expertensysteme;

c) Statistische Ansätze, Bayessche Schätz-, Such- und Optimierungsmethoden.

Anforderungen

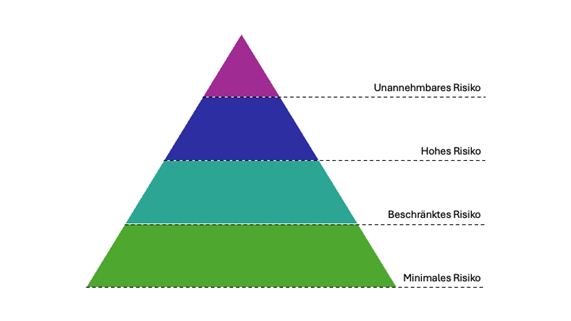

Neben der Technologie enthält der AI-Act ein zweites Kriterium, das den Umfang der Maßnahmen regelt: Die Risikoklasse des KI-Systems.

Risikobeurteilung

KI-Anwendungen und die damit verbundenen Risiken müssen klar identifiziert und adressiert werden. Dies betrifft alle Systeme, die gemäß der AI-Act-Definition von KI als solche eingestuft werden. Es obliegt dem Hersteller, Betreiber usw. des KI-Systems, eine Bewertung des Risikopotenzials und vor allem der Risikoklasse des Systems vorzunehmen.

Systeme, deren Risiko als „unannehmbar“ eingestuft wird, dürfen nicht in Verkehr gebracht werden. Für KI-Systeme, für die ein „annehmbares“ Risiko festgestellt wurde, müssen geeignete Maßnahmen zur Risikominderung getroffen und Konformitätserklärungen entsprechend ihrer Risikoklasse ausgestellt werden.

Untersagte Nutzung von KI

Der AI-Act verbietet zum Schutz der Menschen bestimmte Arten von KI-Systemen.

- Unterschwellige, manipulative und betrügerische Systeme, die die Entscheidungsfindung und das Verhalten von Menschen beeinflussen und zu nachteiligen Entscheidungen führen.

- Systeme, die Gesichtserkennungsdatenbanken erstellen, indem sie Bilder aus dem Internet oder von Überwachungskameras sammeln.

- Systeme, die Personen anhand ihrer biometrischen Daten erkennen und kategorisieren können, sind nach der Datenschutz-Grundverordnung verboten. Eine solche Verarbeitung ist nur mit Einwilligung der betroffenen Person zulässig.

- Auch der Einsatz von KI-Systemen für Social Scoring oder „Minority Report“-Szenarien ist nicht erlaubt. Social Scoring bedeutet, dass mit Hilfe von KI Menschen aufgrund ihres Verhaltens oder ihrer Persönlichkeit bewertet werden. Dies kann zu ungerechter Behandlung führen. „Minority Report” verwendet KI, um auf der Grundlage von Profilen oder Persönlichkeitsmerkmalen vorherzusagen, wer Verbrechen begehen wird. Dies gilt jedoch nicht für KI, die Menschen dabei hilft, kriminelle Aktivitäten auf der Grundlage von Fakten zu beurteilen.

Gerade biometrische Systeme bergen ein hohes Risiko. Deshalb gibt es strenge Regeln für ihren Einsatz. Sie dürfen nicht zur Überwachung von Personen in öffentlich zugänglichen Bereichen eingesetzt werden. Es gibt jedoch Ausnahmen, wenn nach Opfern von Entführung, Menschenhandel, sexueller Ausbeutung oder vermissten Personen gesucht wird, wenn das Leben von Menschen in Gefahr ist oder ein terroristischer Anschlag droht oder wenn es darum geht, Verdächtige für in bestimmten strafrechtliche Ermittlungen ausfindig zu machen. In diesen Fällen können biometrische Echtzeit-Fernerkennungssysteme unter strengen Voraussetzungen zur Strafverfolgung eingesetzt werden.

Risikoklassen

Hochrisiko-KI-Systeme

Als Hochrisiko-KI-Systeme gelten Systeme, die z. B. in folgenden Bereichen eingesetzt werden:

- Kritische Infrastrukturen

- Bildung bzw. Ausbildung: In diesem Zusammenhang sind insbesondere Systeme relevant, die den Zugang zu Bildungsmöglichkeiten sowie die Berufschancen beeinflussen können. Als Beispiel kann hier die Bewertung von Prüfungen genannt werden.

- Sicherheitskomponenten (Safety) von Produkten: z.B. KI-Anwendung in der Telemedizin

- Bewerbungs- und Personalprozesse: z.B. Klassifizierung von Lebensläufen

- Private und öffentliche Grundversorgung: z.B. Bonitätsprüfung

- Strafverfolgung, die in die Grundrechte der Bürgerinnen und Bürger eingreifen kann: z.B. Bewertung der Zuverlässigkeit von Beweismitteln

- Migrations-, Asyl- und Grenzverwaltung: z.B. automatische Prüfung von Visumanträgen

- Justizverwaltung und demokratische Prozesse: z.B. KI-Lösungen für die Suche nach Gerichtsurteilen

Diese KI-Systeme unterliegen strengen Auflagen. Dazu gehören unter anderen umfassende Systeme zur Risikobewertung und –minderung, qualitativ hochwertige Datensätze zur Minimierung von Risiken und diskriminierenden Ergebnissen, Protokollierung der Aktivitäten zur Sicherstellung der Rückverfolgbarkeit der Ergebnisse und eine ausführliche Dokumentation, damit die Behörden die Konformität beurteilen können.

Konformitätserklärung und Registrierung

Insbesondere wenn ein Hochrisiko-KI-System auf dem Binnenmarkt in Verkehr gebracht werden soll, ist ein Risikobeurteilungsprozess zwingend erforderlich. Die entsprechenden Risiken und deren Minderungsmaßnahmen müssen dokumentiert werden, bevor eine entsprechende Konformitätserklärung (CE-Kennzeichnung) ausgestellt und registriert wird.

Sobald ein KI-System veröffentlicht wird, sind die Behörden für die Marktüberwachung zuständig. Die Betreiber stellen sicher, dass eine menschliche Aufsicht und Überwachung gewährleistet ist, während die Lieferanten ein System zur Überwachung nach dem Inverkehrbringen eingerichtet haben. Die Meldepflicht der Lieferanten und Händler erstreckt sich auch auf schwerwiegende Vorkommnisse und Zwischenfälle. Darüber hinaus werden Maßnahmen für die Marktzulassung von KI-Systemen und die Einrichtung einer Governance-Struktur auf europäischer und nationaler Ebene festgelegt.

Beschränktes Risiko

Mangelnde Transparenz bei der Anwendung von KI stellt ein gewisses Risiko dar. Der EU-Act hat spezifische Transparenzanforderungen, um sicherzustellen, dass die Menschen bei Bedarf informiert werden. So muss etwa beim Einsatz von KI-Systemen wie Chatbots sichergestellt werden, dass Nutzer und Nutzerinnen darüber informiert sind, dass sie mit einer Maschine interagieren, um zu entscheiden, ob sie die Interaktion fortsetzen wollen. Die Anbieter müssen auch sicherstellen, dass KI-generierte Inhalte identifizierbar sind. Dies gilt auch für Audio- und Videoinhalte, sogenannte Deep Fakes.

Minimales Risiko

Der AI-Act erlaubt die uneingeschränkte Nutzung von KI mit geringem Risiko, einschließlich Anwendungen wie KI-integrierte Videospiele oder Spam-Filter.

Auswirkungen auf Cyber(-Security)

Die Auswirkungen des AI-Acts auf die Cybersicherheit sind überraschend gering. Zwar fallen aufgrund der sehr weit gefassten technologischen Definition sehr viele Cybersicherheitsprodukte und -lösungen unter den AI-Act, doch führen der Nutzungskontext und die Art der verwendeten Daten in den meisten Fällen zu einer Einstufung als KI-System mit begrenztem oder minimalem Risiko. Dies bedeutet, dass Hersteller, Betreiber, Bevollmächtigte, Importeure und Händler von Cybersicherheitslösungen in der Regel nur sehr wenigen Verpflichtungen unterliegen.

Dennoch empfiehlt es sich für alle Beteiligten, über den Wortlaut des AI-Acts hinauszublicken und die Absicht des AI-Acts zu berücksichtigen. Dies bedeutet z.B., auch beim Betrieb von KI-Systemen mit minimalem Risiko die Qualitäts- und Compliance-Kriterien von Hochrisikosystemen anzuwenden.

Müssen diese (wie bei Hochrisikosystemen) erfüllt werden? Müssen ... nein! Ist es trotzdem empfehlenswert, sich an diesen Kriterien zu orientieren und die Ergebnisse (positive wie negative) zu dokumentieren? Auf jeden Fall!

Zum einen können sich rechtliche Anforderungen im Laufe der Zeit ändern. Andererseits kann der verantwortungsvolle Umgang mit KI-Technologie zu einer vertraglichen Verpflichtung werden. Und auch unabhängig davon orientieren sich die Anforderungen am Rechtsverständnis der EU (z.B. Recht auf die eigenen Daten - siehe DSGVO)... was potentielle (Privat-)Kunden sicherlich zu schätzen wissen.