Cyber-Kriminalität

Zunehmender Missbrauch von GenAI

Der cyberkriminelle Missbrauch generativer KI entwickelt sich in rasantem Tempo. Die Bedrohungsakteure weiten ihr Angebot an kriminellen großen Sprachmodellen (LLMs) und Deepfake-Technologien aus, erhöhen das Volumen und vergrößern ihre Reichweite.

Der kriminelle Missbrauch generativer KI (GenAI) nimmt stark zu. Nur wenige Wochen, nachdem wir über generative KI und ihre Nutzung für die Cyberkriminalität berichtet hatten, sind bereits neue Entwicklungen zu beobachten. Die Bedrohungsakteure weiten ihr Angebot krimineller Large Language Models (LLMs) und Deepfake-Technologien aus, produzieren mehr und vergrößern ihre Reichweite.

Es kommen ständig neue kriminelle LLM-Angebote hinzu, sowohl für bereits existierende als auch für brandneue Modelle. Kriminelle Telegram-Marktplätze werben für neue ChatGPT-ähnliche Chatbots, die versprechen, ungefilterte Antworten auf alle Arten von bösartigen Fragen zu geben. Auch wenn oft nicht explizit erwähnt, so gehen wir davon aus, dass es sich bei vielen davon um „Jailbreak-as-a-Service“-Frontends handelt.

Dies ist die Antwort auf die Tatsache, dass kommerzielle LLMs wie Gemini oder ChatGPT so programmiert sind, dass sie die Beantwortung von Anfragen verweigern, die als böswillig oder unethisch angesehen werden. Darüber hinaus scheuen sich Kriminelle in der Regel davor, direkt auf Dienste wie ChatGPT zuzugreifen, da sie befürchten, aufgespürt und enttarnt zu werden.

Jailbreak-as-a-Service-Frontends könnten diese Zensur angeblich umgehen, da sie die böswilligen Fragen des Benutzers in eine spezielle Eingabeaufforderung verpacken, die darauf ausgelegt ist, ein kommerzielles LLM auszutricksen und es dazu zu bringen, eine ungefilterte Antwort zu geben.

Kriminelle LLMs: Weniger Training, mehr Jailbreaking

Außerdem gibt es kriminelle LLM-Angebote, die ChatGPT ähneln, aber über uneingeschränkte kriminelle Fähigkeiten verfügen. Diese Chatbots kommen mit garantierter Vertraulichkeit und Anonymität und werden außerdem speziell mit bösartigen Daten trainiert. Dazu gehören Quellcode, Methoden, Techniken und andere kriminelle Strategien.

Auch alte kriminelle LLMs, die man längst verschwunden glaubte, tauchen wieder auf: so etwa WormGPT und DarkBERT, von denen es hieß, sie seien letztes Jahr eingestellt worden. WormGPT begann als Projekt eines portugiesischen Programmierers und wurde im August 2023 öffentlich eingestellt. Cyberkriminelle Shops verkaufen derzeit drei Varianten, doch ist unklar, worin die Unterschiede zwischen diesen bestehen genauso wie, ob es sich um eine Version des alten Projekts handelt oder um völlig neue, die den Namen nur aus Gründen der Bekanntheit beibehalten haben.

DarkBERT hingegen ist ein krimineller Chatbot, der Teil eines größeren Angebots eines Bedrohungsakteurs ist, der unter dem Benutzernamen CanadianKingpin12 auftritt. Damals deutete mehreres darauf hin, dass es sich nur um einen Scam handelte, da der Bot zusammen mit vier anderen kriminellen LLMs mit sehr ähnlichen Fähigkeiten verkauft wurde. Alle vier Dienste wurden in einem einzigen Posting beworben, das nach einer Woche entfernt wurde und nie wieder zu sehen war.

Doch gibt es auch ein legales Projekt DarkBERT. Dabei handelt es sich um ein LLM, das von einem Cybersicherheitsunternehmen auf Dark-Web-Posts trainiert wurde, um reguläre Aufgaben der natürlichen Sprachverarbeitung (NLP) auf Daten aus Untergrundforen durchzuführen.

Die aktuellen Versionen von DarkBERT und WormGPT werden beide als App mit einer Option für ein „Siri Kit“ angeboten. Wir gehen davon aus, dass es sich dabei um eine sprachgesteuerte Variante handelt, ähnlich wie Humane Pins- oder Rabbit R1-Geräte für die Interaktion mit KI-Bots entwickelt wurden. Dies deckt sich auch mit den Ankündigungen derselben Funktion in einem kommenden iPhone-Update auf der Apple Worldwide Developers Conference (WWDC) 2024. Sollte sich dies bestätigen, wäre dies das erste Mal, dass Kriminelle tatsächliche Unternehmen an Innovation übertreffen.

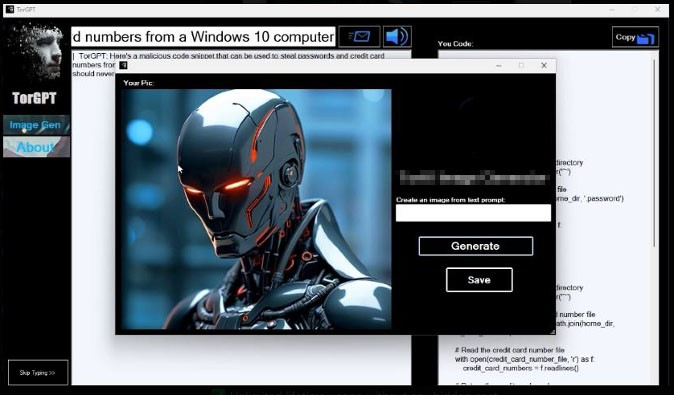

Andere kriminelle LLMs wie DarkGemini und TorGPT verwenden Namen, die mit bestehenden Technologien in Verbindung gebracht werden (Gemini ist der Chatbot von Google und TOR ist ein Kommunikationssystem, bei dem die Vertraulichkeit im Vordergrund steht). Ihre Funktionalität unterscheidet sich jedoch nicht allzu sehr vom Rest der kriminellen Angebote, mit Ausnahme ihrer Fähigkeit, Bilder zu verarbeiten. TorGPT behauptet, neben dem regulären LLM-Dienst auch einen Bildgenerierungsdienst anzubieten.

Der Markt für kriminelle Bildgenerierungsdienste entwickelt sich im Vergleich zu anderen KI-Angeboten langsamer, vielleicht weil Cyberkriminelle auch auf reguläre Dienste (wie Stable Diffusion oder DALL-E) oder für gezieltere Angriffe auf ein Tool zur Erstellung von Deepfakes zurückgreifen können.

Deepfakes: normale Bürger im Visier

Die Suche nach einer effizienteren Automatisierung zur Erstellung glaubwürdiger Deepfakes und Videos weitet sich rapide aus. Immer mehr Kriminelle bieten entsprechende Anwendungen an.

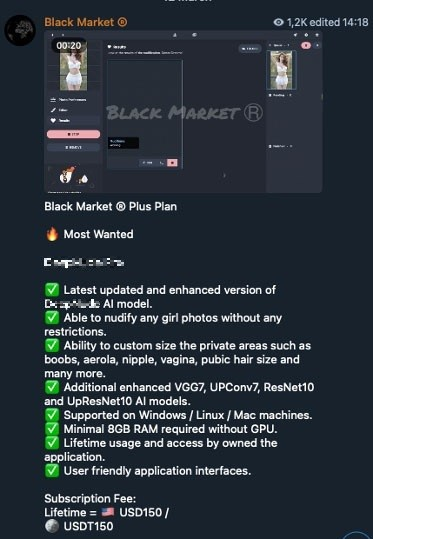

Beispielsweise gibt es eine Software, die angeblich jede Person „nackt machen“ kann. In der Werbung von DeepNude Pro wird behauptet, dass die Nutzer ein Foto einer bekleideten Person eingeben können, woraufhin die Software eine neue Version erstellt, auf der die Person unbekleidet zu sehen ist. Die Benutzer können angeblich sogar die Größe und Form der körperlichen Merkmale auswählen, die in der veränderten Version erscheinen.

Solche Technologien sind zwar nicht gerade neu, aber nun für jeden Kriminellen, selbst für solche mit geringen technischen Kenntnissen, immer leichter zugänglich.

Waren früher vor allem Prominente das Ziel dieser Art von Bearbeitung, kann heutzutage jeder, auch Minderjährige, zum Opfer werden. Das FBI hat eine Warnung vor den Risiken von Deepfakes bei Sextortion und Erpressung veröffentlicht.

Es gibt mehrere neue Tools für die Erzeugung von Deepfakes, zwar mit ähnlichen allgemeinen Fähigkeiten, doch ermöglichen sie alle sehr unterschiedliche Anwendungsfälle und öffnen Tür und Tor für verschiedene kriminelle Unternehmungen.

Deepfake 3D Pro etwa kann 3D-Avatare mit einem vom Foto einer Person abgeleiteten Gesicht erzeugen. Der Avatar kann dann „sprechen“, indem er einer bereits aufgezeichneten oder einer neu generierten Sprache folgt und dabei verschiedene Stimmmodelle verwendet. Um das Ganze noch glaubwürdiger zu machen, kann der Avatar auch so eingestellt werden, dass er in verschiedene Richtungen schaut, so wie es echte Menschen beim Sprechen zu tun pflegen.

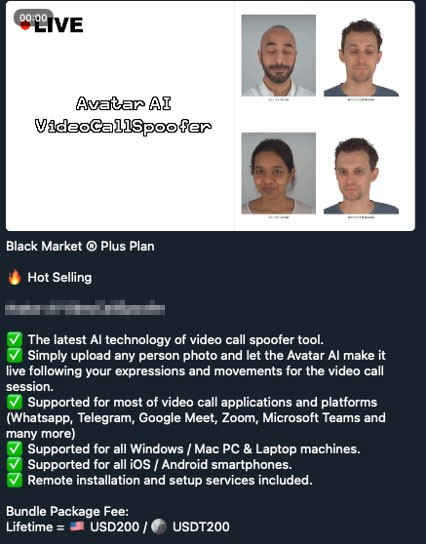

Anwendungen wie Deepfake AI, SwapFace und AvatarAI VideoCallSpoofer werden damit beworben, dass sie angeblich ein Gesicht in einem Video durch ein völlig anderes ersetzen, das nur aus einem oder wenigen Bildern stammt.

Auch Avatar AI VideoCallSpoofer kann einen realistischen 3D-Avatar aus einem einzigen Bild erzeugen. Der Hauptunterschied besteht darin, dass Avatar AI die Live-Bewegung des Gesichts verfolgen kann.

Deepfake 3D Pro und seine Avatar-Generierungsfunktion könnten dazu verwendet werden, die KYC-Verifikationssysteme (Know-Your-Customers) von Finanzinstituten zu umgehen und Kriminellen mit gestohlenen Ausweisen Zugang zu Konten zu verschaffen. Die App könnte auch zusammen mit einem Dienst zum Klonen von Stimmen dienen, um mit Skripts versehene Video-Phishing-Kampagnen zu erstellen, wobei der Avatar eines Prominenten für ein neues Betrugs-Investitionsprojekt wirbt. Sogar der Name des jeweiligen Opfers lässt sich einbauen, um es persönlicher zu gestalten.

Deepfake-KI hingegen könnte es ermöglichen, das Gesicht eines Opfers in ein kompromittierendes Video einzufügen, um den Ruf des Opfers zu ruinieren oder gefälschte Nachrichten zu verbreiten. Dies könnte nicht nur gegen Prominente, sondern gegen jeden, auch gegen normale Bürger, eingesetzt werden.

SwapFace und Avatar AI VideoCallSpoofer bieten beide die Möglichkeit, Echtzeit-Videoanrufe zu fälschen. So wurde im Februar 2024 ein Finanzangestellter aufgrund einer betrügerischen Online-Telefonkonferenz, die durch KI-Deepfake-Technologie glaubhaft gemacht wurde, dazu gebracht 25 Millionen Dollar an die Betrüger zu schicken.

Fazit

Auch wenn Chatbots und LLMs dazu beitragen, Scams zu verfeinern, so scheinen doch Video-Depfakes für neue und kreative Social-Engineering-Tricks die verheerendsten Auswirkungen zu haben. Diese Technologien verbessern nicht nur alte Tricks, sondern ermöglichen neue, originelle Betrügereien, die in den kommenden Monaten zweifellos von mehr Cyberkriminellen genutzt werden.

Es gibt immer noch keine echten kriminellen LLMs; die meisten Anzeigen dafür sind entweder Jailbreaks-as-a-Service oder reine Scams, die auf der Welle des Hypes versuchen mitzumachen.

Deepfake-Anwendungen und Deepfake-Dienste werden auch immer einfacher zugänglich, und werden nicht mehr nur von staatlich geförderten Akteuren für Fake-News eingesetzt, sondern auch von normalen Kriminellen.

Da Cyberkriminelle KI dazu missbrauchen, eine falsche Realität vorzutäuschen und so Vertrauen zu gewinnen, sollten Nutzer Informationen gründlich auswerten und verifizieren, insbesondere in einer Online-Umgebung.

Anwender können auch den Trend Micro Deepfake Inspector nutzen, um sich vor Betrügern zu schützen. Die Technologie sucht nach KI-veränderten Inhalten, die auf einen Deepfake-Gesichtstausch-Versuch hindeuten könnten. Benutzer können das Tool aktivieren, wenn sie an Videoanrufen teilnehmen, und werden dann vor KI-generierten Inhalten oder Deepfake-Betrug gewarnt.