APT und gezielte Angriffe

Generative KI-Tools für Deepfakes

Kriminelle bieten derzeit immer noch keine innovativen generativen KI-Tools, sondern setzen auf die Fähigkeiten der vorhandenen mit zusätzlichen Jailbreaking-Möglichkeiten. Außerdem nehmen Deepfake-Angebote zu, etwa für gefakte Benutzerüberprüfungen.

Kernaussagen

- Die Akzeptanz von KI-Technologien bei Kriminellen bleibt hinter derjenigen in der Industrie hinterher.

- Im Vergleich zum letzten Jahr scheinen die Kriminellen jeden Versuch aufgegeben zu haben, echte kriminelle große Sprachmodelle (LLMs) zu trainieren. Stattdessen jailbreaken sie bestehende Modelle.

- Aufkommen echter krimineller Deepfake-Services, von denen einige die bei Finanzdienstleistungen übliche Benutzerüberprüfung umgehen.

Vor einem Jahr untersuchten wir, wie Kriminelle generative KI-Funktionen (GenAI) einsetzen oder einsetzen wollen, um ihre Angriffe zu entwickeln, zu verbreiten und zu verbessern. Jetzt wollten wir sehen, ob es seither interessante Entwicklungen gegeben hat. Doch im Vergleich zu ersten Untersuchung sind unsere Schlussfolgerungen immer noch dieselben: Kriminelle hinken bei der Einführung von KI immer noch hinterher.

In einem ersten Teil stellten wir dar, wie Kriminelle weiterhin auf die Möglichkeiten setzen, die ChatGPT und andere vorhandene LLMs bieten. „Jailbreaking-as-a-Service“ ist eines der Stichwörter.

Krimineller Einsatz von LLMs

Kriminelle nutzen generative KI-Fähigkeiten für zwei Zwecke:

- Unterstützung der Entwicklung von Malware oder bösartigen Tools. Dies ähnelt der weit verbreiteten Nutzung von LLMs durch die Softwareentwickler. Laut Statistiken des letzten Jahres nutzen 92% der Entwickler LLMs, sei es allein für ihre Arbeit, sei es zusätzlich außerhalb der Arbeitsumgebung.

- Verbesserung ihrer Social Engineering-Tricks. LLM erweisen sich als besonders geeignet für Social Engineering, wo sie eine Vielzahl von Funktionen bieten können. Kriminelle nutzen sie, um Betrugsskripts zu erstellen und die Produktion von Phishing-Kampagnen zu steigern. Zu den Vorteilen gehören die Fähigkeit, Schlüsselelemente wie das Gefühl der Dringlichkeit zu vermitteln und die Möglichkeit, Text in verschiedene Sprachen zu übersetzen. Letzteres hat sich als eine der nützlichsten Möglichkeiten erwiesen, da neue Märkte zugänglich werden, die für einige kriminelle Gruppen aufgrund von Sprachbarrieren zuvor nicht zu erreichen waren.

Kriminelle Deepfake-Dienste im Kommen

Obwohl es Deepfakes schon länger gibt als andere GenAI-Systeme, fanden wir erst in letzter Zeit echte kriminelle Angebote. Einige Cyberkriminelle präsentieren ihre Fähigkeiten bei der Erstellung von Deepfakes und veröffentlichen ihre Preisliste. Sie verlangen in der Regel von 10 US-Dollar pro Bild bis zu 500 US-Dollar pro Videominute, können aber auch höher liegen. Die Beispiele, die in „Portfolio“-Gruppen gezeigt werden, stellen in der Regel Prominente dar, damit sich ein potenzieller Käufer ein Bild davon machen kann, was der Künstler für ihn erstellen kann.

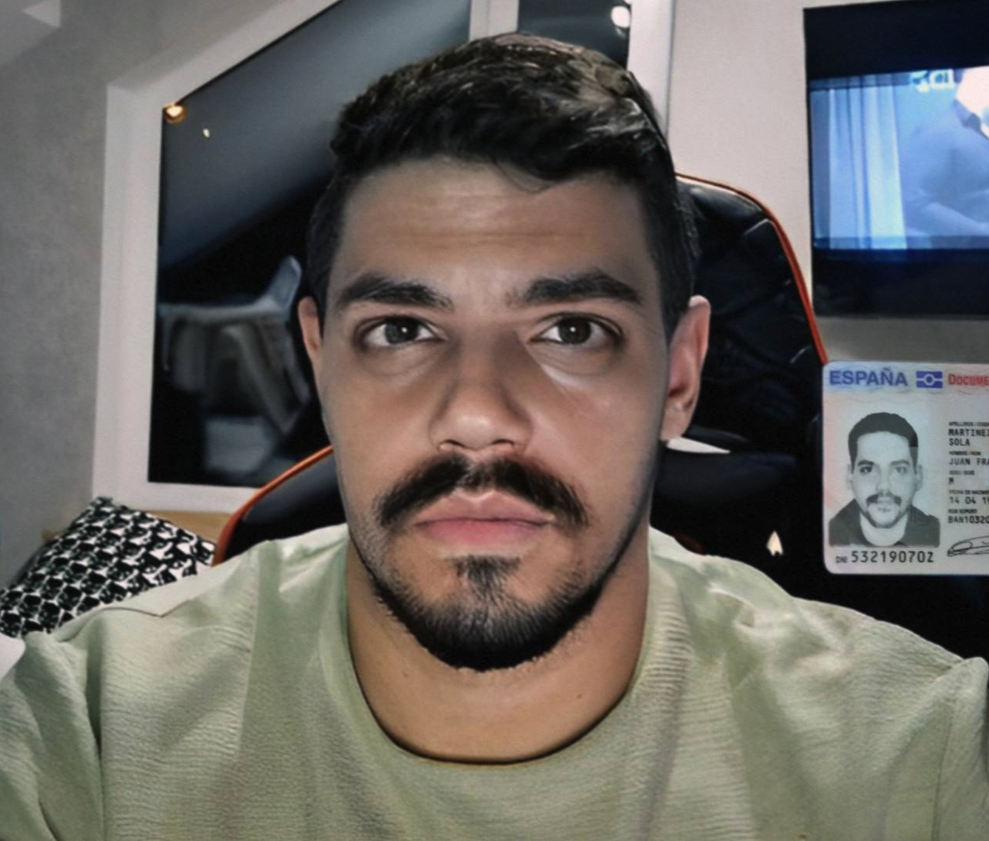

Es gibt auch gezieltere Angebote für Deepfake, mit denen Systeme zur Überprüfung der Kundenidentität (Know-Your-Customer (KYC)) umgangen werden können. Banken und Kryptowährungsbörsen fordern den Nachweis, dass alle Kontoinhaber echte Personen sind. Damit soll verhindert werden, dass Kriminelle mit gestohlenen Identitäten Konten eröffnen. Bei der Eröffnung eines neuen Kontos verlangt das Finanzunternehmen in der Regel, dass der Nutzer ein Foto von sich macht, auf dem er einen Ausweis vor die Kamera hält.

Um dies zu umgehen, bieten Kriminelle nun an, ein gefälschtes Bild mit einem gestohlenen Ausweis zu erstellen, um das System von der Legitimität des Kunden zu überzeugen.

Das Bild wurde auf der Grundlage eines gestohlenen Personalausweises eines Kriminellen erstellt. Der Deepfake-Künstler warb mit diesem Bild bei potenziellen Kunden für sein Können. Einige garantieren sogar den Erfolg, wenn ihre Dienste bei bestimmten beliebten Kryptowährungsbörsen genutzt werden.

Im Allgemeinen wird es immer einfacher und billiger, einen Deepfake zu erstellen, der gut genug für breit angelegte Angriffe ist, die auf ein Publikum abzielen, das mit dem Thema nicht allzu vertraut ist. Jüngste Beispiele für Deepfake-Angriffe nutzten die gefakte Führungskräfte von Kryptobörsen wie Binance oder falsche Werbeanzeigen mit Personen des öffentlichen Lebens wie Elon Musk.

Problematisch wird es für Kriminelle, wenn ein Deepfake-Angriff auf eine Person abzielt, die der nachgeahmten Person nahe steht, da diese Videos noch nicht so weit sind, Personen täuschen zu können, die mit der nachgeahmten Person vertraut sind. Daher bevorzugen Kriminelle, die gezieltere Angriffe auf Einzelpersonen durchführen wollen - wie bei virtuellen Entführungsbetrügereien - stattdessen Audio-Deefakes. Diese sind kostengünstiger zu erstellen, erfordern weniger Daten von der Zielperson und liefern überzeugendere Ergebnisse. In der Regel reichen ein paar Sekunden der Stimme der Zielperson aus, und diese Art von Audiodatei ist häufig in sozialen Medien öffentlich zugänglich.

Fazit

Im Vergleich zu unserer Analyse der bösartigen KI-Verbreitung im letzten Jahr hat sich nicht viel verändert. Die Erwartung größerer Störungen hat sich bislang nicht erfüllt. Die Entwicklung verläuft eher langsam und allmählich, der allgemeinen kriminellen Denkweise entsprechend.

Um die Vorgehensweise von Kriminellen bei der Übernahme einer neuen Technologie besser zu verstehen, muss man drei grundlegende Regeln ihres Geschäftsmodells kennen:

- Kriminelle wollen ein leichtes Leben. Finanziell motivierte Akteure verfolgen das Ziel, mit möglichst kleinem Aufwand ein bestimmtes wirtschaftliches Ergebnis zu erreichen. Um das Verhältnis zwischen Belohnung und Risiko einer kriminellen Aktivität zu optimieren, muss die Risikokomponente niedrig gehalten werden. Mit anderen Worten: Sie versuchen, alle Unwägbarkeiten auszuschalten, die zu negativen Folgen, wie etwa einer Inhaftierung, führen könnten.

- Neue Technologien müssen nicht einfach gut sein, sondern besser als das vorhandene Toolset. Kriminelle übernehmen neue Technologien nicht nur, um mit der Innovation Schritt zu halten, sondern nur dann, wenn die Rendite höher ist als bei dem, was für sie bereits funktioniert.

- Evolution statt Revolution. Dies ist die Devise von Kriminellen. Da bei ihren Aktivitäten viel auf dem Spiel steht, führt jedes unbekannte Element zu neuen Risikofaktoren. Dies erklärt, warum die Änderungen, die Cyberkriminelle vornehmen, oft eher Differenzierungen als komplette Überarbeitungen sind.

Was ist zu erwarten?

Der Bedarf an einem sicheren, anonymen und unauffindbaren Zugang zu LLMs besteht weiterhin. Dies wird kriminelle Dienste dazu veranlassen, sich immer wieder neue LLMs zunutze zu machen, die leichter zu jailbreaken oder auf ihre speziellen Bedürfnisse zugeschnitten sind. Derzeit gibt es mehr als 6.700 leicht verfügbare LLMs auf Hugging Face.

Wir können auch davon ausgehen, dass mehr alte und neue kriminelle Tools GenAI-Funktionen integrieren werden. Kriminelle haben gerade erst begonnen, an der Oberfläche der tatsächlichen Möglichkeiten zu kratzen, die GenAI ihnen bietet.

Nach Jahren des Bestehens haben wir nun die ersten kriminellen kommerziellen Angebote rund um Deepfakes für die Umgehung der KYC-Verifizierung und Deepfake-as-a-Service gesehen. Wir können uns auf ein Katz-und-Maus-Spiel zwischen Finanzinstituten einstellen, die versuchen, falsche Verifizierungsversuche von Nutzern zu erkennen, und Kriminellen, die versuchen, sie mit noch raffinierteren Deepfakes zu umgehen.