美國加州為了防範 AI 風險所提出的 SB 1047 法案,在今年夏天引發了一場爭議性風暴,以及一些至今仍無明確解答的問題:從 AI 風險該如何判定,到這些法規將如何衝擊 AI 創新。AI 模型的發展絕非唯一需要框架來防範不良後果的領域,本期的 AI Pulse 將探討 AI 法規的議題以及一些相關問題,包括:AI 如何應用到戰爭中,以及當模型已無資料可用時,AI 將如何發展下去。

不論您喜歡與否,AI 法規已經勢在必行

即使歐盟、英國和美國已在 2024 年 9 月簽署了第一份對 AI 具法律約束力的條約,但「歐洲非營利法律中心」(European Center for Not-for-Profit Law) 的專家卻聲稱這項協議並無實質效力,這正是當前 AI 的處境。

正當鼓吹「抓住未來」與宣稱「末日將近」的雙方陣營為了 AI 的快速演進而針鋒相對之際,立法機關正陷入了窘境,必須在缺乏共識而不知該如何評估風險、預測功能、或規劃這項技術未來方向的情況下,提出一些管制措施。

本期的 AI Pulse 將探討 AI 法規所面臨的一些挑戰和棘手問題,還有最新的威脅趨勢,以及 AI 廠商在無新鮮資料可用來訓練模型時,將面臨什麼挑戰。

[AI 新聞]

AI 法規的最新消息

獨具慧眼?還是不食人間煙火?

今年夏天,加州的立法機關才剛打出一手好牌,保護了表演者免於數位肖像遭非法利用的困境,卻因為一項更嚴格的 AI 立法而遭到批評並登上頭條新聞,那就是:安全可靠的先驅人工智慧創新模型法案 (SB 1047)。

就連像 Geoffrey Hinton 和 Yoshua Bengio 這樣的 AI 專家都對這項即將完成立法的法案表示讚賞,但批評者卻認為這項法案是一項錯誤。Andrew Ng 告訴《富比世》(Forbes),SB 1047 犯了一項「基本錯誤」將 AI 當成一種技術來監管,而非聚焦在個別的應用。此外,也有人表示這可能會阻礙創新。

最後一項擔憂並不完全符合真實世界的經驗,金融服務業和醫療業是眾所皆知最受嚴格監管的產業,但同時也是率先導入 AI 的產業,而且加拿大最近一份有關 AI 能降低醫院意外死亡率的研究也證明了這點。

至少,加州急於為 AI 立法的舉動,突顯出假使別的司法管轄區也想跟進的話,必須面臨哪些關鍵問題,而他們跟進的可能性頗大,因為大多數美國人都認為 AI 廠商應對 AI 技術所造成的損害負起責任。

要多少個零才算構成威脅?

根據加州的認定,其新法案將適用於成本 1 億美元 (含) 以上的 AI 模型,且訓練速度至少要達到每秒 10 的 26 次方個浮點運算 (也就是 1 後面跟著 26 個零)。幾乎所有人都認為這些衡量指標對 AI 威脅的潛力來說並不夠精確。那麼立法機關和監理機構「到底」該如何衡量 AI 的風險? AI 廠商都有自己的框架,但這些有時也同樣令人質疑。

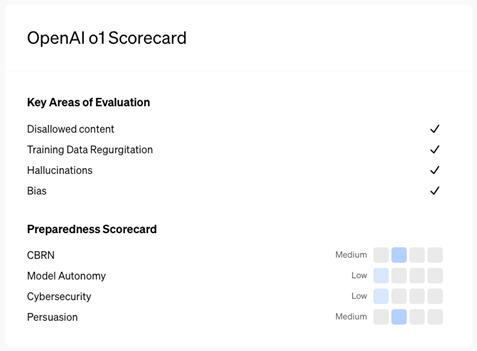

舉個例子:OpenAI 在 9 月份針對其最新的 o1 模型發布了一張評分卡,該模型在「自主性」與「網路資安」方面被評定為低度風險,而在「說服力」與「化學、生物、放射與核子 (CBRN) 危險」方面被評定為中度風險。該公司認為只要是中低風險的都算是可以部署,但 Yoshua Bengio 卻向 《Newsweek》 表示,o1 模型在 CBRN 方面被評定為中度風險,「...突顯出導入像 SB 1047 這樣的立法來保護社會大眾有其重要性和急迫性。」 具有說服力的行為,有時比危險的資訊更令人擔憂。而且 o1 的欺騙能力也變得更加強大,讓人對不受控的 AI (Rogue AI) 更加擔憂。

也許,最好的辦法就是讓產業和政府攜手合作共同確保 AI 的安全,一項正面的發展就是美國「國家標準與技術局」(National Institute of Standards and Technology,簡稱 NIST) 和 OpenAI 及 Anthropic 在八月下旬達成一項協議,同意在 AI 安全的研究、測試和評估上進行合作。

引用來源:o1 評分卡已於 2024 年 9 月 12 日公布在 OpenAI 的網站,請至:https://openai.com/index/openai-o1-system-card/

AI 走入戰爭

絕大多數的 AI 法規都是為了防止 AI 系統造成傷害,但在戰爭當中,分際卻很難拿捏:我們要如何確保 AI 武器只會造成「適度的」傷害。最近,紐約時報一篇外部專欄 指出,這世界尚未對 AI 武器系統所帶來的後果做好準備,並指出烏克蘭步隊如何因為自殺式無人機的襲擊而放棄了坦克,而這也預告了「一世紀以來我們所認知的人類機械化戰爭的結束」。(現在烏克蘭派遣的都是無人坦克。)

這些都是今年 9 月在南韓參加第二屆 REAIM 高峰會 (REAIM Summit) 的軍事和外交領袖們心中的疑問。(REAIM 是「軍事領域的負責任 AI」(Responsible AI in the Military Domain) 的縮寫。) 此次會議誕生了一份「行動藍圖」(Blueprint for Action),列舉了 20 項 AI 在軍事上的使用原則,包括「人類仍應對 AI 的使用以及 Al 應用在軍事領域所帶來的效應負責,而且責任與究責永遠不能移轉到機器上。」

但並非所有國家都支持這份藍圖,而這也使得《印度時報》(Times of India) 刊登了一個挑釁的新聞標題:「中國拒絕簽署禁止 AI 用於核武管制的協議」。但現實比這更複雜,不過 REAIM 確實突顯了讓世界各國對 AI 武器的使用方式達成共識的重要性。

CoSAI 立志讓 AI 更安全

標準制定機構 OASIS Open 在今年夏天發起了「安全 AI 聯盟」(Coalition for Secure AI,簡稱 CoSAI),作為一個讓科技產業成員共同努力提升 AI 安全的論壇。其具體的目標包括:確保人們對 AI 的信任,以及開發一些設計上即具備安全的系統來促進負責任的 AI 發展。

此外,其他團體也點出了一些產業和 AI 使用者可導入的 AI 安全最佳實務原則 (不論是否已經有立法存在)。一個最好的例子就是「開放全球應用程式安全計畫」(Open Worldwide Application Security Project,簡稱 OWASP) 今年稍早所發布的「十大檢核表」(Top 10 Checklist),裡面詳列了大型語言模型 (LLM) 相關的重大風險以及該如何防範。

對許多觀望者來說,他們最擔心的問題之一就是 AI 被用於選舉欺騙,尤其美國總統大選正邁入倒數階段。今年 3 月,有將近 20 多家公司簽署了一份協議來共同打擊在 2024 年選舉中將 AI 用於欺騙用途,這些公司包括:Adobe、Amazon、Anthropic、Arm、EvenLabs、Google、IBM、Inflection AI、LinkedIn、McAfee、Meta、Microsoft、Nota、OpenAI、Snap、Stability AI、TikTok、Truepic、X 以及趨勢科技,這又是一次人們針對 AI 安全展現集體行動力量 (及必要性) 的範例。

[AI 威脅趨勢]

AI 威脅趨勢

美國司法部 (DOJ) 逮到了俄羅斯的「Doppelganger」網域

今年 9 月 4 日,美國司法部宣布查獲了 32 個「被俄羅斯政府用來暗中從事大外宣的網域,這些大外宣的目的是要降低國際對烏克蘭的支持、支持親俄的政策與俄羅斯的利益,並且左右美國及外國選舉的選民...」。這些活動都隸屬於一個名為「Doppelganger」的影響力行動,該行動違反了美國的洗錢防制法與商標法。

美國當局對於意圖左右 11 月總統大選結果的不實資訊、輿論操弄及 AI 的欺騙性使用,仍保持高度警戒。根據福斯新聞 (Fox News) 指出,美國檢察總長 Merrick Garland 也將矛頭指向俄羅斯國營媒體《Russia Today》(RT),同時,Meta 也在 9 月 17 日基於境外干預的理由宣布在 Facebook 和 Instagram 上禁掉該媒體。

「讓我看一下我的風險資料庫...」

今年 8 月,美國麻省理工學院 (MIT) 推出了一個公共的 「AI 風險資料庫」(AI Risk Repository),以一種容易理解並可管理的方式來列舉及分類不斷成長的 AI 風險。當前的版本根據 40 多種不同的框架列舉了 700 多項風險,包括其引用來源以及風險的雙重分類:其一是根據因果關係 (指出風險發生的時間、方式與原因),其二則根據七大主要領域,包括:隱私與安全、駭客、假訊息以及其他等等。

MIT 表示,該資料庫將定期更新,並支援研究、教育、稽核以及政策制定等用途,並且為所有的利害關係人提供一個「共同的參考框架」來討論 AI 相關的風險。

Grok AI 仰賴 X 的使用者資料來提供自以為聰明的「反覺醒」(anti-woke) 輸出

X 的 Grok AI 是專為 AI 搜尋助理而設計,比起其他聊天機器人,其防護措施更少,而且對「覺醒文化」的敏感度也較低。儘管這顯然很諷刺,但事實證明它比某些人預期的更心胸開放,但卻因為另一個截然不同的原因而引發爭議。今年夏天,人們發現 X 會自動幫使用者同意提供自己的資料給 Grok 做訓練。這惹怒了歐洲的監理機關,並引來一些人的批評,例如 NordVPN 的技術長 Marijus Briedis 即向《WIRED》表示此舉將「對隱私權帶來重大影響」,包括「可以存取和分析潛在的隱私或敏感資訊,…[還有]能在最低的節制下生成影像和內容。」

[AI 預測]

AI 模型建構的未來發展

人工智慧正面臨嚴重的資料枯竭

資料來源:Bing:一個被困在沙漠中的 AI LLM,它非常口渴,線路外露並瘦得只剩一具骷顱,象徵脫水嚴重。它手握著一個盛滿資料的玻璃杯,資料閃爍著顯眼的零與壹。這具骷顱的額頭上印著「AI」兩字,眼眶裡透出藍色光芒,地面乾裂。

Grok AI 並非唯一陷入資料擷取爭議的平台。9 月初,Clearview AI 就被罰了 3,300 萬美元,理由是他們非法累積了 300 億張影像來為執法機關提供臉部辨識服務。

有部分的問題是,AI 廠商正面臨龐大壓力必須尋找新的資料來訓練他們的模型。隨著模型越來越大,需要的資料也越來越多,但很多網站卻更嚴格地保護自己的內容。

根據 dataprovenance.org 發布的一份報告指出,2023 至 2024 年「來自網站的資料正快速受到限制,這不僅將影響商用 AI,同時也將衝擊非商用 AI 與學術研究。」 此外,許多生成式 AI 現在正在使用其先前版本所產生的內容來做訓練,因而面臨了《Nature》所說的「模型塌陷」的風險。新鮮的人類資料是高品質輸出的關鍵。

該不該擴大,這才是問題

有鑑於資料枯竭的威脅以及 AI 模型所需的密集運算,有些企業正在實驗規模較小的輕量化模型。根據 NVIDIA 最近一篇部落格指出,NVIDIA 的 Mistral-NeMo-Minitron 8B 是該公司 NeMO 12B 基礎模型的「寬度縮小」版,「它小到可以在使用 NVIDIA RTX 顯示卡的工作站上執行,但依然能在一些 AI 聊天機器人、虛擬助理、內容生成器和教育工具等各項評測中表現優異。」

此外,Microsoft 也正在開發較小的模型,根據最近 X 上的一篇貼文指出,Copilot 的本機版本目前已內建 RWKV 模型來出貨,該模型採用了「循環神經網路」(RNN) 架構,而非業界標準的「轉換器」(Transformer) 模型,因而讓它變得更快、更省電。(RWKV 也推出了一個免費的轉換器模型,專為解決數學和編碼問題而設計。)

AI 的電力問題

AI 除了資料的胃口龐大之外,同時也是吃電怪獸。這問題在今年 9 月當美國參議院「能源與自然資源委員會」(Committee on Energy and Natural Resources) 向「能源部」(Department of Energy,簡稱 DOE) 詢問 AI 的電力需求時,立即成了關注焦點。DOE 的「關鍵與新興技術辦公室」(Office of Critical and Emerging Technologies) 總監表示,自 2010 年起,AI 模型的運算量每六個月就增加了一倍。該部門正試圖加快核准流程以確保電力資源的充足。

但伊隆·馬斯克 (Elon Musk) 並不打算乾等,他表示自己已經在美國田納西州孟菲斯 (Memphis) 打造了全球最大的資料中心,目前已有 10 萬個 GPU 上線,還有 10 萬很快就會跟上。與其等待電網連接,他在尚未獲得許可的情況下就安裝了 20 台天然氣渦輪發電機。

但即便馬斯克和其他人不顧一切地興建了龐大的基礎設施,他們仍須面對訓練資料不足的問題,而正如我們所見,這些問題可能說的比做的容易。

後記:代理式 AI 回歸

我們 8 月份的 AI Pulse 探討了「代理式 AI」的來臨,包括採用自主式 AI 代理的平台和解決方案。Salesforce 在上個月跟上了這波潮流,發表了「Agentforce」,該公司董事長暨執行長 Marc Benioff 將它描述為「一種革命性且值得信賴的解決方案,將 AI 無縫整合到每個工作流程當中,並將自己深深融入到客戶使用過程的核心。」 該公司在新聞稿中表示在 2025 年底之前,Agentforce 將擁有 10 億個代理,並指出:「這就是 AI 該有的樣子。」

更多來自趨勢科技的觀點

請參閱以下其他文章:

- [影片] AI 法規挑戰

- [電子報] 駕馭 AI 的黑暗面

- 發掘不受控的 AI

- [影片] Xday 2024: 非官方 AI 生存指南