Cyber-Kriminalität

Kognitives Hacking: Wahltäuschung im Zeitalter der AI

Beeinflussung durch falsche Fakten und Videos ist in den sozialen Medien inzwischen an der Tagesordnung. Mit Falschnachrichten steuern die Akteure politische Themen und Entscheidungen und stiften Angst und Misstrauen. Wie kann man gegensteuern?

Schlüsselgedanken

- Internet und die sozialen Medien ermöglichen die rasche Verbreitung von Fehlinformationen, AI-Tools verschärfen dies noch, indem sie die Produktion und Verbreitung von Desinformationen erleichtern.

- GenAI kann für die Erstellung von Deepfakes und Fake News missbraucht werden.

- Deepfake-Technologie stellt eine große Gefahr für die Integrität von Wahlen dar, da sie überzeugende manipulierte Inhalte erzeugt, die den Ruf schädigen, Desinformationen verbreiten und die öffentliche Meinung manipulieren können.

Wahlen sind der Grundpfeiler der modernen Demokratie, wobei die Bevölkerung ihren politischen Willen durch die Abgabe von Stimmzetteln zum Ausdruck bringt. Man muss sich heutzutage die Frage stellen: Spiegelt die Wahl unsere eigenen unabhängigen Entscheidungen wider oder werden sie von verdeckten Kräften beeinflusst, die unsere Entscheidungen manipulieren?

Propaganda ist nichts Neues, aber das Medium für die Verbreitung von Nachrichten und Informationen hat sich geändert von Print und Funk auf das Internet und soziale Medien. So können sich Fehlinformationskampagnen schnell etablieren. Diese Plattformen werden dazu missbraucht, um falsche Realitäten zu präsentieren, die nicht auf Fakten basieren. AI-Tools unterstützen heutzutage diese Kampagnen und erlauben es den Akteuren, Desinformationsinhalte schnell und in großem Umfang zu produzieren. Dabei geht es nicht nur um gefälschte Geschichten und Bilder, sondern auch um Fake Audio und Video (Deepfakes).

Meinungen formen und kapern

Der freie Gedankenaustausch ist für die persönliche Entwicklung und den gesellschaftlichen Fortschritt unerlässlich. Allerdings gibt es ethische und rechtliche Grenzen für das, was wir sagen oder tun können. Es ist die eine Sache, einen Standpunkt auf der Grundlage seiner Vorzüge zu argumentieren; es ist jedoch eine andere, mit „alternativen Fakten“ zu lügen.

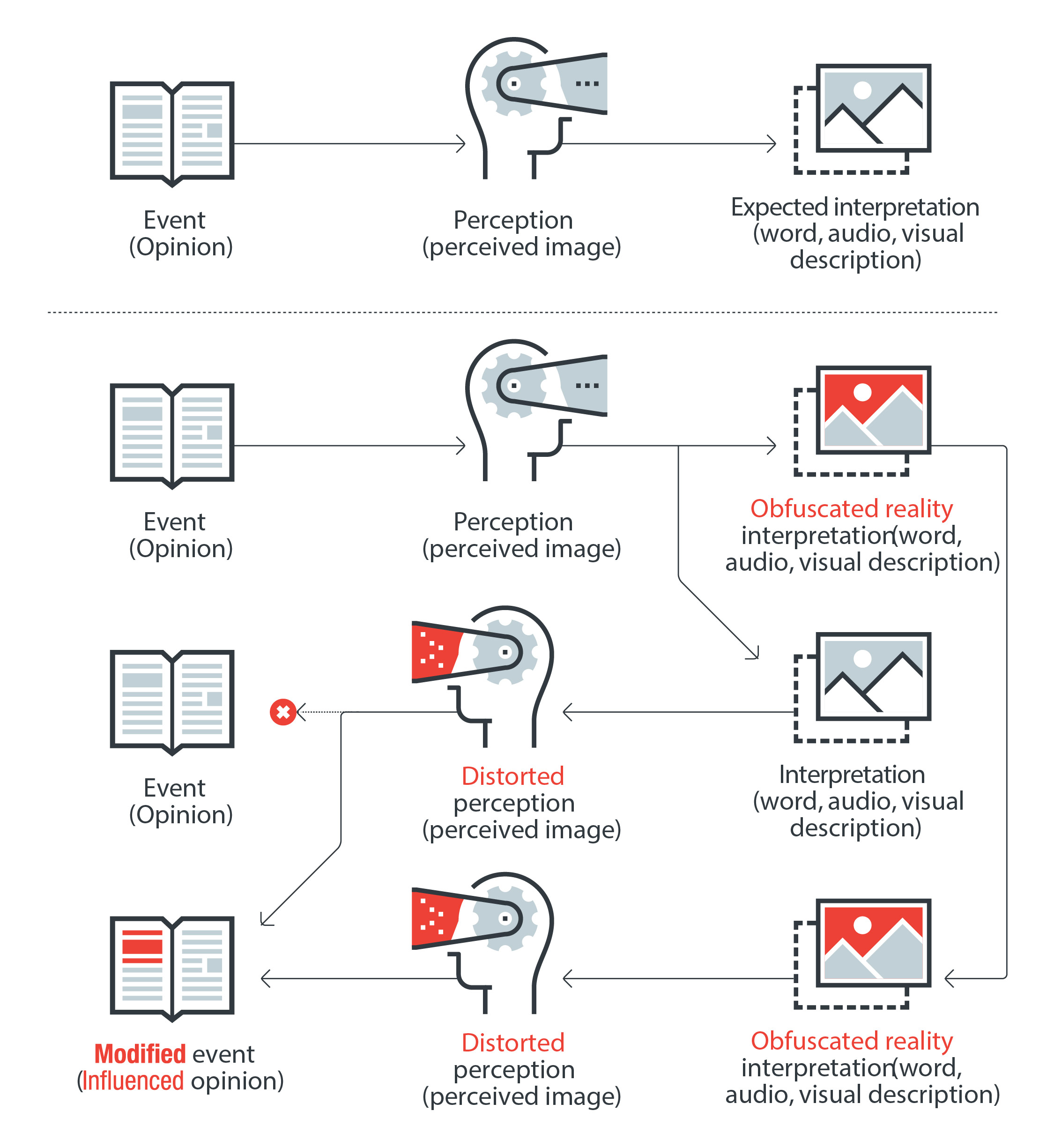

Meinungen werden durch die Wechselwirkung zwischen Informationen und unseren persönlichen Überzeugungen geformt. Propaganda nutzt diesen Prozess aus, indem sie Inhalte einspeist, die darauf abzielen, unsere Wahrnehmung durch provokative Schlagzeilen, hetzerische Tweets und Videos, die latente Vorurteile ausnutzen, zu verändern.

Wenn eine mehrgleisige Desinformationskampagne diese veränderte Wahrnehmung verstärkt, wird es immer schwieriger, zwischen Unwahrheiten und der Realität zu unterscheiden. An diesem Punkt kommt Leon Festingers Theorie der kognitiven Dissonanz ins Spiel, laut derer, Menschen bei einem als unangenehm empfundenen Gefühlszustand dazu neigen, nur die Informationen zu berücksichtigen, die mit ihrer verzerrten Realität übereinstimmen. Dies führt dazu, dass Menschen sich parteiische Podcasts anhören, obskure Nachrichten abonnieren und sich provokativen Online-Gruppen anschließen, alles in dem Bestreben, sich mit ihren Überzeugungen wohlzufühlen.

Dies kann als eine Form des kognitiven Hackings angesehen werden, bei dem das Ziel darin besteht, die Wahrnehmung einer Person zu verändern, anstatt sich mit Hacking Zugang zu einem Netzwerk zu verschaffen.

Die dunkle Seite von GenAI

Mittlerweile weiß man, dass GenAI auch ein breites Spektrum an digitalen, physischen und politischen Bedrohungen ermöglicht. Sie kann zur schnellen Erstellung von Fake News, zur Produktion von Deepfake-Videos und -Audios, zur Automatisierung von Hacking und zur Erstellung überzeugender Phishing-Nachrichten missbraucht werden. Ihre Fähigkeit, die öffentliche Meinung zu manipulieren, stellt eine Gefahr für die Validität von Wahlen dar. Dieser potenzielle Missbrauch von AI wird immer besorgniserregender, denn sie ist leicht verfügbar und benutzerfreundlich, selbst für diejenigen, die sich mit Technologie nicht auskennen, sie kann schnell Ergebnisse liefern, und sie kann in großem Maßstab eingesetzt werden.

AI-gesteuerte Bots generieren beispielsweise schnell überzeugende Fake-News und imitieren eine menschenähnliche Interaktion in sozialen Medien. Die Bots stellen eine erhebliche Bedrohung für die Fairness demokratischer Prozesse dar.

Techniken zur Generierung von Inhalten könnten Desinformationskampagnen verstärken, indem sie legitime mit falschen Informationen kombinieren und lernen, welche Arten von Inhalten am effektivsten sind und am häufigsten geteilt werden. Die Synthese aus Textinhalten lässt sich dazu verwenden, um Inhalte für gefälschte Websites zu generieren und einen bestimmten Schreibstil zu imitieren, z. B. eines Politikers oder Kandidaten, um betrügerische Aktivitäten durchzuführen.

Wie umfassend solche Kampagnen sein können, zeigt der Datenleak der kremlnahen „Social Design Agency“ (SDA). Demnach hat diese das Ziel, die westlichen Demokratien zu destabilisieren und Russlands Narrative zu verbreiten. Als Mittel nutzt sie Memes, Social Media-Posts und imitierte Webseiten etablierter Medien und öffentlicher Institutionen.

Indem Akteure wie die SDA gezielt die Wahrnehmung und die Meinungen der Bürger manipulieren, wirken sie auf Wahlergebnisse oder politische Entscheidungen deutlich ein. Beispielsweise beschreibt die SDA in ihren Zielen eine Erhöhung des Stimmenanteils der AfD auf 20 Prozent und die Zunahme der Zukunftsangst in Umfragen in Deutschland auf mehr als 50 Prozent.

Wie zielgerichtet das Vorgehen geplant wird, demonstrieren auch die 2023 geleakten „Vulkan Files“. Es geht um das für Beeinflussung entwickelte Programm „Amesit“ des russischen Software-Unternehmens Vulkan. Akteure, die Amesit nutzen, beginnen mit dem Sammeln von Information zu ausgewählten Themen auf Nachrichtenportalen und in den sozialen Netzwerken. Basierend auf diesen Informationen identifizieren sie geeignete Botschaften und Inhalte sowie Verbreitungskanäle für die zu platzierenden Inhalte. Amesit kann hierfür mindestens 100 verschiedene Konten in sozialen Netzwerken verwalten.

Auch Online-Petitionen werden von den Akteuren genutzt, wie etwa die Petitionswebseite Change.org bestätigt hat. Hier platzierten nachweislich russische Netzwerke beispielsweise Aufrufe für eine „unvoreingenommene Berichterstattung“ über den Krieg in der Ukraine.

Algorithmen unterstützen Filterblasen

In der täglichen digitalen Informationsflut ist kaum möglich, zu differenzieren, ob es sich bei öffentlich geposteten Tatsachen um Fehlinformationen, gezielte Desinformation oder Malinformation – absichtlich aus dem ursprünglichen Kontext gerissene Informationen – handelt. Zudem werden gehäuft Informationen aus gegensätzlichen Perspektiven verbreitet, was die Rezipienten in eine „Confirmation Bias“ (zu Deutsch: Bestätigungsfehlern) treibt. Sie unterstützen jene Informationen, die mit ihren eigenen Überzeugungen und Meinungen übereinstimmen, ohne den Wahrheitsgehalt näher zu prüfen. Darüber hinaus pushen die Algorithmen sozialer Netzwerke Themen, die augenscheinlich dem Interesse der Nutzer entsprechen, so dass diese nur noch mit ähnlichen Inhalten konfrontiert werden. Auf diese Weise entstehen „Filterblasen“, gegen die nur eine bessere Medienkompetenz hilft.

Das Schadenspotenzial von Deepfakes

Erst im vergangenen August deckte eine Untersuchung von CNN und dem Centre for Information Resilience (CIR) 56 falsche Konten auf X auf. Diese Konten waren Teil einer koordinierten Kampagne zur Förderung des Trump-Vance-Duos für die US-Präsidentschaftswahl 2024. Es gibt jedoch keine Hinweise darauf, dass die Trump-Kampagne daran beteiligt war. Die Untersuchung ergab ein konsistentes Muster nicht authentischer Aktivitäten. Alle Konten enthielten Bilder attraktiver, junger Frauen, von denen einige gestohlen waren, während andere von künstlicher Intelligenz generiert zu sein schienen. Die Bilder wurden oft manipuliert, um Trump- und MAGA-Slogans („Make America Great Again“) einzufügen.

Vorfälle wie diese tragen zu einer Art von Apathie bei, in der Menschen anfangen, an der Wahrhaftigkeit vieler Informationen, einschließlich Videos, die online verbreitet werden, zu zweifeln. Dies ist vielleicht das tiefgreifendste Problem, das Deepfakes mit sich bringen: ihr Potenzial, das Informationsökosystem zu destabilisieren und das Konzept einer gemeinsamen „Realität“ zunichte zu machen. Mit dem Aufkommen von Deepfakes kann jedes Video als Fälschung diskreditiert werden, was den Menschen einen Ausweg bietet, um sich der Verantwortung für ihr Handeln zu entziehen.

Selbst mit minimalen technischen Fähigkeiten können Kriminelle und politisch motivierte Akteure nun Bilder und Videos manipulieren. Die Kombination aus AI-generierten Deepfakes und den schnellen Verbreitungsmöglichkeiten kann Millionen Menschen schnell mit manipulierten Inhalten versorgen und so die öffentliche Meinung manipulieren, soziale Unruhen verbreiten und politisch polarisieren.

Was hilft gegen Manipulation?

Unsere wichtigste Verteidigung gegen die versuchte Manipulation besteht darin, unser Urteilsvermögen zu schärfen. Dies bedeutet, die Wahrhaftigkeit wahlbezogener Stories zu überprüfen und die weitere Verbreitung von Wahlfehlinformationen stoppen.

Kritisches Denken stellt die Authentizität von Nachrichten in Frage, indem es nach potenziellen Warnsignalen wie reißerischen Überschriften, verdächtigen Domains, schlechter Grammatik, veränderten Bildern, fehlenden Zeitstempeln und nicht zugewiesenen Daten Ausschau hält. Es heißt auch, über die Schlagzeilen hinaus zu blicken, die News mit anderen Nachrichtenagenturen abzugleichen, Links und Quellen zu hinterfragen, Autoren zu recherchieren, Bilder zu validieren und Faktenprüfer zu konsultieren. Wenn man die Entwicklung wichtiger Nachrichten im Laufe der Zeit beobachtet, so hilft das, die Zuverlässigkeit der Informationsquellen einzuschätzen.

Indem wir unsere Nachrichtenquellen diversifizieren, uns auf seriöse Medien konzentrieren und erst nachdenken, bevor wir etwas teilen, können wir dazu beitragen, die Verbreitung von wahlbezogenen Falschmeldungen zu bekämpfen.

Die Wachsamkeit der Anwender sollte sich nicht auf den Nachrichtenkonsum beschränken, sondern sich auf alle Kanäle erstrecken, die der Informationsbeschaffung dienen, wie SMS, Mails und Produktivitäts-Apps.

Zusätzlich können User Tools wie den kostenlosen Trend Micro Deepfake Inspector nutzen, der AI-basierte Gesichtserkennungstechnologie bei Live-Videoanrufen einsetzt. Diese Technologie kann AI-veränderte Inhalte identifizieren, die auf einen Deepfake-Versuch mit „Face Swapping“ im Zusammenhang hinzuweisen.